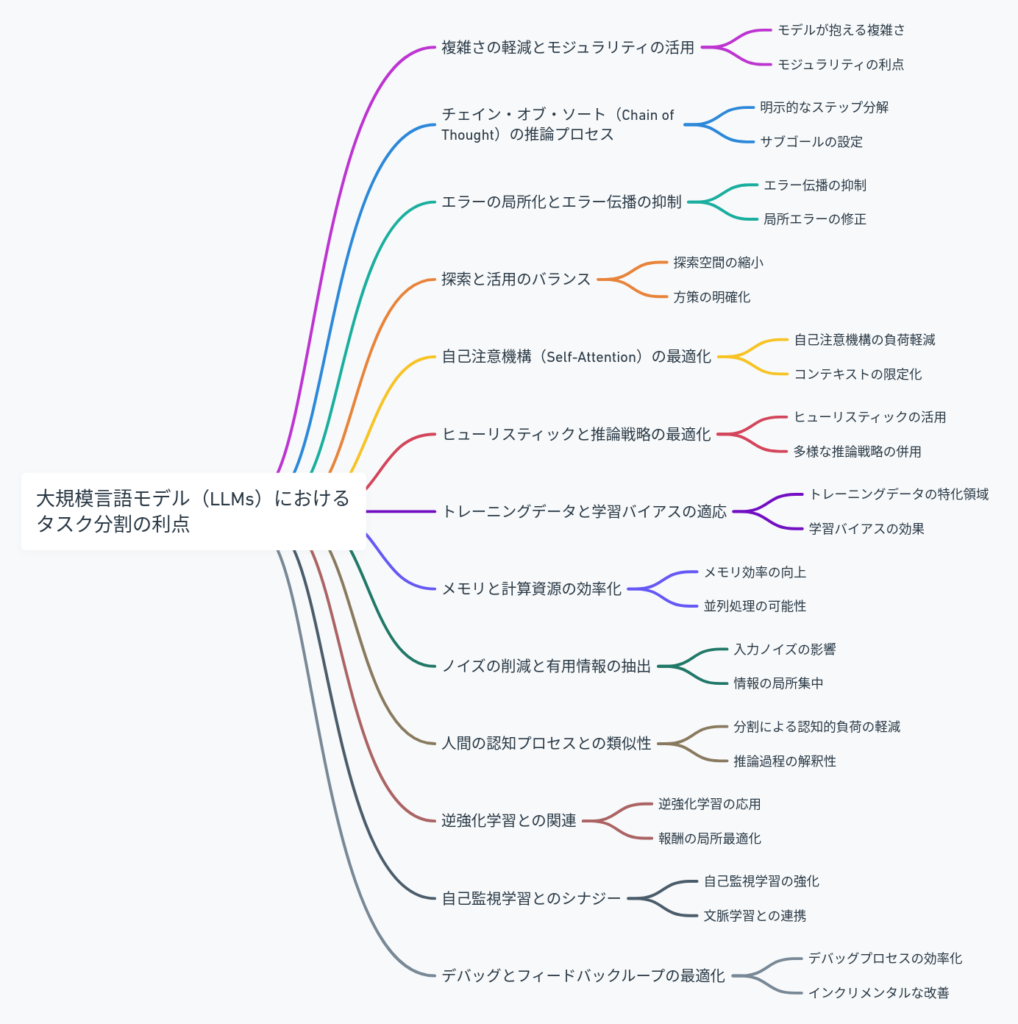

大規模言語モデル(Large Language Models, LLMs)に問題を分割して与えると正解率が上がる理由を、より専門的かつ深く掘り下げて説明します。ここでは、LLMの構造、処理メカニズム、そしてタスク分割による影響を、具体的な要素に分解して解説します。

1. 複雑さの軽減とモジュラリティの活用

モデルが抱える複雑さ

大規模言語モデルは、自己回帰的な構造(例えば、GPT系のモデル)を持っており、与えられた入力に対して逐次的にトークン単位で次のトークンを予測します。この予測過程は、入力全体を文脈として保持する必要がありますが、入力が複雑な問題や長文である場合、文脈の追跡が困難になります。特に長文の中で多くの依存関係や複数の意味論的解釈が必要になると、モデルは文脈を「うまく保持できない」ことが多く、正確な予測を行うのが難しくなります。

モジュラリティの利点

問題を小さな部分に分割することで、各部分が独立した処理単位(モジュール)としてモデルに提供されます。これにより、エージェントは各部分に特化した推論を行うことができ、それぞれの部分において文脈の追跡が容易になります。モジュラリティの活用は、各部分の処理を効率化し、全体のパフォーマンスを向上させる効果があります。さらに、これは並列処理に適しており、モデルの応答速度にも寄与します。

2. チェイン・オブ・ソート(Chain of Thought)の推論プロセス

明示的なステップ分解

問題を分割して逐次的に与える場合、「Chain of Thought」と呼ばれる推論プロセスが有効に機能します。これは、問題を細かく分解して解くことで、モデルが中間的な推論ステップを明示的に扱えるようにする手法です。たとえば、数学的な問題や論理パズルにおいては、直接解答を生成するのではなく、問題のステップを細かく辿ることがモデルの推論を助けます。

サブゴールの設定

ステップバイステップで問題を解くことは、モデルに対して一種の「サブゴール」を提供することになります。これにより、各ステップで特定の目標に到達するように最適化され、全体のタスクを達成するためのパフォーマンスが向上します。LLMは、一般的に大きな問題を解く際に「一貫したゴール」にたどり着くのが難しいため、分割されたサブゴールが推論を明確化し、最終的な解答の精度を高めます。

3. エラーの局所化とエラー伝播の抑制

エラー伝播の抑制

一度に複雑なタスク全体を解決しようとすると、初期の推論で発生したエラーが後続の推論に伝播しやすくなります。この現象は「エラー伝播」として知られ、特に長文や多段階の推論が必要なタスクにおいて顕著です。問題をサブタスクに分割することで、各サブタスクでのエラーが他のサブタスクに伝わりにくくなり、全体としてのエラーを抑制できます。

局所エラーの修正

さらに、サブタスクごとにエラーが発生した場合、そのエラーはサブタスクの範囲に局所化されるため、後続の推論には影響を及ぼしません。このように、分割されたタスク内でのエラーはモデルが再評価しやすく、個別に修正が可能となります。特に、動的計画法に基づくアプローチや逐次最適化では、サブゴールでの局所的なエラー修正が大幅に全体的なパフォーマンスを改善します。

4. 探索と活用のバランス(Exploration vs. Exploitation)

探索空間の縮小

タスクを分割すると、モデルが探索する必要のある空間が大幅に縮小されます。これにより、モデルが「探索」(Exploration)にかけるリソースを節約し、より「活用」(Exploitation)に焦点を当てることができるようになります。つまり、分割されたタスクごとに最適な解を探しやすくなるため、探索過程での誤りや不要な迂回を減少させ、より効率的な学習が可能となります。

方策の明確化

また、タスクを分割することにより、モデルが探索する方策(Policy)も明確化されます。方策は、エージェント(この場合はLLM)が各状態においてどのような行動を取るかを決定するルールですが、分割された問題においては、それぞれのサブタスクに対する最適な方策がより簡単に学習できます。これにより、複雑な全体タスクに対して最適な方策を見つけるための試行錯誤が減少し、効率が向上します。

5. 自己注意機構(Self-Attention)の最適化

自己注意機構の負荷軽減

大規模言語モデルの中心的なメカニズムである自己注意機構(Self-Attention)は、入力全体のすべてのトークン間の関係を計算しますが、入力が長くなるとその計算量が膨大になります。タスクを分割することで、モデルが一度に処理するトークン数が減り、自己注意機構の負荷が軽減されます。これにより、各トークン間の関係性をより正確に計算できるため、推論の精度が向上します。

コンテキストの限定化

また、タスクを小さく分割することで、モデルが扱うコンテキストが限定されます。LLMは、長い文脈を保持するのが難しく、特に重要な情報が埋もれることがあります。分割されたタスクでは、短いコンテキスト内で重要な情報が明確になり、モデルが必要な情報により集中できるようになります。

6. ヒューリスティックと推論戦略の最適化

ヒューリスティックの活用

問題を分割すると、特定のタスクに対して適切なヒューリスティック(経験則)を適用しやすくなります。たとえば、数学的な問題や計算問題では、特定のステップごとに適した計算法や推論戦略を使うことができます。モデルは、分割された問題に対してこれらのヒューリスティックを利用することで、より効率的に解を導き出すことができます。

多様な推論戦略の併用

大規模言語モデルは、単一の推論戦略に頼るのではなく、分割されたタスクごとに異なる推論戦略を用いることが可能です。たとえば、ある部分では統計的な推論が有効であり、別の部分では文法的推論が有効であるかもしれません。問題を分割することで、これらの異なる推論手法を適宜切り替えることができ、全体としてのパフォーマンスが向上します。

7. トレーニングデータと学習バイアスの適応

トレーニングデータの特化領域

LLMは膨大な量のテキストデータを用いて学習されていますが、その中には一般的なパターンだけでなく、細分化された特定のタスクに対しても学習が進んでいます。問題を分割することで、モデルが過去に学習したパターンの中から、各サブタスクに適した知識やパターンを利用しやすくなります。これにより、モデルは分割されたサブタスクに対して、より適した知識やパターンを活用でき、全体としての精度が向上します。

学習バイアスの効果

LLMのトレーニングプロセスでは、データに対するバイアスが生じることがあります。これらのバイアスは、モデルが特定の文脈やタスクに対してどのように予測するかに影響を与えますが、問題を分割することで、これらのバイアスの影響を局所的に制御できる可能性があります。分割されたサブタスクに対しては、モデルが最適なバイアスを利用できるため、全体のパフォーマンスにおける偏りや誤りを抑制することができます。

8. メモリと計算資源の効率化

メモリ効率の向上

大規模言語モデルが処理する際に問題となるのは、メモリリソースの制限です。特に大きなタスクや複雑な入力を処理する場合、モデルは膨大な量のメモリを消費します。問題をサブタスクに分割することで、一度に処理するデータ量が減り、メモリ使用量が効率化されます。これにより、モデルはより軽量な計算を行うことができ、応答速度の向上や大規模なデータセットへの対応が可能となります。

並列処理の可能性

さらに、タスク分割によって各サブタスクを独立して並列に処理できる可能性が生じます。これにより、モデルが複数のプロセスやコアで同時に推論を行うことが可能となり、結果として全体の処理時間が短縮され、応答性能が向上します。

9. ノイズの削減と有用情報の抽出

入力ノイズの影響

大規模言語モデルが入力データを処理する際、特に長い文脈や複雑なタスクにおいては、ノイズ(無関係な情報や不正確なデータ)の影響が顕著になることがあります。問題を分割することで、各サブタスクにおける文脈が短くなり、ノイズの影響を受けにくくなります。これにより、モデルはノイズを除外し、必要な情報に集中できるようになります。

情報の局所集中

サブタスクごとに有用な情報がより集中的に扱われることで、モデルが学習した情報を効果的に利用できます。例えば、特定の文脈におけるキーワードや重要な概念に対する注意が集中しやすくなるため、結果として推論精度が向上します。このプロセスは、自己注意機構(Self-Attention)の働きと密接に関連しています。

10. 人間の認知プロセスとの類似性

分割による認知的負荷の軽減

人間も複雑な問題を解決する際に、それを細かく分割して取り組む傾向があります。これは、認知的な負荷を軽減し、各部分に対する集中力を高めるためです。大規模言語モデルも、タスクを分割して処理することで、同様の効果を得ることができます。複雑な問題を全体として処理するのではなく、各部分に焦点を当てることで、モデルの「認知的リソース」がより効率的に使われ、誤りの少ない結果を導き出すことが可能です。

推論過程の解釈性

問題を分割して逐次的に解決するアプローチは、モデルの推論過程を人間が理解しやすくする利点もあります。各ステップでの推論結果が明示化されるため、どのようにして最終的な解答にたどり着いたのかが透明になります。これにより、モデルの出力結果の信頼性が向上し、応用面でも有効なフィードバックが得られます。

11. 逆強化学習との関連

逆強化学習の応用

問題を分割して解くアプローチは、逆強化学習(Inverse Reinforcement Learning, IRL)とも関連しています。IRLでは、エージェントが報酬関数を推定し、それに基づいて最適な行動を学習します。分割された問題においては、各サブタスクに対して適切な報酬関数を設定し、それに基づく最適な方策を選択することで、タスク全体の解決に向けたアプローチを逐次的に改善していきます。この方法は、特に報酬が明確でない問題に対して効果的です。

報酬の局所最適化

各サブタスクごとに明確な報酬を設定することで、モデルが逐次的に最適な行動を学習するのに役立ちます。これにより、全体的なタスク解決の過程が透明化され、効率的な解決策を導き出すことができます。

12. 自己監視学習(Self-Supervised Learning)とのシナジー

自己監視学習の強化

LLMは、自己監視学習を通じて巨大なデータセットから知識を学びます。この過程では、部分的なタスクに対する学習も多く含まれています。問題を分割することで、自己監視学習の際に学んだパターンやタスク分解に基づいた推論が効果的に活用されます。特に、分割されたタスクごとにモデルが過去に学習した似た問題を想起しやすくなるため、結果として正確な解答が得られます。

文脈学習との連携

さらに、文脈に基づく学習(Contextual Learning)とも深く関連しています。サブタスクごとに独立した文脈が設定されることで、モデルが文脈に基づく推論を強化し、より精度の高い回答を生成できるようになります。

13. デバッグとフィードバックループの最適化

デバッグプロセスの効率化

問題を分割することで、モデルの出力をデバッグする際の効率が大幅に向上します。各サブタスクごとに出力結果を評価することで、どの部分で誤りが生じたのかを特定しやすくなります。これにより、モデルの改善に向けたフィードバックループが効果的に機能し、最終的なタスク解決の成功率が上がります。

インクリメンタルな改善

タスクを分割することで、モデルの性能を段階的に改善できる余地が生まれます。特に、サブタスクごとの出力に基づいて、各ステップの方策やアルゴリズムを微調整し、全体的なパフォーマンスをインクリメンタルに向上させるアプローチが可能です。

まとめ

問題を大規模言語モデルに分割して与えると、正解率が向上する理由は、モデルの内部メカニズムや処理効率、推論戦略に関わる多くの要素が相互に作用しているためです。具体的には、複雑さの軽減、エラーの局所化、探索空間の縮小、メモリ効率の向上、ノイズ削減などの複数の要因が影響し、最終的に正確な解答を生成しやすくなります。また、人間の認知プロセスや逆強化学習、自己監視学習との関連からも、タスク分割の有効性が確認できます。これにより、モデルがより効率的に、かつ精度高く問題を解決する能力が向上するのです。