新時代のコンピューティング基盤に関する詳細レポート

エグゼクティブ・サマリー

人工知能(AI)、特に生成AIの指数関数的な進化は、世界のデジタルインフラストラクチャに地殻変動を引き起こしている。この変革の中核をなすのが「AIデータセンター」である。本レポートは、この新時代のコンピューティング基盤を巡る世界の動向について、技術、市場、地政学、そして環境という多角的な視点から詳細な分析を提供する。

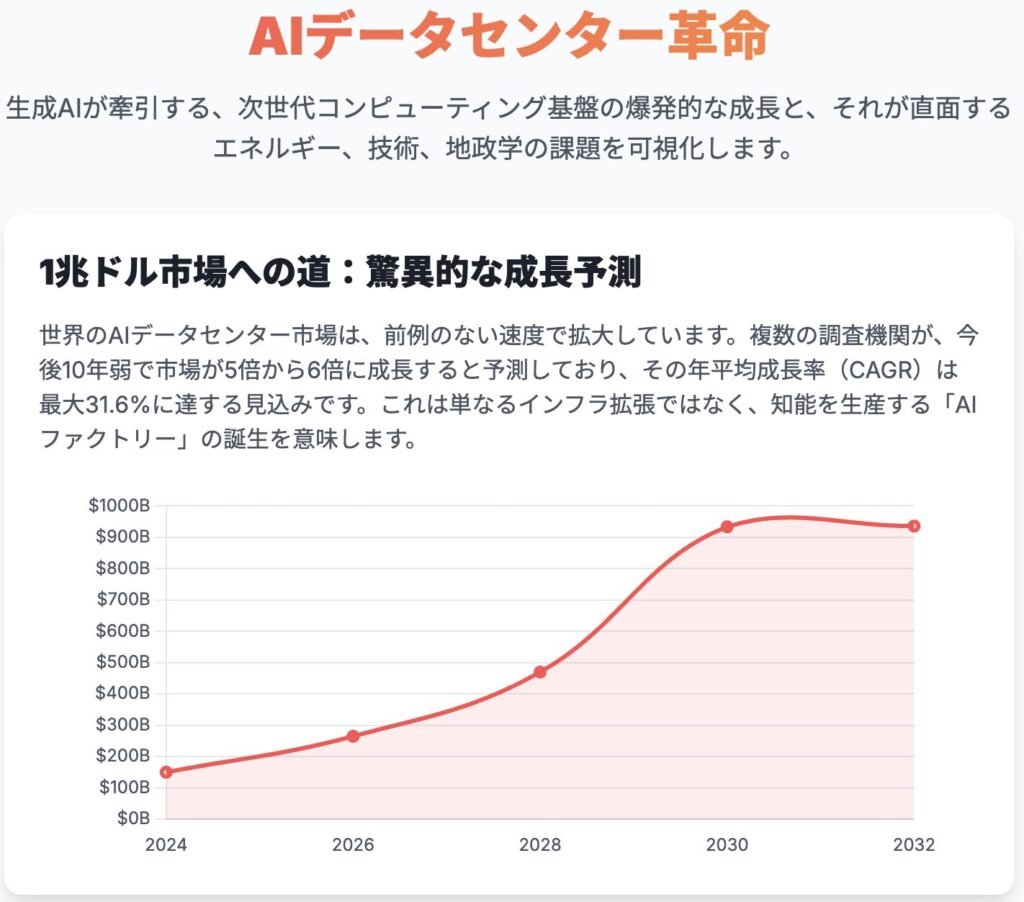

世界のAIデータセンター市場は、爆発的な成長期に突入している。各種調査機関の予測には幅があるものの、市場規模は2024年時点で1,500億ドルを超え、2030年代初頭には1兆ドル規模に迫ると見られている 1。これは既存のインフラの単純な拡張ではなく、コンピューティングのアーキテクチャそのものが根本的に再構築されることを意味する。

しかし、この急成長は業界全体に深刻な「トリレンマ」を突きつけている。第一に、AIモデルの高度化がもたらす無限とも思える計算能力への需要。第二に、その需要を満たすために必要となる膨大な電力と水資源が、世界のエネルギーインフラと環境に与える破壊的な負荷。そして第三に、地政学的に極めて脆弱な半導体サプライチェーンへの過度な依存である。

この複雑な状況下で、主要なステークホルダーはそれぞれ戦略的な岐路に立たされている。クラウドサービスを提供するハイパースケール企業にとっては、カスタムシリコン(独自設計半導体)開発による垂直統合が競争優位の源泉となっている。一般企業にとっては、複雑化するプロバイダーのエコシステムと多様な導入モデルをいかに航海するかが課題となる。そして各国の政府にとっては、技術革新の促進と、エネルギー安全保障やデータ主権といった規制要件とのバランスを取ることが、国家の競争力を左右する重要な政策課題となっている。

本レポートは、これらの動向を深く掘り下げ、AIデータセンターという巨大な潮流を理解するための戦略的指針を提示することを目的とする。

第1章 AIデータセンター革命:新時代のコンピューティング基盤

1.1 AIデータセンターの定義:従来型インフラとの決定的相違

AIデータセンターとは、大規模なAIモデルの学習や推論といった、AI特有のワークロードが要求する高性能コンピューティング需要をサポートするために特化して設計された施設である 2。これは、従来のデータセンターの単なる高性能版ではない。その設計思想、アーキテクチャ、そして物理的要件において、根本的な違いが存在する。

この本質的な違いは、コンピューティングの中心がCPU(中央演算処理装置)からGPU(画像処理装置)やTPU(テンソル処理装置)、カスタムASIC(特定用途向け集積回路)といったAIアクセラレータへと移行したことに起因する 1。汎用性を重視したCPU中心の設計から、特定の並列計算に特化したアクセラレータ中心の設計への転換は、データセンターのあらゆる側面に変革を強いている 5。

主な相違点は以下の三つに集約される。

- 計算密度(Compute Density): AIデータセンターでは、ラックあたりに多数のアクセラレータが高密度に実装される。これにより、1ラックあたりの消費電力は40kWから60kWを超え、将来的には130kW以上に達すると予測されている。これは、従来のデータセンターのラックが一般的に5kWから10kW程度であることと比較すると、桁違いの密度である 6。

- 電力供給と冷却システム(Power & Cooling): このような高密度実装は、膨大な熱を発生させる。従来の空冷方式では、この熱を効率的に除去することは物理的に不可能であり、技術的な限界に達している 4。そのため、熱伝導率が空気の数千倍高い液体を利用した液体冷却(直接チップ冷却や液浸冷却など)が、新たな標準技術として不可欠となっている 6。

- ネットワーク(Networking): 大規模なAIモデルの学習では、数千ものアクセラレータが協調して並列処理を行う。そのため、各アクセラレータ間を低遅延かつ超広帯域で接続するネットワーク・ファブリックが、システム全体の性能を決定づけるボトルネックとなる 5。ネットワークはもはや単なるユーティリティではなく、性能を左右する中核コンポーネントへとその役割を変えた。

これらの相違は、「データセンター」という概念そのものが二極化しつつあることを示唆している。一つは、従来の汎用的なIT負荷を処理するための施設。もう一つは、知能を生産するための高度に専門化された「AIファクトリー」である。このインフラの種分化は、不動産投資、サプライチェーン、運用ノウハウなど、関連するあらゆる産業に新たな専門化を促すだろう。

1.2 なぜ今、専用インフラが必要なのか:生成AIがもたらしたパラダイムシフト

AIデータセンターへの移行を加速させている直接的な要因は、大規模言語モデル(LLM)や拡散モデルに代表される生成AIの台頭である 3。これらのモデルは、従来のAIワークロードとは比較にならないほどの計算資源を要求する。数十億から数兆パラメータを持つモデルの学習には、ペタバイト級のデータを使い、数千個の高性能チップを数週間から数ヶ月にわたって稼働させ続ける必要がある 4。

これは単なる量的な変化ではなく、コンピューティング要件における質的な「ステップチェンジ」である。従来のデータセンターの設計では、このような大規模なAIワークロードを経済的かつ技術的に実行することは不可能であり、専用のインフラストラクチャの構築が不可避となった 8。この文脈でAIデータセンターを捉えるとき、それは単なるデータ保管・処理施設ではなく、「サービスとしてのスーパーコンピュータ」と再定義するのがより正確である。そのアーキテクチャ原理—大規模並列処理、高速インターコネクト、特殊化された計算ノード—は、従来、学術研究機関などが独占していたハイパフォーマンス・コンピューティング(HPC)の世界から直接的に引き継がれたものである。決定的な違いは、その計算能力が特定の研究目的ではなく、クラウドを通じて柔軟なサービスとして提供されるビジネスモデルにある。この視点は、なぜこれほど巨額の設備投資が行われ、各社がカスタムハードウェアとソフトウェアスタックの構築に戦略的に注力しているのかを説明する上で不可欠である。

第2章 世界市場のダイナミクスと成長軌道

2.1 市場規模の現状と将来予測:複数の調査に基づく統合的分析

世界のAIデータセンター市場は、前例のない規模と速度で拡大している。ただし、市場の定義がまだ流動的であるため、調査機関によってその評価額には大きなばらつきが見られる。

表1:世界のAIデータセンター市場に関する予測比較(2024年~2032年)

| 調査機関 | 2024/2025年 市場規模(10億ドル) | 2030/2032年 予測規模(10億ドル) | 予測期間 | 年平均成長率(CAGR) |

| Fortune Business Insights 1 | 150.2 (2024年) | 936.0 (2032年) | 2025-2032 | 26.8% |

| MarketsandMarkets 2 | 167.8 (2024年) | 933.8 (2030年) | 2025-2030 | 31.6% |

| Grand View Research 11 | 13.6 (2024年) | 60.5 (2030年) | 2025-2030 | 28.3% |

注:予測値の大きな差異は、市場範囲の定義(例:AIサーバーハードウェアのみか、建設・電力・冷却インフラを含むか)の違いに起因する可能性が高い。

これらの数値の差異にもかかわらず、全ての調査は共通して、今後10年弱で市場が5倍から6倍に成長するという驚異的な見通しを示しており、その年平均成長率(CAGR)は約27%から32%の範囲に収斂している。市場の構成要素としては、特にコンピュートサーバーやAIアクセラレータを含むハードウェアセグメントが最大のシェアを占めている 1。

この市場規模評価の大きなばらつきは、単なるデータの不一致ではなく、市場そのものが持つ重要なシグナルと解釈すべきである。これは、AIデータセンターという領域がまだ黎明期にあり、その定義や境界線が確立されていないことを示している。ハードウェア、ソフトウェア、建設、エネルギーといった、これまで別個に存在していた産業が急速に融合し、一つの巨大なエコシステムを形成しつつある「カンブリア爆発」的状況を反映している。投資家にとって、これは莫大な機会と同時に、市場構造が固まるまでの高いリスクが存在することを意味する。

2.2 成長を牽引する主要因:AIワークロードの爆発的増加と産業DXの深化

市場の急成長を支える根本的な原動力は、あらゆる産業分野におけるAIワークロードの爆発的な需要増加である。医療、金融、製造、自動車といった基幹産業からエンターテインメントに至るまで、デジタルトランスフォーメーション(DX)の深化がAIの活用を不可欠なものにしている 2。

この根源的な需要を増幅させる、いくつかの重要な触媒が存在する。

- ビッグデータの増大: IoTデバイス、ソーシャルメディア、企業の基幹システムなどから生成されるデータ量が爆発的に増加しており、これがAIモデルを学習させるための「燃料」となっている 14。

- AI-as-a-Service (AIaaS) の普及: クラウドプロバイダーが提供するAIaaSプラットフォームにより、中小企業でも巨額の初期投資なしに高度なAI機能を利用できるようになった。これにより、AI活用の裾野が広がり、需要が民主化されている 2。

- 政府による投資: 各国政府はAIを国家戦略の柱と位置づけ、米国の「CHIPS and Science Act」のような大規模な投資プログラムを通じて、AIインフラの開発を積極的に後押ししている 2。

- ハイパースケール企業の巨額投資: Google、Amazon、Microsoftといった巨大テック企業による設備投資が、市場全体の基盤的なキャパシティを創出している。Microsoft、Amazon、Google、Meta、Appleの5社合計の投資額は、2025年だけで4,500億ドルを超えると予測されている 6。

特にAIaaSの普及は、強力なフィードバックループを生み出している。ハイパースケール企業がインフラ容量を増強するほど、AIへのアクセス単価は低下する。これにより、より多くの企業がAIを導入し、新たなデータと、より高度なモデルへの需要が生まれる。その結果、ハイパースケール企業はさらなるインフラ増強を迫られる。この自己強化サイクルは、もし世界的に普及するキラーアプリケーションが登場した場合、現在の高い成長予測ですら保守的である可能性を示唆している。

第3章 地域別ランドスケープと戦略的動向

世界のAIデータセンター市場は、地域ごとに異なる戦略的優先事項と地政学的力学によって形成されており、画一的なグローバル市場として捉えることはできない。大きく分けて、北米、アジア太平洋、欧州の三つの「データ圏」が形成されつつある。

3.1 北米:技術革新と巨額投資が牽引する支配的市場

北米、特に米国は、AIデータセンター市場において議論の余地のない支配的な地位を占めている。2024年から2025年にかけて世界の市場シェアの36.6%を占め、世界のハイパースケールAIデータセンターの51%がこの地域に集中している 6。米国内には5,300を超えるデータセンターが存在し、他国を圧倒している 16。

この優位性は、以下の要因が複合的に作用した結果である。

- ハイパースケール企業の集積: Google、Amazon、Microsoft、Meta、NVIDIAといった、AIインフラへの投資を主導する巨大テック企業の本拠地である 2。

- 強力な政府支援: 総額2,800億ドルの権限が与えられた「CHIPS and Science Act」のような政策は、国内の半導体製造能力を強化し、AI分野における米国のリーダーシップを維持することを目的としており、有利な投資環境を創出している 11。

- 成熟したイノベーション・エコシステム: AI研究、ベンチャーキャピタル、スタートアップ企業が一体となった成熟したエコシステムが、最先端のコンピューティングに対する継続的な需要を生み出している 11。

- インフラ集積地: バージニア州北部は「データセンター横丁」として知られ、3,500万平方フィートに及ぶ巨大な集積地を形成している。ただし、近年では電力供給の制約から、オハイオ州コロンバスのような二次市場への開発シフトも進んでいる 6。

3.2 アジア太平洋:急成長する巨大市場と地政学的変数

アジア太平洋(APAC)地域は、最も高い成長率が予測される市場である。そのCAGRは35.1%に達すると見られ、急速なデジタル化、政府主導のAIイニシアチブ、そして膨大なデータを持つ人口がその成長を牽引している 2。

この地域の中でも、中国と日本は特に注目すべき動向を示している。

中国の野心と制約:

中国は、米国の輸出規制に対抗するため、AI技術の自給自足(セルフリライアンス)を国家目標に掲げ、猛烈な勢いでインフラを構築している。新疆ウイグル自治区に480億ドルを投じて巨大なデータセンターハブを建設するなど、国家主導のプロジェクトが進行中である 21。同時に、Huaweiの「Ascend」シリーズのような国産AIチップの開発に注力し、NVIDIAへの依存からの脱却を図っている 22。しかし、最先端の半導体チップ(NVIDIA製)や製造装置へのアクセスが制限されていることが、依然として深刻なボトルネックとなっている 22。Alibaba、Tencent、ByteDanceといった巨大テック企業は、規制対象のチップを可能な限り備蓄しつつ、この複雑な地政学的状況に対応している 22。

3.2.1 日本市場の詳細分析:政府主導の地方分散化と技術戦略

日本のAI最適化データセンター市場は、2025年の6,490万ドルから2030年には2億750万ドルへと、CAGR 26.14%で成長すると予測されている 26。また、国内のデータセンター全体の供給容量は、2023年末から2025年末にかけて1.4倍に増加する見込みである 27。

日本の戦略の最大の特徴は、政府が主導する地方分散化政策にある。現在、国内データセンターの約90%が首都圏と近畿圏に集中しているが、政府はこれを北海道などの地方へ分散させることを強力に推進している 28。この政策の背景には、災害リスクの軽減と、電力供給が逼迫する大都市圏の負荷軽減という二つの目的がある。

この戦略を具体化するのが、「ワット・ビット連携(Watt-Bit Collaboration)」と呼ばれる官民連携フレームワークである。これは、新たなデータセンターをクリーンエネルギー源の近くに併設(コロケーション)することを目指すもので、デジタル変革(DX)とグリーン変革(GX)の両立を図る野心的な試みである 28。さらに政府は、分散型データセンターアーキテクチャに不可欠な高速ネットワークを実現するため、光と電子を融合させる「光電融合技術」の開発に補助金を拠出するなど、技術面からの支援も行っている 29。この日本の「ワット・ビット連携」モデルは、AIインフラが抱えるエネルギー問題を根本的に解決しうる、世界的に見ても重要な先行事例と言える。成功すれば、データセンターを単なる電力消費者から、再生可能エネルギープロジェクトの資金調達を可能にする「アンカーテナント(核となる賃借人)」へと転換させ、データセンター産業と再生可能エネルギー産業双方の経済性を根本から変える可能性を秘めている。

3.3 欧州:データ主権(GAIA-X)とサステナビリティを巡る独自の道

欧州市場の成長は、デジタル変革の進展に支えられているが、その方向性は「データ主権」「プライバシー」「サステナビリティ」という三つの強力な価値観によって独自に規定されている 11。

- 規制主導の市場形成: GDPR(一般データ保護規則)や今後のAI法といった厳格な規制が、データセンターの立地選定や設計、運用に大きな影響を与えている 31。

- GAIA-Xイニシアチブ: 欧州連合(EU)が主導するこのプロジェクトは、米国のハイパースケール企業への依存を低減し、連合的で安全、かつ主権を保ったデータインフラを構築することを目的としている 33。新たな巨大クラウドプロバイダーを創設するのではなく、共通のルールと標準に基づいた信頼できるエコシステムの形成を目指す点が特徴である 36。

- サステナビリティの義務化: EUのエネルギー効率指令(EED)は、一定規模以上の新規データセンターに対し、技術的・経済的に可能な限り廃熱を回収・再利用することを義務付けている。これにより、地域暖房などへの活用を含む循環型経済モデルの導入が促進されている 38。

- 主要国: データセンターの数では、ドイツ(529拠点)、英国(523拠点)、フランス(322拠点)が欧州をリードしている 41。

これらの地域ごとの動向は、世界が三つの異なる戦略的優先事項を持つ「データ圏」へと分断されつつあることを示している。北米は純粋な性能と資本主義的競争によって、中国を中心とするアジア太平洋は国家主導の技術的自立によって、そして欧州は規制と社会全体の価値観(プライバシー、持続可能性)によって、それぞれが異なる進化の道を歩んでいる。グローバル企業にとって、これは「ワンサイズ・フィッツ・オール」のデータセンター戦略がもはや通用しないことを意味し、各データ圏の支配的な価値観に合わせた地域ごとの戦略の最適化が不可欠となる。

表2:地域別AIデータセンター戦略の比較分析

| 項目 | 北米 | アジア太平洋 | 欧州 |

| 主要な推進力 | 技術革新、ハイパースケール企業の巨額投資 | 急速なデジタル化、国家主導の技術自給自足 | データ主権、プライバシー規制、サステナビリティ |

| 政府の主要イニシアチブ | CHIPS and Science Act | 中国製造2025、日本の「ワット・ビット連携」 | GAIA-X、GDPR、AI法、エネルギー効率指令 |

| 主要プレイヤー/ハブ | Google, AWS, Microsoft, NVIDIA / バージニア州、シリコンバレー | Alibaba, Tencent, Huawei / 中国、日本、シンガポール | Deutsche Telekom, OVHcloud / ドイツ、フランス、オランダ |

| 中心的な課題 | 電力供給の逼迫、送電網の遅延 | 最先端半導体へのアクセス制限、地政学的緊張 | 厳格な規制遵守、非欧州企業への依存 |

第4章 AIインフラを支える技術基盤

AIデータセンターの性能と効率は、コンピューティング、冷却、ネットワークという三つの技術的支柱の上に成り立っている。これらの分野における技術革新が、AIの能力を飛躍的に向上させている。

4.1 コンピューティング:GPU、TPU、カスタムASICが織りなす覇権争い

AIワークロードの中核をなすのは、膨大な量の行列演算を高速に処理する能力である。この能力を巡り、異なるアーキテクチャを持つ半導体チップが覇権を争っている。

- GPU (Graphics Processing Units): 現在、AIアクセラレータ市場を支配しているのは、NVIDIAが率いるGPUである。元々はグラフィックス処理のために開発されたが、その大規模な並列処理アーキテクチャがAIの計算タスクに最適であったため、AI分野でデファクトスタンダードとなった 42。特に、NVIDIAが10年以上にわたって構築してきたCUDAソフトウェア・エコシステムは、他社が容易に追随できない強力な「堀(moat)」を形成している 45。

- TPU (Tensor Processing Units): Googleが独自に設計したASICであり、ニューラルネットワークの演算に特化して最適化されている。特に、Googleが開発した機械学習フレームワークであるTensorFlowやJAXとの親和性が高い 42。TPUは「シストリックアレイ」と呼ばれる独自のアーキテクチャを採用しており、行列演算において極めて高い効率を発揮する。これにより、特定のワークロードにおいてはGPUを上回るコストパフォーマンスとエネルギー効率を実現する可能性がある 46。

- その他のカスタムASIC: ハイパースケール企業による垂直統合の動きが加速しており、各社が独自のAIチップ開発を進めている。

- AWS: 学習用の「Trainium」と推論用の「Inferentia」という二本柱で、AWSエコシステム内でのコストと性能の最適化を図っている 50。

- Microsoft: 戦略的パートナーであるOpenAIと共同で設計した「Maia AI Accelerator」を開発。AzureのAIサービスの中核に据え、NVIDIAへの依存度を低減することを目指している 53。

この「チップ戦争」は、単なる性能競争ではない。それは、アーキテクチャの主導権とエコシステムのロックインを巡るプラットフォーム戦略そのものである。ハイパースケール企業が巨額の資金を投じてカスタムASICを開発する真の目的は、単なるコスト削減に留まらない。NVIDIAのCUDAエコシステムという強力なロックインから脱却し、シリコンからサービスに至るまで、自社で完全にコントロール可能な垂直統合された技術スタックを構築することにある。これは、IT業界の歴史において繰り返されてきたプラットフォーム覇権争いが、半導体レベルで繰り広げられていることを意味する。

4.2 冷却システム:空冷から液体冷却へ、高密度化が促す技術革新

AIアクセラレータの高密度実装は、データセンターの熱管理に革命を強いている。

- 空冷の物理的限界: 従来の空冷方式は、AIラックが発生させる膨大な熱量に対して、もはや十分な冷却能力を提供できない 4。熱伝達の物理法則が、より効率的な冷却媒体への移行を不可避なものとしている。

- 液体冷却の台頭: 液体は空気の数千倍の熱吸収効率を持つため、高密度AIデータセンターの冷却ソリューションとして急速に普及している 6。新規に建設されるAIデータセンターでは、液体冷却がデフォルトの標準となりつつあり、新規施設の73%が採用しているとの統計もある 6。

- 主要な冷却技術:

- 直接チップ冷却 (Direct-to-Chip, D2C): GPUやCPUといった発熱体の直上に「コールドプレート」と呼ばれる金属板を設置し、その内部に冷却液を循環させる方式。現在最も一般的な液体冷却手法である 56。

- 液浸冷却 (Immersion Cooling): サーバー全体を、電気を通さない特殊な液体(誘電性流体)に直接浸す方式 57。

液体冷却への強制的な移行は、データセンターの地理的配置と設計思想を根本から変える可能性がある。既存の施設を液体冷却に対応させるための改修は技術的に複雑でコストもかかるため 59、業界は必然的に、目的に合わせて新規に建設する「グリーンフィールド」プロジェクトを優先するようになる。これにより、データセンターの立地選定基準が、従来のインターネット接続性から、安価で豊富な電力と水資源へのアクセスへとシフトする。冷却システムが、今や立地を決定する主要因の一つとなり、第3章で述べた地方分散化の動きをさらに加速させるだろう。

4.3 ネットワーク:AIクラスターを支える超高速・低遅延インターコネクト

大規模なAI学習クラスターの性能は、個々のGPUの計算速度だけでなく、数千のGPU間でいかに高速にデータを交換できるかによって決まる。多くの場合、ネットワークがシステム全体の性能を規定するボトルネックとなる 5。

この課題に対応するため、AIデータセンターでは、従来のデータセンターで用いられる標準的なイーサネットとは異なる、特殊なネットワーク技術が採用される。NVIDIAのNVLinkやInfiniBandといった技術は、GPU間の直接通信を可能にし、超広帯域とマイクロ秒単位の低遅延を実現する。

将来的には、電子スイッチングの限界を超えるため、光技術の活用が不可欠となる。光インターコネクトは、光信号のままスイッチングを行うことで、電子的な変換に伴う遅延と電力消費を排除し、桁違いの通信性能を実現する可能性を秘めている 60。

表3:主要AIアクセラレータの比較分析

| アクセラレータ種別 | 主要ベンダー | コアアーキテクチャ | 主な用途 | 強み | 弱み・制約 |

| 汎用GPU | NVIDIA (H100/B200) | 大規模並列プロセッサ | AI学習・推論、HPC | 強力なCUDAソフトウェアエコシステム、高い汎用性 | 高コスト、高い消費電力、サプライチェーンの脆弱性 |

| 特化型TPU | Google (TPU v5/Trillium) | シストリックアレイ | ニューラルネットワーク学習・推論 | 特定ワークロードでの高い電力効率とコスト効率 | Googleエコシステムへの依存、汎用性の低さ |

| カスタム推論ASIC | AWS (Inferentia 2) | – | AI推論 | 低遅延・高スループット、AWSサービスとの統合 | 学習には不向き、AWSプラットフォームへのロックイン |

| カスタム学習ASIC | AWS (Trainium) | – | AI学習 | 大規模分散学習でのコスト効率 | 推論には不向き、AWSプラットフォームへのロックイン |

| カスタム汎用AI ASIC | Microsoft (Maia) | – | AI学習・推論 | OpenAIワークロードへの最適化、Azureとの垂直統合 | 新規参入であり実績が少ない、エコシステムが未成熟 |

第5章 競争エコシステムと主要プレイヤーの投資戦略

AIデータセンター市場は、クラウドサービスを提供する巨大企業(ハイパースケール企業)を中心に、激しい競争が繰り広げられている。各社は、独自の半導体開発による垂直統合を核とした、数十億ドル規模の投資戦略を展開している。

5.1 クラウド・ジャイアンツの垂直統合戦略

ハイパースケール企業は、NVIDIAのような外部の半導体メーカーへの依存を減らし、自社のサービスに最適化されたパフォーマンスとコスト効率を実現するため、独自のAIチップ開発に巨額の投資を行っている。

5.1.1 AWS:TrainiumとInferentiaによるフルスタック支配

- 戦略: AWSは、カスタムシリコンからクラウドサービスまでを自社で一貫して手掛ける垂直統合戦略を推進している。これにより、NVIDIAへの依存を低減し、総所有コスト(TCO)の最適化を目指す 51。

- チップ: コスト効率の高い学習を実現する「Trainium」と、高スループット・低遅延の推論に特化した「Inferentia」という、用途を明確に分けた二つのチップラインを持つ 51。特にInferentia2は、前世代と比較して最大4倍のスループットと最大10倍の低遅延を謳っている 50。

- 投資: インディアナ州のデータセンターへの110億ドルの投資に加え、自社チップを中心とした学術研究エコシステムを育成するため、1億1,000万ドル規模の「Build on Trainium」プログラムを立ち上げている 6。

5.1.2 Microsoft Azure:OpenAIとの同盟とMaiaチップによる追撃

- 戦略: 戦略的パートナーであるOpenAIとの強固な同盟関係を軸に、AIに最適化されたインフラ容量を爆発的に拡大する戦略を採る。その中核を担うのが自社開発のカスタムシリコンである 53。

- 投資: 2028年までにAIデータセンターの拡張に800億ドルという驚異的な額を投じる計画を発表している 53。

- チップ: OpenAIと共同で設計・テストされた「Maia 100」AIアクセラレータが戦略の中心に位置する。このチップは、専用設計のラックと、それに付随する特注の液体冷却ユニット「サイドキック」と一体で導入される 54。今後3年間でNVIDIAへの依存度を25%削減することが目標とされている 53。

5.1.3 Google Cloud:TPUによる先行者利益とエコシステムの拡大

- 戦略: 10年以上にわたるTPUへの先行投資を活かし、性能とコスト面での優位性を確立する。これにより、高価なNVIDIA製GPUに依存することなく、いわゆる「NVIDIA税」を回避する 49。この垂直統合戦略が、近年、主要なパートナーを引きつける魅力となっている。

- チップ: 歴代の「TPU」(v5e, v5p, Trillium)は学習と推論の両方に最適化されており、優れたワットパフォーマンスとコストパフォーマンスを実現している 47。アナリストは、GoogleのTPU運用コストはGPUベースの代替案と比較して約20%低いと推定している 49。

- 市場での勝利: これまで他社のクラウドを利用していたMeta(100億ドル規模の契約)やOpenAIといった巨大顧客が、TPUの利用を目的として一部のワークロードをGoogle Cloudに移行させるという、市場の勢力図を塗り替える契約を獲得している 49。

これら三社の戦略は、垂直統合という点で共通しているが、そのアプローチには微妙な差異がある。Googleは、自社サービス(検索など)の内部的な必要性から早期にTPU開発に着手した「純粋なインテグレーター」である。AWSは、巨大なパブリッククラウド事業全体のコストと性能を最適化するために後発で参入した「現実的なインテグレーター」と言える。そしてMicrosoftは、OpenAIという王者を擁立するための強力なパートナーシップを原動力とする「同盟主導のインテグレーター」であり、その戦略の成否はこの単一のパートナーシップに大きく依存している。これらの異なる出自と戦略は、各社の将来の競争力と弱点を形作ることになるだろう。

5.2 エコシステムのキープレイヤー:NVIDIAの優位性とコロケーション事業者の役割

- NVIDIA: 市場の支配的プレイヤーであり続けるが、ハイパースケール企業のカスタムチップ開発という挑戦に直面している。また、製造をTSMCに依存するファブレスモデルのため、サプライチェーンの制約が常にリスクとして存在する 67。その競争優位の源泉は、ハードウェアの性能以上に、長年かけて築き上げたCUDAソフトウェアプラットフォームにある 45。

- Equinix: 大手コロケーション事業者として、AI対応インフラをサービスとして提供することで、エコシステムにおいて重要な役割を果たしている。Equinixの戦略は、自社のグローバルなデータセンター網(45以上の都市、100以上の拠点)に高度な液体冷却ソリューションを配備し、企業が自前で施設を建設することなく高密度AIコンピューティングにアクセスできるようにすることである 58。これは、自社運用(オンプレミス)とハイパースケールクラウドの中間に位置する、重要な選択肢を提供する。

Equinixのような事業者が提供する高性能なAI対応コロケーションサービスの台頭は、「ソブリンAI(主権AI)」の隆盛を支える基盤となりうる。米国のハイパースケール企業への過度な依存を懸念する国家や大企業は、中立的な第三者から最先端の物理インフラを借り受け、その上で独自のナショナルAIクラウドやコーポレートAIクラウドを構築することが可能になる。これは単なるスペースと電力の提供ではなく、技術的主権を構成するための「ビルディングブロック」の提供に他ならない。

表4:主要クラウドAIインフラプロバイダーの戦略比較

| 項目 | AWS | Microsoft Azure | Google Cloud |

| 独自開発チップ | Trainium (学習), Inferentia (推論) | Maia (学習・推論) | TPU (学習・推論) |

| 公表投資額 (2025-2028) | 数百億ドル規模(個別非公表) | 800億ドル | 数百億ドル規模(個別非公表) |

| コア戦略 | フルスタックの垂直統合によるTCO最適化 | OpenAIとの強力な同盟によるエコシステム主導 | TPUの先行者利益を活かした性能・コスト優位性 |

| 主要パートナー | – (自社エコシステム中心) | OpenAI, NVIDIA | Meta, OpenAI, NVIDIA |

| 競争優位性 | 広範なクラウドサービスとの統合、コスト効率 | 生成AI市場での先行者(OpenAI)との独占的連携 | 10年以上のカスタムシリコン開発経験、コスト構造 |

第6章 エネルギーのトリレンマ:電力、持続可能性、コスト

AIデータセンターの指数関数的な成長は、世界のエネルギーインフラに前例のない負荷をかけており、「電力供給」「持続可能性」「コスト」という三つの要素が相互に絡み合う複雑なトリレンマを生み出している。

6.1 危機的状況にある電力需要:IEA予測が示す未来

- 爆発的な需要増: 国際エネルギー機関(IEA)は、世界のデータセンターの電力需要が2030年までに倍増し、約945テラワット時(TWh)に達すると予測している。これは、現在の日本全体の年間電力消費量をわずかに上回る規模である 72。

- AIが最大の牽引役: この需要増の最大の要因はAIであり、AI専用データセンターの電力需要だけでも2030年までに4倍以上に増加すると見られている 72。

- 地域への深刻な影響: 米国では、2030年までの電力需要増加分のほぼ半分をデータセンターが占めると予測されている 74。すでに、新規データセンター建設において、最大で4年にも及ぶ送電網の整備遅延が深刻なボトルネックとなっている 6。

このAIブームは、先進国において数十年にわたり続いてきた電力需要の横ばい、あるいは減少傾向を、単独で覆すほどのインパクトを持っている 74。これは、既存の電力網や発電計画が想定していなかった事態であり、電力事業者や政府にとって深刻な危機をもたらしている。AI産業の成長は、今やエネルギーインフラの増強ペースによって直接的に制約される状況にあり、テック企業、電力会社、政府の間で、これまでにない規模での連携が不可欠となっている。

6.2 持続可能な電力供給への道:再生可能エネルギー、PPA、そして小型モジュール炉(SMR)

増大し続ける電力需要を、いかにして持続可能な形で満たすか。業界は、複数のソリューションを同時に追求している。

- 再生可能エネルギーとPPA: テック企業は、太陽光や風力といった再生可能エネルギーを確保するため、大規模な電力購入契約(PPA)を積極的に締結している。しかし、これらのエネルギー源は天候に左右されるため、24時間365日の稼働が求められるデータセンターの安定した電力供給源としては、単独では課題が残る 76。

- 原子力の選択肢 – SMR: そこで、クリーンかつ信頼性の高い24時間稼働のベースロード電源として、小型モジュール炉(SMR)に対する関心が急速に高まっている 76。

- 定義: SMRは、最大出力300MW程度の先進的な原子炉であり、工場での製造とモジュール単位での建設が可能なように設計されている 81。

- 主要な契約: Googleはテネシー州で先進的な原子炉を開発するKairos PowerとPPAを締結。Microsoftは、再稼働するスリーマイル島原子力発電所からの電力でデータセンターを稼働させる契約を結んだ。AmazonはSMR開発企業のX-energyに共同投資している 77。

- 課題: SMR技術はまだ開発段階にあり、本格的な商業展開には15年から20年かかると見られているため、短期的な解決策にはなり得ない 82。

巨大テック企業によるSMRへの関与は、重要なエネルギーインフラ戦略が民間主導で進められていることを示している。政府や従来の電力会社の対応を待てないテック企業が、自社のバランスシート(長期PPAによる資金保証)を活用して次世代原子力の開発リスクを軽減し、資金を提供している。彼らは事実上のエネルギー分野のパイオニアとなり、自社の事業ニーズを満たすために未来の電力網の姿を形成している。これは、将来的に「ビッグテック」がエネルギーセクターの一部を実質的にコントロールするという、新たな規制上の課題を生む可能性がある。

6.3 究極の効率化:廃熱利用と循環型経済モデルの構築

- 未開拓の資源: データセンターで消費される電力のほぼ全ては、最終的に低温の熱に変換され、そのほとんどが大気中に排出され無駄になっている 39。

- 地域暖房への活用: この廃熱を回収し、近隣の住宅や商業施設に熱を供給する「地域暖房」システムに活用する取り組みが、特に欧州で進んでいる 84。これにより、データセンター事業者は新たな収益源を確保できると同時に、地域全体の暖房システムの二酸化炭素排出量を劇的に削減できる 84。

- 先進事例: Microsoftはフィンランドで、都市全体の暖房をデータセンターの廃熱で賄うプロジェクトを進めている。スウェーデンのストックホルム・データパークは、廃熱ゼロを目指している 86。

第7章 地政学的リスクと規制の潮流

AIデータセンターのエコシステムは、グローバルなサプライチェーンと各国の規制という、二つの大きな外部要因に強く影響される。特に、米中間の技術覇権争いと、データ主権を巡る各国の法整備は、インフラの設計と運用に深刻な影響を及ぼしている。

7.1 半導体サプライチェーンの脆弱性:米中対立とNVIDIAへの依存

- NVIDIA-TSMCのボトルネック: 現在、世界の最先端AIチップの大部分は、米国のNVIDIAが設計し、台湾のTSMCが製造している 68。この極端な集中は、台湾海峡を巡る地政学的緊張に対して極めて脆弱な単一障害点(Single Point of Failure)を生み出している。

- 米国の輸出規制: 米国政府は、中国のAI技術開発を遅らせることを目的として、NVIDIAのH100のような高性能AIチップや関連する製造装置の対中輸出を段階的に厳格化している 23。これは、AIを国家安全保障上の重要技術と見なす、意図的な政策である 22。

- 中国の対抗策: 中国は、国家を挙げて半導体の自給自足体制の構築を目指している。Huawei(Ascendチップ)やSMIC(製造)といった国内企業に巨額の資金を投じているが、技術的にはまだ数世代遅れているのが現状である 22。国内のテック企業は、規制が強化される前に、可能な限り高性能チップの在庫を確保しようと動いている 21。

米国の輸出規制は、中国を減速させるという意図とは裏腹に、皮肉にも西側技術とは完全に独立した、独自のAI技術スタックの形成を加速させている。最先端ツールへのアクセスを断たれた中国企業は、HuaweiのAscendチップやMindSporeフレームワークといった国内の代替技術への投資と標準化を余儀なくされる。これは、かつてのモバイルOSにおけるiOSとAndroidのような、二つの互換性のないエコシステムへと世界が分岐する可能性を示唆しており、その地政学的な影響は計り知れない。

7.2 データ主権の壁:グローバルAIとローカル規制の相克

- 基本原則: データ主権とは、データが収集・保管された国の法律および統治構造に従うべきであるという概念である 87。

- 規制の影響: 欧州のGDPR、中国の個人情報保護法(PIPL)、インドのデジタル個人データ保護法(DPDPA)といった規制は、国境を越えるデータ移転に厳しい制限を課している 31。これは、世界中から集めたデータセットを中央集権的なデータセンターで学習させるという、従来のLLM開発モデルと直接的に対立する。

- アーキテクチャへの影響: 企業は、データが生成された国内にデータを留める「データレジデンシー」や「データローカライゼーション」といった要件を遵守するため、AIインフラの設計変更を迫られている。具体的には、各国に小規模なデータセンターを建設したり、機密データを国内に留めつつクラウドの計算資源を活用するハイブリッドクラウド・アーキテクチャを採用したりする必要がある。これは、グローバルなAIシステムの設計思想を根本から変えるものである 31。

データ主権規制は、コンプライアンスを法的な負担から、アーキテクチャ革新の推進力へと変えつつある。データをローカルで処理する必要性は、後述するエッジAIの成長を促す主要な触媒となっている。先進的な企業は、これらの規制を単なる障壁と見なすのではなく、設計思想そのものとして取り込んでいる。そして、低遅延やプライバシー強化といった付加価値を、コンプライアンス対応の副産物ではなく、競争優位性として提供する、分散型の「ソブリン・バイ・デザイン」なシステムを構築し始めている 31。

第8章 AIデータセンターの未来像

AIデータセンターは、今後も技術的、建築的に進化を続ける。その未来像は、より分散化され、よりインテリジェントで、そして持続可能なエコシステムへと向かっている。

8.1 アーキテクチャの進化:エッジAIとハイブリッドクラウドの融合

- エッジAI: 全てのデータを中央のクラウドに送るのではなく、データが生成される場所(IoTデバイス、工場、店舗など)の近くでAI処理を行うアプローチ 90。

- 推進要因: 自動運転車や産業オートメーションのような、リアルタイムの応答(低遅延)が不可欠なアプリケーションの需要増加。また、データをローカルに留めることでデータ主権規制に対応する必要性も、エッジAIの普及を後押ししている 93。

- ハイブリッド・アーキテクチャ: 時間的制約が厳しい推論やデータの前処理は「エッジ」で実行し、大規模なモデル学習やデータ集約は中央の「クラウド」で行うモデル。この「両方の世界の良いとこ取り」をするアプローチは、性能、コスト、コンプライアンスの全てを最適化する未来の標準アーキテクチャと見なされている 96。

エッジAIの台頭は、中央集権的なデータセンターの終焉を意味するものではない。むしろ、その役割を再定義するものである。中央のデータセンターは、巨大な基盤モデルを学習させるための「頭脳」あるいは「鋳造所」として、その重要性をさらに増すだろう。一方で、エッジは、それらのモデルが物理世界とリアルタイムで対話するための「神経系」となる。これは競争関係ではなく、階層的で共生的な関係であり、今後10年のデジタルインフラのトポロジーを定義することになる。

8.2 次世代技術の胎動:フォトニクスとニューロモーフィックコンピューティング

現在の電子技術に基づくコンピューティングは、エネルギー効率と速度の面で物理的な限界に近づいている。その先を見据えた、革命的な技術の研究開発が進められている。

- ニューロモーフィック・フォトニクス: 人間の脳の構造と情報処理メカニズムにヒントを得た「ニューロモーフィック」コンピューティング・アーキテクチャと、光の速度と帯域幅を利用する「フォトニクス」技術を融合させるアプローチ 100。

- 潜在能力: これらの技術は、現在のシステムが抱える制約を打破し、桁違いの速度とエネルギー効率で計算を実行する可能性を秘めている。実現すれば、AIの消費電力を劇的に削減できると期待されている 100。研究はまだ初期段階だが、AIハードウェアの長期的な未来を指し示している。

8.3 究極の目標:自律的で持続可能なデータセンターエコシステムの実現

AIデータセンターが目指す究極の姿は、自己最適化能力を持つ、持続可能なエコシステムである。

- 電力: SMRや地熱発電といった24時間稼働可能なクリーンエネルギー源を含む、多様なポートフォリオによって電力が供給される 79。

- 循環型設計: 廃熱は、地域暖房や工業プロセスに利用するために地域経済に完全に統合される 85。水は閉ループシステムで管理され、消費が最小限に抑えられる 53。

- 運用におけるAI活用: AI自身が、データセンターの運用をあらゆる側面から最適化する。ワークロードの動的な配置、冷却システムのリアルタイム制御、故障予測保全などを通じて、さらなる効率化を推進する 40。

SMRやフォトニクスといった次世代技術に支えられた、持続可能で自律的なデータセンターという長期的なビジョンは、この産業が、電力や水道と同様に、社会にとって不可欠な新しい種類の「ユーティリティ」へと進化していく軌道上にあることを示唆している。それは、社会の基盤となる「計算能力」という資源を供給する、高度に規制された資本集約的な産業となるだろう。これは、将来的には政府による監督の強化、設計の標準化、そしてこれらの施設の巨大な社会的影響を管理するための官民パートナーシップの増加を意味するかもしれない。

第9章 戦略的分析と提言

本レポートの分析に基づき、主要なステークホルダーに対して以下の戦略的提言を行う。

- テック企業およびハイパースケール企業へ:

- コストと性能をコントロールするため、カスタムシリコン開発による垂直統合戦略をさらに加速させるべきである。

- 将来の電力供給を確保するため、SMRを含むクリーンエネルギー源に関する長期的な電力購入契約(PPA)を積極的に追求すべきである。

- データ主権とハイブリッドクラウドを前提としたアーキテクチャ設計を初期段階から組み込むことが不可欠である。

- AIを導入する一般企業へ:

- 特定のベンダーへのロックインを避けるため、マルチクラウドまたはハイブリッドクラウド戦略の採用を検討すべきである。

- 自社施設(オンプレミス)でのAI導入を視野に入れ、将来必要となる電力および冷却要件の計画に早期に着手すべきである。

- データ主権規制への対応を単なるコストとしてではなく、顧客からの信頼を構築するための戦略的機会として捉えるべきである。

- 投資家へ:

- データセンター市場が「従来型」と「AI特化型」に二極化していることを認識すべきである。

- 投資機会は、半導体メーカーやクラウドプロバイダーだけでなく、このAIゴールドラッシュを支える「つるはしとシャベル」の供給者、すなわち液体冷却の専門企業、電力インフラ関連企業、データセンターに特化した不動産投資信託(REIT)などにも存在する。

- 政策立案者へ:

- 目前に迫るエネルギー危機に積極的に対処するため、新規のクリーンエネルギープロジェクトや送電網の増強に関する許認可プロセスを合理化・迅速化すべきである。

- 日本の「ワット・ビット連携」のような官民パートナーシップを奨励し、データセンターを地域エネルギー計画の中核に据えるべきである。

- 国際的な摩擦を減らし、責任ある技術革新を促進するため、データ主権やAIの安全性に関する明確で調和の取れた国際基準の策定を主導すべきである。

引用文献

- AIデータセンター市場規模、共有|グローバル成長レポート[2032] https://www.fortunebusinessinsights.com/jp/ai%E3%83%87%E3%83%BC%E3%82%BF%E3%82%BB%E3%83%B3%E3%82%BF%E3%83%BC%E5%B8%82%E5%A0%B4-110845

- AI Data Center Market Size, Share and Industry Report, 2025 To 2030 https://www.marketsandmarkets.com/Market-Reports/ai-data-center-market-267395404.html

- AIデータセンター市場 | 市場規模 シェア 動向分析 予測 2025~2030年まで https://www.gii.co.jp/report/grvi1726179-ai-data-center-market-size-share-trends-analysis.html

- AIデータセンターとは?従来型との違いと企業の課題 https://blog.css-net.co.jp/entry/2024/11/06/095843

- 【AIインターコネクトの基本】AI時代のデータセンターネットワークはこう作る – BUSINESS NETWORK https://businessnetwork.jp/article/27883/

- 25+ AI Data Center Statistics & Trends (2025 Updated) – The Network Installers https://thenetworkinstallers.com/blog/ai-data-center-statistics/

- 生成AIが現代のデータセンターをどのように変革するか – FS.com https://www.fs.com/jp/blog/what-generative-ai-means-for-data-centers-26550.html

- AWS rolls out liquid cooling in data centers – About Amazon https://www.aboutamazon.com/news/aws/aws-liquid-cooling-data-centers

- 2025 Global Data Center Outlook – JLL https://www.jll.com/en-us/insights/market-outlook/data-center-outlook

- AI時代を支えるデータセンターとは?拡大の背景と冷却問題の解決策 – 株式会社バーテック https://burrtec.co.jp/datacenter/useful_content/ai-data-center/

- AI Data Center Market Size, Share | Industry Report, 2030 https://www.grandviewresearch.com/industry-analysis/ai-data-center-market-report

- AWS doubles investment in AWS Generative AI Innovation Center, marking two years of customer success | Artificial Intelligence https://aws.amazon.com/blogs/machine-learning/aws-doubles-investment-in-aws-generative-ai-innovation-center-marking-two-years-of-customer-success/

- AI がデータセンターを変革させる https://www.principalglobal.jp/sites/default/files/2024-06/%E3%80%90%E3%83%97%E3%83%AA%E3%83%B3%E3%82%B7%E3%83%91%E3%83%AB%E3%80%91AI%E3%81%8C%E3%83%87%E3%83%BC%E3%82%BF%E3%82%BB%E3%83%B3%E3%82%BF%E3%83%BC%E3%82%92%E5%A4%89%E9%9D%A9%E3%81%95%E3%81%9B%E3%82%8B.pdf

- AI Data Center Global Market Forecast Report 2025-2030 | Rising Adoption of Green AI Data Centers and Increasing Demand for Hyperscale Data Centers Fueling Opportunities – ResearchAndMarkets.com – Business Wire https://www.businesswire.com/news/home/20250813077581/en/AI-Data-Center-Global-Market-Forecast-Report-2025-2030-Rising-Adoption-of-Green-AI-Data-Centers-and-Increasing-Demand-for-Hyperscale-Data-Centers-Fueling-Opportunities—ResearchAndMarkets.com

- AI Data Centers Are Coming for Your Land, Water and Power – CNET https://www.cnet.com/tech/services-and-software/features/ai-data-centers-are-coming-for-your-land-water-and-power/

- 第8節 データセンター市場及びクラウドサービス市場の動向 https://www.soumu.go.jp/johotsusintokei/whitepaper/ja/r07/pdf/n2180000.pdf

- 令和6年版 情報通信白書|データセンター – 総務省 https://www.soumu.go.jp/johotsusintokei/whitepaper/ja/r06/html/nd218100.html

- CHIPS and Science Act – Wikipedia https://en.wikipedia.org/wiki/CHIPS_and_Science_Act

- White House Unveils Comprehensive AI Strategy: “Winning the Race: America’s AI Action Plan” | White & Case LLP https://www.whitecase.com/insight-alert/white-house-unveils-comprehensive-ai-strategy-winning-race-americas-ai-action-plan

- Data Center Market Size, Share & Trends | Growth Report [2032] – Fortune Business Insights https://www.fortunebusinessinsights.com/data-center-market-109851

- China’s $48B Desert Data Center Plan to Beat the US Chip Ban – YouTube https://www.youtube.com/watch?v=sKnPkL4021c

- Leashing Chinese AI Needs Smart Chip Controls – RAND https://www.rand.org/pubs/commentary/2025/08/leashing-chinese-ai-needs-smart-chip-controls.html

- China’s drive toward self-reliance in artificial intelligence: from chips to large language models | Merics https://merics.org/en/report/chinas-drive-toward-self-reliance-artificial-intelligence-chips-large-language-models

- Full Stack: China’s Evolving Industrial Policy for AI – RAND https://www.rand.org/pubs/perspectives/PEA4012-1.html

- Why China’s AI breakthroughs should come as no surprise | World Economic Forum https://www.weforum.org/stories/2025/06/china-ai-breakthroughs-no-surprise/

- 日本の人工知能(AI)最適化データセンター市場規模・シェア分析 – Mordor Intelligence https://www.mordorintelligence.com/ja/industry-reports/japan-artificial-intelligence-ai-data-center-market

- 【生成AI革命】データセンター市場は2025年末までに1.4倍に拡大する – Energy Tracker Japan https://www.energytracker.jp/20240819_economy_generative-ai/

- AI Data Centre Development in Japan and Clean Energy Transition https://energytracker.asia/ai-data-centre-development-in-japan-and-clean-energy-transition/

- Japan Targets Rural Data Center Expansion with Photonics https://w.media/japan-targets-rural-data-center-expansion-with-photonics/

- Behind rise of Japan’s data centersーNHK WORLD-JAPAN NEWS – YouTube https://www.youtube.com/watch?v=0O7mDIYXeZw

- The Strategic Role of Data Sovereignty in AI – Exasol https://www.exasol.com/blog/data-sovereignty-ai/

- AI data residency regulations and challenges – InCountry https://incountry.com/blog/ai-data-residency-regulations-and-challenges/

- FAQs on the GAIA-X project – BMWE https://www.bundeswirtschaftsministerium.de/Redaktion/EN/FAQ/Data-Infrastructure/faq-projekt-gaia-x.html

- Gaia-X: a European initiative for increased digital sovereignty – TNO https://www.tno.nl/en/digital/data-sharing/gaia-digital-sovereignty/

- What is GAIA-X and What Do I Need To Know? – Squire Patton Boggs https://www.squirepattonboggs.com/-/media/files/insights/publications/2020/11/what-is-gaia-x-and-what-do-i-need-to-know/what-is-gaia-x-and-what-do-i-need-to-know.pdf

- Full article: European ambitions captured by American clouds: digital sovereignty through Gaia-X? – Taylor & Francis Online https://www.tandfonline.com/doi/full/10.1080/1369118X.2025.2516545

- together towards a federated & secure data infrastructure – Gaia-X https://gaia-x.eu/wp-content/uploads/2025/04/Gaia-X-Brochure_Overview_ONLINE_April-2025_V2.pdf

- Towards Planet Proof Computing: Law and Policy of Data Centre Sustainability in the European Union | Technology and Regulation https://techreg.org/article/view/19844

- AI and Heat Pumps: How Data Centers are Shaping the Future of Energy, according to the IEA in a New Report https://heatpumpingtechnologies.org/ai-and-heat-pumps-how-data-centers-are-shaping-the-future-of-energy-according-to-the-iea-in-a-new-report/

- Turn waste heat into clean heat with District Energy | Danfoss https://www.danfoss.com/en/about-danfoss/our-businesses/climate-solutions/waste-heat/

- 欧州でのAIの発展におけるデータセンター動向とエネルギー状況 | 地域・分析レポート – ジェトロ https://www.jetro.go.jp/biz/areareports/2025/e9739fc38756bd8d.html

- TPU vs GPU: Choosing the Right Hardware for Your AI Projects | DigitalOcean https://www.digitalocean.com/resources/articles/tpu-vs-gpu

- GPU vs. TPU: Which is the best option for AI in the cloud? – Madrid Tech Show https://www.techshowmadrid.es/en/noticias/gpu-vs-tpu-cual-es-la-mejor-opcion-para-la-ia-en-la-nube

- Does All AI Workload Requires GPUs? An Exploration of Cost-effective Alternatives https://pidatacenters.com/does-all-ai-workload-requires-gpus

- Google’s Decade Long Bet on Custom Chips Is the AI Wild Card Wall Street Hasn’t Priced In, Profitable Businesses Will Run on ASICs, Not GPUs, GPT-5 making it move? : r/investing – Reddit https://www.reddit.com/r/investing/comments/1mlui74/googles_decade_long_bet_on_custom_chips_is_the_ai/

- TPU architecture | Google Cloud https://cloud.google.com/tpu/docs/system-architecture-tpu-vm

- Tensor Processing Units (TPUs) – Google Cloud https://cloud.google.com/tpu

- Ask a Techspert: What’s the difference between a CPU, GPU and TPU? https://blog.google/technology/ai/difference-cpu-gpu-tpu-trillium/

- The Untold Infrastructure Advantage That Could Propel Google Ahead of OpenAI in AI Development – Investopedia https://www.investopedia.com/google-s-infrastructure-secret-11781657

- AWS Inferentia – AI Chip https://aws.amazon.com/ai/machine-learning/inferentia/

- Amazon’s Custom ML Accelerators: AWS Trainium and Inferentia – CloudOptimo https://www.cloudoptimo.com/blog/amazons-custom-ml-accelerators-aws-trainium-and-inferentia/

- Navigating AI evolution with AWS Inferentia and Trainium – Impetus https://www.impetus.com/resources/blog/navigating-ai-evolution-with-aws-inferentia-and-trainium/

- Microsoft’s $80B Investment in AI Data Centers: the Digital Backbone for a Multimodal World https://www.datacenters.com/news/microsoft-s-80b-investment-in-ai-data-centers-the-digital-backbone-for-a-multimodal-world

- With a systems approach to chips, Microsoft aims to tailor everything ‘from silicon to service’ to meet AI demand – Source https://news.microsoft.com/source/features/ai/in-house-chips-silicon-to-service-to-meet-ai-demand/

- Microsoft unveils Maia 100 AI accelerator chip and Cobolt 100 CPU – Tech Monitor https://techmonitor.ai/technology/silicon/microsoft-azure-maia-100-ai-chip-cobolt-100-cpu

- Liquid Cooling Technology in Data Centers: How It Supports AI Workloads – YouTube https://www.youtube.com/watch?v=bIo_nRp8rvQ

- The basics of liquid cooling in AI data centers – Flex Power Modules https://flexpowermodules.com/the-basics-of-liquid-cooling-in-ai-data-centers

- Equinix to Accelerate and Simplify Liquid Cooling Deployments to Power Enterprise AI Workloads https://www.equinix.com/newsroom/press-releases/2023/12/equinix-to-accelerate-and-simplify-liquid-cooling-deployments-to-power-enterprise-ai-workloads

- A guide to data center cooling: Future innovations for sustainability – Digital Realty https://www.digitalrealty.com/resources/articles/future-of-data-center-cooling

- A Survey on Optical Interconnects for Data Centers – ResearchGate https://www.researchgate.net/publication/220003086_A_Survey_on_Optical_Interconnects_for_Data_Centers

- Chapter 18. Optical interconnection networks for high-performance systems – Lightwave Research Laboratory https://lightwave.ee.columbia.edu/sites/default/files/content/publications/2019/Optical%20interconnection%20networksfor%20high-performance%20systems.pdf

- AWS Trainium Research https://aws.amazon.com/ai/machine-learning/trainium/research/

- The golden opportunity for American AI – Microsoft On the Issues https://blogs.microsoft.com/on-the-issues/2025/01/03/the-golden-opportunity-for-american-ai/

- Microsoft introduces Maia 100, its first chip for AI – The AI Track https://theaitrack.com/microsoft-maia-100/

- Google’s $10B Meta Cloud Deal: A Game-Changer for AI-Driven Cloud Growth – AInvest https://www.ainvest.com/news/google-10b-meta-cloud-deal-game-changer-ai-driven-cloud-growth-2508/

- Google Cloud’s $10B Meta Deal: A Strategic Masterstroke in the AI Infrastructure Race https://www.ainvest.com/news/google-cloud-10b-meta-deal-strategic-masterstroke-ai-infrastructure-race-2508/

- ‘My main purpose coming here is…’: CEO Jensen Huang visits Taiwan as Nvidia looks to stop H20 AI chips production https://timesofindia.indiatimes.com/technology/tech-news/nvidia-asks-foxconn-and-other-suppliers-to-stop-production-of-h20-chips-as-ceo-jensen-huang-visits-tsmc-says-my-main-purpose/articleshow/123448981.cms

- Nvidia and TSMC: How The Chip Supply Chain Really Works – KAP Limited https://kaplimited.in/nvidia-and-tsmc-how-the-chip-supply-chain-really-works

- Nvidia’s Supply Chain Shifts and Their Impact on China’s Economy – HROne https://hrone.com/blog/nvidias-supply-chain-shifts-and-their-impact-on-chinas-economy/

- Liquid cooling enters the mainstream in data centers – JLL https://www.jll.com/en-us/insights/liquid-cooling-enters-the-mainstream-in-data-centers

- Future-Proof Your Enterprise AI Strategy with Your AI Factory Powered by NVIDIA DGX https://blog.equinix.com/blog/2025/03/18/future-proof-your-enterprise-ai-strategy-with-your-ai-factory-powered-by-nvidia-dgx/

- AI to quadruple data center electricity demand by 2030-IEA https://www.districtenergy.org/blogs/district-energy/2025/04/15/ai-to-quadruple-data-center-electricity-demand-by

- AI set to drive doubling of electricity demand from data centres https://iifiir.org/en/news/ai-set-to-drive-doubling-of-electricity-demand-from-data-centres

- AI is set to drive surging electricity demand from data centres while offering the potential to transform how the energy sector works – News – IEA https://www.iea.org/news/ai-is-set-to-drive-surging-electricity-demand-from-data-centres-while-offering-the-potential-to-transform-how-the-energy-sector-works

- Energy demands from AI datacentres to quadruple by 2030, says report – The Guardian https://www.theguardian.com/technology/2025/apr/10/energy-demands-from-ai-datacentres-to-quadruple-by-2030-says-report

- Why AI data centres are eyeing up nuclear – Energy Voice https://www.energyvoice.com/renewables-energy-transition/nuclear/576307/ai-data-centres-nuclear-smr/

- AI goes nuclear: Can small modular reactors meet AI’s energy demands? – PreScouter https://www.prescouter.com/2025/01/can-small-modular-reactors-address-ai-growing-energy-demands/

- White paper argues for SMRs over renewables for data centers – American Nuclear Society https://www.ans.org/news/article-6460/white-paper-argues-for-smrs-over-renewables-for-data-centers/

- Google, Kairos, and TVA Unlock Advanced Nuclear Energy for America’s AI Data Centers https://carboncredits.com/google-kairos-and-tva-unlock-advanced-nuclear-energy-for-americas-ai-data-centers/

- Nuclear Power Emerging as a Clean AI Data Center Energy Source – Beth Kindig – Medium https://beth-kindig.medium.com/nuclear-power-emerging-as-a-clean-ai-data-center-energy-source-233ab5afd4de

- Fueling the Future: Nuclear Power in Data Centers – Globant Blog https://stayrelevant.globant.com/en/technology/data-ai/sustainability-data-centers-nuclear-power-research-tech-policy/

- Powering the future: can Small Modular Reactors support data center energy needs? https://datacenteruniversity.be/powering-the-future-can-small-modular-reactors-support-data-center-energy-needs/

- Powering the AI revolution: are data centers going nuclear? – Third Bridge https://www.thirdbridge.com/en-us/about-us/media/perspectives/powering-the-ai-revolution-are-data-centers-going-nuclear

- How Data Centres Can Become Heat Heroes | Digitalisation World https://digitalisationworld.com/blog/58287/how-data-centres-can-become-heat-heroes

- Data center and district heating: an outstanding combination – ARANER https://www.araner.com/blog/data-center-and-district-heating-an-outstanding-combination

- Here’s how data centre heat can warm your home – The World Economic Forum https://www.weforum.org/stories/2025/06/sustainable-data-centre-heating/

- The future of AI is sovereign: Why data sovereignty is the key to AI innovation https://news.broadcom.com/sovereign-cloud/the-future-of-ai-is-sovereign-why-data-sovereignty-is-the-key-to-ai-innovation

- Understanding Data Sovereignty – CoreSite https://www.coresite.com/blog/understanding-data-sovereignty

- Data Sovereignty vs Data Residency vs Data Localization in the AI Era – Uvation https://uvation.com/articles/data-sovereignty-vs-data-residency-vs-data-localization-in-the-ai-era

- Improving Telecommunications with Edge AI https://economictimes.indiatimes.com/ai/ai-insights/improving-telecommunications-with-edge-ai/articleshow/123431990.cms

- Edge AI: Definitions, Advantages, Use Cases | Nutanix https://www.nutanix.com/info/artificial-intelligence/edge-ai

- AI at the Network Edge – EFFECT Photonics https://effectphotonics.com/insights/ai-at-the-network-edge/

- Edge Data Centers in the Age of AI – EFFECT Photonics https://effectphotonics.com/insights/edge-data-centers-in-the-age-of-ai/

- Impact of Edge Computing on Data Centers – DataBank https://www.databank.com/resources/blogs/how-edge-computing-is-impacting-data-centers-redefining-the-next-decade/

- Moving AI to the edge: Benefits, challenges and solutions – Red Hat https://www.redhat.com/en/blog/moving-ai-edge-benefits-challenges-and-solutions

- Edge hybrid pattern | Cloud Architecture Center https://cloud.google.com/architecture/hybrid-multicloud-patterns-and-practices/edge-hybrid-pattern

- Hybrid Cloud Architecture Explained: The Strategic Role of Edge Comput – Premio Inc https://premioinc.com/blogs/blog/hybrid-cloud-architecture-explained-the-strategic-role-of-edge-computing

- Using AI in hybrid cloud environments: Benefits and use cases – Red Hat https://www.redhat.com/en/blog/using-ai-hybrid-cloud-environments-benefits-and-use-cases

- Cloud–Edge Hybrid Computing Architecture for Large-Scale Scientific Facilities Augmented with an Intelligent Scheduling System – MDPI https://www.mdpi.com/2076-3417/13/9/5387

- Fully analog end-to-end online training with real-time adaptibility on integrated photonic platform – arXiv https://arxiv.org/html/2506.18041v1

- Neuromorphic Photonics Circuits: Contemporary Review – MDPI https://www.mdpi.com/2079-4991/13/24/3139

- Dynamic Electro-Optic Analog Memory for Neuromorphic Photonic Computing – arXiv https://arxiv.org/html/2401.16515v2

- Roadmap on Neuromorphic Photonics – University of Strathclyde https://pureportal.strath.ac.uk/files/257554830/Brunner-etal-ArXiv-2025-Roadmap-on-neuromorphic-photonics-neuromorphic-photonics.pdf

- Photonics for Neuromorphic Computing: Fundamentals, Devices, and Opportunities – arXiv https://arxiv.org/html/2311.09767v2

- Neuromorphic-based metaheuristics: A new generation of low power, low latency and small footprint optimization algorithms1footnote 11footnote 1This work has been supported by the ERC Generator of the University of Lille. – arXiv https://arxiv.org/html/2505.16362v1

- Inside the Data Center Revolution Powering a Sustainable AI Industry | Observer https://observer.com/2025/07/data-centers-esg-ai-growth/

- How AI Is Fueling a Boom in Data Centers and Energy Demand – Time Magazine https://time.com/6987773/ai-data-centers-energy-usage-climate-change/