Part 1: 基礎概念:アーキテクチャ設計図と希求される原則

本章では、Retrieval-Augmented Generation(RAG)と「グラウンディング」という、密接に関連しながらも明確に区別される2つの概念のアイデンティティを確立する。RAGを特定のプロセス指向の技術アーキテクチャとして定義し、一方でグラウンディングを、RAGが実現を助ける、より広範で望ましいAIの振る舞いの原則として定義する。

Section 1.1: Retrieval-Augmented Generation(RAG)のアーキテクチャ

本セクションでは、現代AIにおける標準的な方法論としてRAGフレームワークを包括的に技術的に解体する。

RAGをハイブリッドアーキテクチャとして定義する

Retrieval-Augmented Generation(RAG)は、検索メカニズムと生成言語モデルを組み合わせた先進的なハイブリッドアーキテクチャである 。その目的は、外部の最新の知識ソースから情報を取り込むことによって大規模言語モデル(LLM)を強化し、それによってハルシネーション(幻覚)、古い知識、不透明な推論プロセスといったLLMの核心的な限界に対処することにある 1。このアプローチは、静的で既存のトレーニングデータのみに依存する従来のLLMとは根本的に異なる 4。2020年にLewisらによって導入された中核的なイノベーションは、検索された知識を条件として生成プロセスを実行することである 3。

標準的な4段階のRAGパイプライン

RAGプロセスは、普遍的に認識されている4つの段階に分けることができる。以下に各段階の技術的な詳細を解説する。

Stage 1: インデックス作成(知識準備フェーズ)

これは、検索のために知識ベースを準備するオフラインのプロセスである。

- データインジェストと準備: 多様なフォーマット(PDF、HTML、Wordなど)の生データがクリーンアップされ、統一されたプレーンテキスト形式に変換される 。

- チャンキング(分割): LLMのコンテキストウィンドウの制限に対応するため、テキストはより小さく、消化可能で、意味的にまとまりのあるチャンクに分割される 2。チャンクが小さすぎると文脈を失い、大きすぎるとノイズを導入する可能性があるため、このチャンキング戦略は重要な設計判断となる 6。

- エンベディング(埋め込み): 各チャンクは、エンベディングモデル(例:bge-base-en-v1.5)を使用して数値ベクトル表現に変換される。このベクトルはテキストの意味的な意味を捉える 2。

- ベクトル格納: これらのエンベディングは、効率的な類似性検索に最適化された専門のベクトルデータベース(例:ChromaDB、Pinecone)に格納される 2。

Stage 2: 検索(関連情報の発見)

これは、ユーザーのクエリによってトリガーされる最初のオンラインステップである。

- クエリエンコーディング: ユーザーのクエリは、一貫性を確保するためにインデックス作成フェーズと同じエンベディングモデルを使用してベクトルに変換される 。

- 類似性検索: システムは、クエリベクトルとデータベース内の全チャンクのベクトルとの類似性(例:コサイン類似度を使用)を計算する。最も類似性の高い上位K個のチャンクが検索される 2。この検索ステップの品質は最も重要であり、不適切な検索は無関係なコンテキストをもたらし、最終的な出力の質を低下させる 10。

Stage 3: 拡張(プロンプトの強化)

検索されたテキストチャンクは、ユーザーの元のプロンプトを拡張するために使用される。

- コンテキストプロンプティング(「プロンプトスタッフィング」): 検索されたテキストは、元のクエリと統合され、LLMに供給される新しい包括的なプロンプトが作成される。これにより、モデルは根拠のある回答を形成するために必要な外部コンテキストを得ることができる 2。プロンプトは、提供されたコンテキストのみに基づいて回答するようにLLMに明示的に指示する構造になっている場合がある 12。

Stage 4: 生成(回答の形成)

LLMは、拡張されたプロンプトに基づいて応答を生成する。

- LLM推論: LLMは、結合されたクエリと検索されたコンテキストを処理し、人間のような応答を形成する 1。モデルは、内部のパラメトリック知識を利用するか、提供された文書内の情報に厳密に回答を制限するように指示されることがある 。この最終ステップは、LLMの推論能力と言語能力の恩恵を受けるが、今や事実に基づいた検索情報に固定されている。

RAGは特定の既知のLLMの失敗モードに対する解決策である

標準的なLLMは、事実の幻覚、古いトレーニングデータへの依存、検証不可能な回答の提供といった、いくつかの重大な弱点を持つことが知られている 1。RAGアーキテクチャは、これらの弱点に対抗するために明示的に設計されている。検索ステップは、最新の情報を取得することで古い知識の問題に対処する 4。拡張ステップは、プロンプトに直接事実に基づいたコンテキストを提供することで、ハルシネーションを軽減する 2。回答を検索された文書にまで遡って追跡できる能力は、検証可能性を提供する 4。

したがって、RAGは単なる任意のアーキテクチャではなく、大規模言語モデルの最も差し迫った信頼性と信頼性の問題に対する直接的かつ的を絞ったエンジニアリングソリューションである。これは、モデルの内部知識を「完璧」にしようとする試みから、実行時に外部の検証可能な事実でそれを補強するという戦略的な転換を意味する。これにより、継続的な再トレーニングに代わる費用対効果の高い代替手段となる 4。

Section 1.2: 生成AIにおけるグラウンディングの原則

本セクションでは、「グラウンディング」を技術としてではなく、信頼できるAIのための基本的な原則または望ましい品質として定義する。

Googleによるグラウンディングの定義

Googleは、特にVertex AIや製品ドキュメントを通じて、グラウンディングをモデルの出力を検証可能な情報源に接続する能力として定義している 13。その明確な目標は、モデルの出力を特定のデータに「つなぎ留める」ことであり、それによってコンテンツを捏造する(ハルシネーション)可能性を減らすことである 13。

グラウンディングの主な利点(Googleによる)

- ハルシネーションの削減: モデルが事実でないコンテンツを生成するのを防ぐ 13。

- 応答の固定: モデルの応答を、提供された特定のデータソースに結びつける 13。

- 監査可能性の提供: 使用されたソースへのリンクや引用を提供することで、検証を可能にする 13。

より広範な業界および概念的理解

グラウンディングの概念は、Googleの特定の定義を超えて広がる。

- AIにおける「シンボルグラウンディング問題」、すなわち抽象的なシンボル(単語など)を実世界の意味や文脈に結びつけるという課題に取り組むものである 17。

- 事実の正確性、文脈上の関連性、そして実世界での適用可能性を高めることに関するものである 18。

- グラウンディングは、知識グラフやマルチモーダルデータの使用などと並んで、Retrieval-Augmented Generationが主要な手法として挙げられるなど、様々な技術によって達成される 17。

グラウンディングは技術的実装ではなく、ユーザー中心の目標である

グラウンディングを説明するために使用される言葉は、「能力」「検証可能」「正確性」「信頼性」「信頼」といった成果や品質に焦点を当てている 13。これらはプロセスの説明ではなく、AIの出力に望まれる状態や特性の説明である。技術ドキュメント 13 では、グラウンディングを達成するための複数の

手法が挙げられており、RAGはその一つである。これは、一つの目標(グラウンディング)が多くの技術(RAG、知識グラフなど)によって達成できるという一対多の関係を示唆している。

したがって、グラウンディングは、信頼できるAIシステムの設計における核心的な原則として理解するのが最も適切である。それは何を(信頼でき、検証可能な出力)であり、なぜ(ユーザーの信頼を築き、正確性を確保するため)である。後述するように、RAGはどのようにしてそれを実現するかの手段である。この区別は、製品マーケティングと技術アーキテクチャを理解する上で極めて重要である。

Section 1.3: 本質的なつながり:グラウンディングを達成するための主要メカニズムとしてのRAG

本セクションでは、前の2つのセクションを統合し、Google自身のエコシステムを決定的な証拠として用いて、RAGとグラウンディングの間の階層的な関係を明確に確立する。

Vertex AI:明確な接続

Google自身のエンタープライズAIプラットフォームであるVertex AIのドキュメントが、最も明確な証拠を提供している。このドキュメントでは、グラウンディングを達成する一つの方法として、**「Retrieval-Augmented Generation(RAG)を使用して、モデルをウェブサイトのデータや文書セットに接続する」**と明記されている 13。これは、RAGが

グラウンディングのために使用される技術であることを直接的かつ明確に示す記述である。

RAGがグラウンディングの核心的な信条を可能にする

グラウンディングの利点を、RAGアーキテクチャの機能に直接マッピングすることができる。

- ハルシネーションの削減: RAGは、LLMに事実に基づいた検索コンテキストをプロンプトで提供することにより、情報を捏造する必要性を減らし、これを達成する 1。

- 応答の固定: RAGプロセス全体が、特定のコーパス(インデックス化された文書)に応答を固定するように設計されている。モデルは、このコーパスを使用するように明示的に指示される 2。

- 監査可能性の提供: RAGの検索段階は、自然に使用されたソース文書のリストを生成する。これらのソースは、引用としてユーザーに提示され、明確な監査証跡を提供することができる 4。

Googleの用語における戦略的なニュアンス

これまでの分析で、RAGが技術的なメカニズムであり、グラウンディングが原則・成果であることが確立された。この理解を基に、Googleのコミュニケーション戦略を分析すると、意図的な使い分けが見えてくる。Vertex AI APIのような開発者向け製品では、Googleは技術的な聴衆に対して適切な、正確な技術用語「RAG」を「グラウンディング」と並べて使用している 13。

対照的に、NotebookLMのような消費者・プロシューマー向け製品では、Googleは主に「ソースグラウンディング」という用語を使用している 21。「ソースグラウンディング」という用語は、より直感的で利益指向である。それはユーザーに対して、「あなたのAIは

あなたのソースに根差している」という価値提案を即座に伝える。「Retrieval-Augmented Generation」は専門用語が多く、利益ではなくプロセスを説明するものである。

このことから、Googleが開発者向けには正確な技術言語(RAG)を、エンドユーザー向け製品にはよりアクセスしやすく、利益を重視した用語(ソースグラウンディング)を意図的に使用しているという、洗練されたコミュニケーション戦略が明らかになる。「ソースグラウンディング」は、事実上、NotebookLMにおける特定のソースに制約されたRAG実装によって提供されるユーザー体験に対するGoogleのブランド名なのである。

Part 2: Google NotebookLMのケーススタディ

本章では、理論から実践へと移行し、NotebookLMを具体的な例として用いて、RAGアーキテクチャと「ソースグラウンディング」されたユーザー体験との関係を明らかにする。

Section 2.1: NotebookLMの「ソースグラウンディング」という約束

本セクションでは、NotebookLMがどのように位置づけられ、マーケティングされているかを分析し、グラウンディング原則のユーザー向けの発現に焦点を当てる。

中核となる製品哲学

NotebookLMは、「あなたが信頼する情報にグラウンディングされた、あなたの研究と思考のパートナー」として明確にマーケティングされている 21。GeminiやChatGPTのような汎用チャットボットとの主な差別化要因は、NotebookLMの応答がユーザーが提供したソース

のみに制約されることである 20。これにより、「あなたに関連する情報に精通したパーソナライズされたAI」が作成される 23。

ユーザーインターフェースにおけるグラウンディングの現れ

- インライン引用: これは最も直接的で強力な機能である。AIによって生成されたすべての主張や要約には、数字の引用(例:, )が付随する。これらの引用をクリックすると、ソース文書からの正確な引用が表示され、即座に検証が可能となる 21。これは、監査可能性の約束を直接的に実現するものである。

- ソース固有のチャット: ユーザーは、アップロードされた文書についてのみ「専門家」であるチャットボットと対話する 20。この焦点により、モデルが「逸脱」して外部の知識を取り込むことを防ぎ、これは一般的なチャットボットでよくある問題である 20。

- 自動要約とガイド: ソースをアップロードすると、NotebookLMはそのソースから直接派生した要約と推奨質問を自動的に生成し、すべてのインテリジェンスが提供された資料に根ざしているという考えを強化する 20。

NotebookLMの「ソースグラウンディング」は、より厳格で制約された形式のグラウンディングである

グラウンディングの一般的な定義は、公開ウェブを含む様々なソースを許容する(例:Vertex AIの「Google検索によるグラウンディング」13)。しかし、NotebookLMの価値提案全体は、オープンなインターネットとLLMの一般知識を

除外することに基づいている。それは、ユーザーのプライベートでキュレーションされた文書セットでのみ動作するように設計されている 23。これにより、ユーザーがAIの知識ベースを完全に制御できるクローズドループシステムが生まれる。

したがって、NotebookLMにおける「ソースグラウンディング」は、単なる一般的なグラウンディングではない。それは、「検証可能なソース」が100%ユーザーによって定義され、提供される、特定の、高度に制約された実装である。これは、個人の研究、学習、および専有文書の分析といったタスクに対して、関連性と信頼性を最大化するための重要な製品決定である。

Section 2.2: RAGシステムとしてのNotebookLMワークフローの解体

本セクションでは、NotebookLMの「ソースグラウンディング」がRAGアーキテクチャによって駆動されているという技術的な証明を提供し、製品の機能をRAGの各段階にマッピングする。

学術的および専門家による確認

複数の学術研究や専門家の分析が、NotebookLMをRAGベースのプラットフォームとして明確に特定している。

- NotebookLMを物理学のチューターとして使用する研究では、Geminiモデルを搭載した「多機能なRAGベースの環境」と説明されている 29。

- 肺がんの病期分類への応用に関する別の研究では、「RAG搭載LLM(RAG-LLM)」として特定されている 30。

- 専門家のレビューや技術ブログでも、それがRAGツールであることが確認されている 31。

NotebookLMの機能をRAGパイプラインにマッピングする

以下の表は、NotebookLMでのユーザーアクションとRAGシステムの技術的段階との間の一対一の対応関係を示す。この表は、製品の「魔法」を解明するために極めて重要である。それは、抽象的で技術的なRAGフレームワークを、NotebookLMインターフェース内の具体的で観察可能なユーザーアクションに変換する。これにより、ユーザーのクエリに対する決定的なつながりが提供され、RAGが「ソースグラウンディング」された体験を提供するエンジンであることが示される。

| RAGステージ | 技術的メカニズム | 対応するNotebookLMの機能/アクションと関連資料 |

| インデックス作成 | 文書読み込み、マルチモーダル処理、チャンキング、エンベディング、ベクトル格納 | ユーザーは「ソース」パネルにソース(PDF、URL、Googleドキュメント、YouTube動画、音声ファイル)をアップロードする。NotebookLMはこれらを処理し、テキスト/トランスクリプトを抽出し、チャンク化し、バックグラウンドで検索可能なベクトルインデックスを作成する 21。これにより、ノートブック用のパーソナライズされた知識ベースが作成される。 |

| 検索 | ユーザークエリのエンベディング、ベクトル類似性検索 | ユーザーは「チャット」パネルに質問を入力する。NotebookLMはクエリをエンベディングに変換し、インデックス化されたソースチャンクに対して類似性検索を実行して、最も関連性の高いパッセージを見つける 2。 |

| 拡張 | コンテキストプロンプトエンジニアリング(「プロンプトスタッフィング」) | システムは、検索されたテキストチャンクを自動的に取得し、ユーザーの元の質問とともにGeminiモデルに送信されるプロンプトに挿入する。これはユーザーには見えない形で実行される 2。 |

| 生成 | LLM推論、応答形成 | 基盤となるGeminiモデル(例:Gemini 1.5 Pro, Gemini 2.0)が拡張されたプロンプトを処理し、テキストベースの回答を生成し、それが「チャット」パネルに表示される 21。 |

| 検証可能性(グラウンディングの成果) | ソース帰属と引用リンク | 生成された回答には数字の引用 , が含まれる。引用にカーソルを合わせるかクリックすると、使用された正確なソースパッセージがハイライト表示され、主張と証拠の間に直接的で検証可能なリンクが提供される 20。 |

Part 3: 統合と広範な示唆

本最終章では、これまでのすべての分析を統合し、決定的な回答を提供するとともに、この技術的および製品戦略のより広い意味を探る。

Section 3.1: 決定的な区別:方法論 vs. 原則

本セクションでは、明確なアナロジーを用いて関係性を明確にし、本レポートの中心的な結論を提示する。

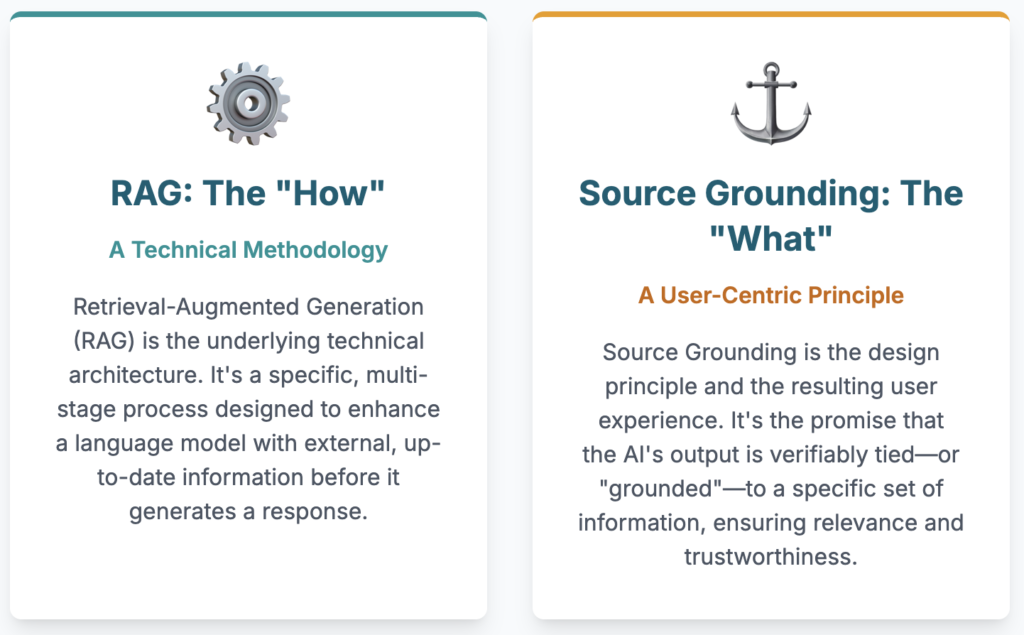

中核となる区別

- Retrieval-Augmented Generation(RAG)は技術アーキテクチャであり、方法論である。それはボンネットの下にあるエンジンであり、外部知識でLLMを強化するために設計された特定のプロセス(インデックス作成、検索、拡張、生成)のシーケンスである。

- ソースグラウンディングは設計原則であり、その結果としてのユーザー体験である。それは、AIの出力が特定の情報セットに検証可能に結びついているというユーザーへの約束である。NotebookLMでは、この原則は最も厳格な形で実装されている。つまり、AIはユーザーが提供したソースに排他的にグラウンディングされている。

明確化のためのアナロジー

RAGとソースグラウンディングの関係は、内燃エンジンと車の「パフォーマンス」の関係に例えることができる。エンジン(RAG)は成果を生み出すメカニズムである。パフォーマンス(ソースグラウンディング)は、ユーザーが体験し、価値を見出す特性であり、この場合は信頼性、正確性、検証可能性である。

共生関係とそのトレードオフ

RAG実装の品質は、「グラウンディング」の品質を直接決定する。RAGパイプラインの失敗(例:不適切な検索、不正確なチャンキング)は、ユーザーには「グラウンディング」の失敗(例:無関係または不完全な回答)として現れる 6。逆に、NotebookLMの厳格な「ソースグラウンディング」原則は、そのRAGシステムに大きなプレッシャーをかける。一般知識に頼ることができないため、検索ステップは非常に正確でなければならない。

これはまた、システムの品質がユーザーによって提供されるソースの品質に完全に依存することを意味する。「ゴミを入れればゴミしか出てこない」という原則が直接適用される 34。この関係は共生的である。RAGはグラウンディングを

可能にするが、厳格なソースグラウンディングへのコミットメントが、RAG実装に必要な堅牢性を決定する。これにより、強力だが脆弱なシステムが生まれる。ソースが良好で検索が機能する場合は非常に信頼性が高いが、答えがソースにないか、検索が失敗した場合は完全に効果がない。これは、汎用チャットボットと比較した場合の基本的なトレードオフである。

Section 3.2: 説明可能なAI(XAI)とユーザーの信頼への広範な示唆

本セクションでは、NotebookLMの特定のケースを、より広く、重要な分野である説明可能なAI(XAI)に結びつける。

XAIの実用的な実装としてのRAG

説明可能なAI(XAI)は、AIの決定を人間にとって透明で理解可能なものにすることを目指しており、これは信頼を築く上で極めて重要である 35。RAGによって可能になるNotebookLMのソースグラウンディングは、強力なユーザー向けのXAI機能である。

- 追跡可能性: 引用機能は直接的な追跡可能性を提供し、ユーザーがAIの「思考プロセス」をそのソース証拠まで遡ることを可能にする。これは、XAIの核心的な原則と一致する 35。

- 透明性: 知識ベースを制約することにより、システムは透明になる。ユーザーはAIがどの情報にアクセスしているかを正確に知ることができ、グローバルモデルが何を知っているかもしれないという「ブラックボックス」の不確実性を排除する 39。

- 信頼の構築: この検証可能性は、信頼の礎である。ユーザーはAIの出力を検証でき、これは学術研究、法務分析、医療情報統合などのハイステークスな領域で不可欠である 30。ソースを確認できる能力は、ユーザーを盲目的な信頼から、情報に基づいた協力へと移行させる。

認知的オフロードと人間の役割

引用付きのRAGは、情報を見つけるという認知的負荷を軽減する一方で、ユーザーの役割も変化させる。

- ユーザーは「検索者」から「検証者」および「統合者」へと移行する 41。

- 引用機能は信頼のためだけでなく、ユーザーに「より深く掘り下げ」、AIの統合を批判的に評価するよう促す、ワークフローの重要な部分である 22。これは、AIが検索と初期ドラフト作成を担当し、人間が批判的思考と最終判断を担当する、人間とAIの協力モデルを促進する 43。

Section 3.3: 上級ユーザー向けの実用的な洞察

本最終セクションでは、レポートの分析に基づき、対象読者向けに実践的な要点を提供する。

NotebookLMとの対話を最適化する

- ソースのキュレーションが鍵: NotebookLMの出力品質は、アップロードされたソースの品質と包括性の直接的な関数であることを理解すること。システムは文書にないことには答えられない(失敗点FP1、6)。

- 戦略的なプロンプティング: 提供されたテキストから回答可能な質問を組み立てること。「フランスの首都はどこですか?」ではなく、「提供された旅行記によると、著者のパリに対する印象はどうでしたか?」と尋ねる。

- 「失敗」の解釈: NotebookLMが質の低い回答をした場合、それを「ハルシネーション」としてではなく、潜在的なRAGパイプラインの失敗として認識すること。それは検索の失敗(適切なチャンクが見つからなかった)、コンテキストの制限(回答が破棄されたチャンクにあった)、または抽出の失敗(LLMが提供されたコンテキストから回答を引き出せなかった)である可能性がある 6。この理解により、より良いトラブルシューティングが可能になる(例:検索を改善するためにクエリを言い換える)。

競合ツールを評価する

- このフレームワークを使用して、他の「AIリサーチアシスタント」を批判的に評価すること。その「グラウンディング」は、検証可能な引用を備えた完全なRAGアーキテクチャに基づいているか、それとも明確な帰属のないウェブ検索結果を用いた単なるプロンプトスタッフィングの一形態か?NotebookLMのようなクローズドループシステムで動作するか、それとも専有データと公開データを混ぜ合わせるか?といった点を問う。

グラウンディングされたAIの未来

RAGとグラウンディングの区別は、AI製品開発における重要なトレンドを浮き彫りにする。それは、生の技術的能力を披露することから、信頼、検証可能性、制御といったユーザー中心の利益を提供することへの移行である。NotebookLMの「ソースグラウンディング」は、このトレンドの代表的な例であり、複雑なRAGアーキテクチャを直感的で信頼性の高いユーザー体験にパッケージ化している。

引用文献

- A Comprehensive Review of Retrieval-Augmented Generation (RAG): Key Challenges and Future Directions – arXiv https://arxiv.org/pdf/2410.12837

- Retrieval-Augmented Generation for Large Language … – arXiv https://arxiv.org/pdf/2312.10997

- A Systematic Review of Key Retrieval-Augmented Generation (RAG) Systems: Progress, Gaps, and Future Directions – arXiv https://arxiv.org/html/2507.18910v1

- Retrieval-augmented generation – Wikipedia https://en.wikipedia.org/wiki/Retrieval-augmented_generation

- RAG vs Traditional AI (2025):Why NotebookLM Crashes with 100+ Documents? (and what works instead) – Elephas App https://elephas.app/blog/rag-vs-traditional-ai-unlimited-document-processing

- Seven Failure Points When Engineering a Retrieval Augmented Generation System – arXiv https://arxiv.org/html/2401.05856v1

- Code a simple RAG from scratch – Hugging Face https://huggingface.co/blog/ngxson/make-your-own-rag

- An end-to-end tutorial for developing a RAG Application from scratch | by Herman Wandabwa | Data Science Collective | Medium https://medium.com/data-science-collective/from-data-to-dialogue-development-of-a-retrieval-augmented-generation-rag-chatbot-for-fitness-b9fbaf818ace

- RAG Tutorial: A Beginner’s Guide to Retrieval Augmented Generation – SingleStore https://www.singlestore.com/blog/a-guide-to-retrieval-augmented-generation-rag/

- RAG vs. Fine-Tuning: What Dev Teams Need to Know | Heavybit https://www.heavybit.com/library/article/rag-vs-fine-tuning

- Seven Ways Your RAG System Could be Failing and How to Fix Them – Label Studio https://labelstud.io/blog/seven-ways-your-rag-system-could-be-failing-and-how-to-fix-them/

- How to get a RAG application to add citations | 🦜️ LangChain https://python.langchain.com/docs/how_to/qa_citations/

- Grounding overview | Generative AI on Vertex AI – Google Cloud https://cloud.google.com/vertex-ai/generative-ai/docs/grounding/overview

- A Survey on RAG Meets LLMs: Towards Retrieval-Augmented Large Language Models https://arxiv.org/html/2405.06211v1

- cloud.google.com https://cloud.google.com/vertex-ai/generative-ai/docs/grounding/overview#:~:text=In%20generative%20AI%2C%20grounding%20is,the%20chances%20of%20inventing%20content.

- Grounding | Generative AI on Vertex AI – Google Cloud https://cloud.google.com/vertex-ai/generative-ai/docs/model-reference/grounding

- What is Grounding in AI and What are the Best Techniques? – ODSC – Open Data Science https://odsc.medium.com/what-is-grounding-in-ai-and-what-are-the-best-techniques-655e985cc06f

- Understanding Grounding in AI – Miquido https://www.miquido.com/ai-glossary/grounding/

- 10 Ways To Prep Your Knowledge Base for AI Grounding – Salesforce https://www.salesforce.com/blog/ai-grounding/

- NotebookLM: A Guide With Practical Examples – DataCamp https://www.datacamp.com/tutorial/notebooklm

- Google NotebookLM | AI Research Tool & Thinking Partner https://notebooklm.google/

- AI UX Patterns | Citations | ShapeofAI.com – The Shape of AI https://www.shapeof.ai/patterns/citations

- Introducing NotebookLM – Google Blog https://blog.google/technology/ai/notebooklm-google-ai/

- Steven Berlin Johnson on How to Use Google’s AI-Powered Research and Writing Tools in Your Work in Government – RebootDemocracy.AI Blog https://rebootdemocracy.ai/blog/Notebook-LM-Video

- NotebookLM: There’s Never Been a Better Time to Try Google’s Best AI Tool – CNET https://www.cnet.com/tech/services-and-software/notebooklm-theres-never-been-a-better-time-to-try-googles-best-ai-tool/

- A Complete How-To Guide to NotebookLM – Learn Prompting https://learnprompting.org/blog/notebooklm-guide

- What is Google NotebookLM? Features, Working, and Uses – GeeksforGeeks https://www.geeksforgeeks.org/websites-apps/google-notebooklm/

- NotebookLM Is Google’s Best AI Tool — Here’s What It Can Do for You – CNET https://www.cnet.com/tech/services-and-software/notebooklms-ai-super-power-is-its-flexibility-heres-how-to-get-started-with-it/

- NotebookLM: An LLM with RAG for active learning and collaborative tutoring – arXiv https://arxiv.org/html/2504.09720v2

- [2410.10869] Application of NotebookLM, a Large Language Model with Retrieval-Augmented Generation, for Lung Cancer Staging – arXiv https://arxiv.org/abs/2410.10869

- Google’s NotebookLM, RAG and Then Some – Michael Ruminer – Medium https://m-ruminer.medium.com/googles-notebookllm-rag-and-then-some-08b817d82417

- The Ultimate Guide to Google NotebookLM | Features, Setup & Use Cases – Deimos https://www.deimos.io/blog-posts/the-ultimate-guide-to-google-notebooklm

- Seven Failure Points When Engineering a Retrieval Augmented Generation System – arXiv https://arxiv.org/abs/2401.05856

- Retrieval-augmented generation (RAG) failure modes and how to fix them https://snorkel.ai/blog/retrieval-augmented-generation-rag-failure-modes-and-how-to-fix-them/

- What is Explainable AI (XAI)? – IBM https://www.ibm.com/think/topics/explainable-ai

- Explainable AI – how humans can trust AI – Ericsson https://www.ericsson.com/en/reports-and-papers/white-papers/explainable-ai–how-humans-can-trust-ai

- A Guide to Explainable AI (XAI) – Unaligned Newsletter https://www.unaligned.io/p/guide-explainable-ai-xai

- What is retrieval-augmented generation (RAG)? – IBM Research https://research.ibm.com/blog/retrieval-augmented-generation-RAG

- What is RAG (Retrieval-Augmented Generation)? – AWS https://aws.amazon.com/what-is/retrieval-augmented-generation/

- Explainable artificial intelligence (XAI): from inherent explainability to large language models – arXiv https://arxiv.org/html/2501.09967v1

- (PDF) Cognitive Off-Loading in the Age of AI: A Hierarchical Risk Model for Human-RAG Systems – ResearchGate https://www.researchgate.net/publication/393339053_Cognitive_Off-Loading_in_the_Age_of_AI_A_Hierarchical_Risk_Model_for_Human-RAG_Systems

- Human-AI Collaboration in Writing: A Multidimensional Framework for Creative and Intellectual Authorship – Digital Commons@Lindenwood University https://digitalcommons.lindenwood.edu/cgi/viewcontent.cgi?article=1727&context=faculty-research-papers

- Human-AI Collaboration in Academic Writing: towards a Synergy Model and A Case to Include AI as a Co-Author | Sciety Labs (Experimental) https://sciety-discovery.elifesciences.org/articles/by?article_doi=10.31234/osf.io/snq4e_v1

- Human-AI collaboration patterns in AI-assisted academic writing – Taylor & Francis Online https://www.tandfonline.com/doi/full/10.1080/03075079.2024.2323593