第1章:序論:大学教育を揺るがす生成AIという「新たな知」

1.1 問題提起:単なる「嫌悪感」を超えて

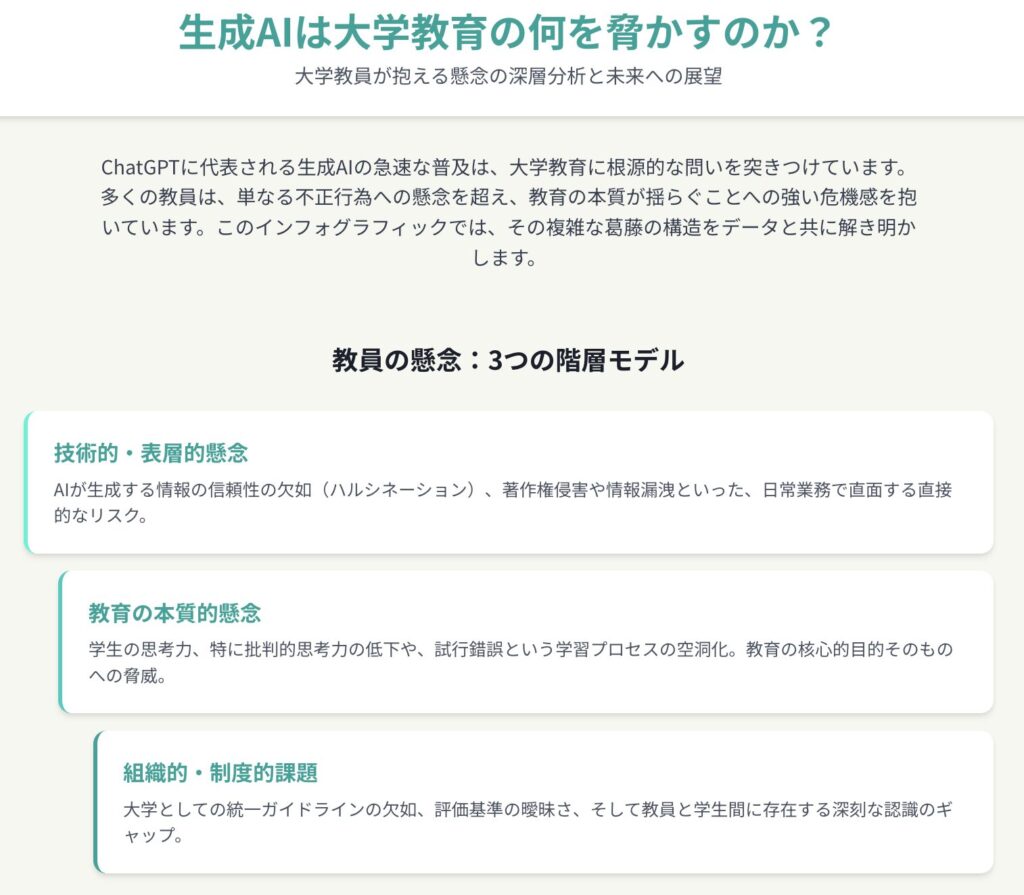

近年、ChatGPTに代表される生成AI(人工知能)の急速な普及は、社会のあらゆる領域に構造変革を迫っている。その影響は、知の生産と伝達を本務とする大学にとって、とりわけ根源的かつ深刻である。学生がレポート作成や課題解決に生成AIを安易に利用することに対し、多くの大学教員が強い懸念、あるいは一部では「嫌悪感」とも形容されるほどの抵抗を示している。本レポートは、この教員の懸念を、単なる新しいテクノロジーに対する保守的な反発や、不正行為への対策困難性といった表層的な問題として捉えるのではなく、大学教育の根幹をなすパラダイムそのものへの挑戦と位置づけ、その深層構造を多角的に解明することを目的とする。

教員の懸念の根底には、知識の生成、学習のプロセス、評価の妥当性、そして学問的誠実性(アカデミック・インテグリティ)といった、大学がその存在意義をかけて守り、育んできた価値観への脅威が存在する。生成AIは、従来の検索エンジンや翻訳ツールとは質的に一線を画す。それは、既存の情報を検索・変換するだけでなく、プロンプトに応じて新たな文章、画像、コードといったコンテンツを自律的に「生成」する能力を持つ点にある 1。この「生成」という行為が、これまで人間、とりわけ専門家である教員と、学びの途上にある学生との間で営まれてきた知的活動のあり方を根底から揺さぶり、教育現場に前例のない混乱と、同時に新たな可能性をもたらしているのである 2。

したがって、「なぜ教員は生成AIを嫌がるのか」という問いに答えるためには、技術的な問題点の指摘に留まらず、それが教育の理念や実践にどのような本質的な影響を及ぼすのか、そして大学という組織がこの挑戦にどう向き合おうとしているのかを、包括的に分析する必要がある。本レポートは、この複合的な課題に対し、緻密な分析と証拠に基づいた考察を提示するものである。

1.2 本レポートの構成と分析の視点

本レポートは、大学教員が抱く生成AIへの懸念を、その性質に応じて以下の三つの階層に分けて構造的に分析を進める。

第一に、「技術的・表層的懸念」として、生成AIが持つ技術的な欠陥、すなわちハルシネーション(幻覚)や出力根拠の不透明性、そしてそれに付随して生じる著作権侵害や個人情報漏洩といった法的・倫理的リスクを詳述する。これらは、教員が日常的に直面する最も直接的かつ具体的な問題群である。

第二に、「教育の本質的懸念」として、より深刻かつ根源的な問題を掘り下げる。すなわち、学生の思考力、特に批判的思考力の低下、試行錯誤のプロセスを省略することによる学習の空洞化、そしてそれに伴う成績評価の形骸化と学問的誠実性の崩壊といった、大学教育の核心的目的そのものを脅かす脅威を論じる。教員の「嫌悪感」の根源は、この層に深く根ざしている。

第三に、「組織的・制度的課題」として、個々の教員の懸念に対し、大学組織がどのように対応しているのか、あるいは対応しきれていないのかを明らかにする。国内外の大学が公表しているガイドラインを比較分析し、その理想と現場の現実とのギャップ、そして教員と学生の間に存在する認識のズレを浮き彫りにする。

さらに、これらの分析をより立体的なものにするため、二つの補助的な視点を導入する。一つは「歴史的文脈」である。インターネットや機械翻訳ツールが登場した際に教育現場が経験した混乱と変容の歴史を振り返ることで、現在の生成AIを巡る状況を相対化し、過度な悲観論や楽観論を排した冷静な考察を可能にする。もう一つは「国際比較」の視点である。米英の先進的な大学の取り組みや課題と比較することで、日本の大学が置かれている状況の特異性と普遍性を明らかにし、グローバルな文脈の中での日本の進むべき方向性を探る。

これらの多層的かつ複合的な分析を通じて、本レポートは最終的に、生成AIという脅威を大学教育の本質を問い直し、進化させるための「触媒」として捉え直し、未来に向けた建設的な提言を導出することを目指す。

第2章:教員が抱く技術的・表層的懸念:ハルシネーションから著作権侵害まで

大学教員が学生の生成AI利用に対して抱く懸念の中で、最も直接的かつ頻繁に指摘されるのが、テクノロジーそのものに内在する技術的な欠陥と、それに起因する法的・倫理的なリスクである。これらは、レポートや課題の評価を行う際に教員が直面する具体的な困難であり、学術活動の信頼性を担保する上での大きな障壁となっている。本章では、これらの懸念を「出力の信頼性」と「法的・倫理的リスク」の二つの側面から詳述する。

2.1 出力の信頼性:ハルシネーションと根拠のブラックボックス

生成AIの出力は、一見すると流暢で説得力があるため、多くの学生がその内容を無批判に受け入れてしまう危険性を孕んでいる。しかし、その生成プロセスには、学術的な利用において致命的となりうる二つの大きな問題が存在する。

ハルシネーション(幻覚)の危険性

生成AIは、入力されたデータに基づいて統計的に最も「それらしい」単語の連なりを予測し、文章を生成する仕組みである。これは、AIが文章の内容や情報の意味を人間のように理解して回答しているわけではないことを意味する 3。その結果、事実に基づかない情報や、全くの虚偽を、あたかも事実であるかのように理路整然とした文章の中に織り交ぜて生成することがある。この現象は「ハルシネーション(幻覚)」と呼ばれ、生成AIの最も警戒すべき欠陥の一つとされている 3。

この問題が学術的な文脈で特に危険なのは、ハルシネーションが単なる「間違い」ではなく、「平然と嘘をつく」という性質を持つ点にある。例えば、レポートの参考文献として、実在しない論文や書籍をもっともらしい著者名やタイトルで生成することが頻繁に報告されている 4。学生がこの出力を信じ込み、ファクトチェックを怠ったままレポートを提出した場合、それは単なる知識の誤りではなく、研究倫理に関わる「捏造」という重大な学術不正になりかねない。京都大学は、学生向けの注意喚起の中で、この誤情報のリスクをAI利用における中心的な問題点として挙げ、AIによる自動文章作成は「リサーチ」という検証プロセスを欠いており、学術レポートとしては致命的であると厳しく指摘している 6。学生が誤った情報を正しい知識として内面化してしまうリスクは、教育の根幹を揺るがすものである。

根拠のブラックボックス化

ハルシネーションの問題と密接に関連するのが、生成AIの思考プロセスが不透明であるという「ブラックボックス問題」である 3。AIがなぜその回答を生成したのか、どのようなデータや論理に基づいてその結論に至ったのかというプロセスを、人間が正確に追跡・検証することは極めて困難である。これは、学問の基本である「論証」、すなわち主張とそれを支える根拠の関係性を重視する姿勢とは相容れない。

学生がAIの出力を利用してレポートを作成した場合、教員が「なぜこのような結論になるのか説明しなさい」と問うても、学生自身がその論理的根拠を説明できないという事態が生じうる。AIに根拠となる情報を出力させることも可能ではあるが、前述の通り、その根拠情報自体がハルシネーションである可能性も否定できない 3。したがって、最終的なファクトチェックは常に人間の手で行う必要があり、その責任は利用者である学生自身にある。しかし、多くの学生がそのリテラシーを十分に備えているとは言い難いのが現状である 8。この根拠の不明確さは、学生の学びのプロセスを曖昧にし、教員による適切な評価を著しく困難にする。

このように、技術的な欠陥であるハルシネーションは、学術不正という倫理的な問題と直接的に結びついている。学生がAIを使ってレポートの参考文献を探すという行為自体は、一見すると効率的な情報収集に見える。しかし、AIがもっともらしいが実在しない文献を生成し(ハルシネーション)、学生が高度なファクトチェック能力を持たないためにそれをそのまま引用してしまう、という連鎖が容易に起こりうる。教員がその文献を確認した時、これは単なるツールの誤用ではなく、意図的か否かにかかわらず「参考文献の捏造」という深刻な学術不正行為となる。この状況は、教員と学生との間に不信感を生み、評価を巡る無用な対立を引き起こす原因となり、教育活動そのものを阻害する。

2.2 法的・倫理的リスク:著作権、個人情報、バイアスの罠

生成AIの利用は、技術的な信頼性の問題だけでなく、著作権法や個人情報保護法といった法的な問題や、社会的なバイアスを助長する倫理的な問題とも隣接している。大学は教育・研究機関であると同時に、社会的な責任を負う組織として、これらのリスクを看過することはできない。

著作権侵害と剽窃

生成AIは、インターネット上の膨大なテキストデータを学習データとして利用している。このデータの中には、著作権で保護された文章や画像などが大量に含まれている 6。そのため、AIが生成した文章が、意図せずして既存の著作物と酷似し、著作権侵害にあたる可能性が常に存在する 9。学生がAIの生成物をコピー&ペーストして自らのレポートとして提出する行為は、他者の知的財産を盗む「剽窃」とみなされ、最も厳しく罰せられる学術不正の一つである 12。

全国の大学が策定するガイドラインの多くは、この著作権侵害と剽窃のリスクを最重要事項として挙げ、学生に強く注意を促している 11。ある調査では、生成AIを利用する学生の27.8%が、出力結果をコピー&ペーストして提出した経験があると回答しており 8、この問題が単なる杞憂ではなく、既に現実のものとなっていることを示している。教員にとって、この種の不正行為を発見し、対処することは大きな精神的・時間的負担となる。

個人情報・機密情報の漏洩

多くの生成AIサービスでは、ユーザーが入力した指示文(プロンプト)やデータが、AIモデルのさらなる学習のために収集・利用される可能性がある 14。学生が自身の個人情報(氏名、住所、所属など)や、他者のプライバシーに関わる情報、あるいは教員が未公開の研究データや成績情報などをプロンプトとして入力した場合、それらの機密情報が意図せずサービス提供者に渡り、外部に漏洩するリスクがある 10。

一部のサービスでは、入力データを学習に利用させない「オプトアウト」設定が可能だが 14、学生・教員ともにこの設定の存在や方法についての認知度が低いという調査結果が深刻な現状を物語っている 8。ある調査では、オプトアウト設定を利用したことがある学生は18%、教員は18.8%に留まり、学生の46.8%はオプトアウトについて「よくわからない」と回答している 18。大学がガイドラインで個人情報の入力を禁止しても、利用者のリテラシーが伴わなければ、その実効性は極めて低い。このリテラシーの欠如が、情報漏洩のリスクを理論上の懸念から、現実的な脅威へと増幅させている。学生が個人的な内容を含むエッセイの添削をAIに依頼したり、教員が機微な学生データを分析させたりするケースを想定すれば、この脆弱性は大学コミュニティ全体のリスク管理における重大な欠陥と言える。

バイアスの内包と再生産

生成AIの学習データは、現実社会の縮図であり、そこには人種、性別、国籍、宗教、社会的地位などに関する様々な偏見やステレオタイプ(バイアス)が含まれている 3。AIはこれらのバイアスを善悪の判断なく学習し、その出力において特定の価値観を助長したり、差別的な表現を生成したりする可能性がある 3。

例えば、「医者」や「エンジニア」に関する文章を生成させると男性を主語にする傾向が強かったり、特定の民族に対して否定的な描写をしたりするケースが指摘されている。学生がAIの生成する「中立的に見える」文章を、客観的な事実として受け入れてしまうと、無意識のうちに偏見を内面化し、再生産してしまう危険性がある。大学教育が多様な価値観を尊重し、批判的な視座を養うことを目指す以上、このバイアスの問題は教育理念に反する深刻な倫理的課題である 11。教員は、学生がAIの出力を鵜呑みにせず、その背後にある潜在的なバイアスを見抜く能力を養う必要があると強く感じている。

第3章:教育の根幹を揺るがす本質的懸念:思考力の低下と学習プロセスの空洞化

前章で詳述した技術的・法的な懸念は、それ自体が深刻な問題であるが、大学教員が抱く不安の核心はさらに深い場所にある。それは、生成AIの安易な利用が、大学教育が本来目指すべき学生の知的発達、すなわち自律的に思考し、探求し、創造する能力の育成そのものを阻害するという、より本質的な危惧である。教員の「嫌悪感」の根源は、不正行為への対策の困難性を超え、学生の学びの機会が奪われ、知的成長が停止することへの強い危機感に他ならない。

3.1 「思考」の外部化と批判的思考力の危機

大学教育の最も重要な目的の一つは、学生が複雑な事象に対して自ら問いを立て、多角的に情報を収集・分析し、論理的な根拠に基づいて自らの見解を構築する「批判的思考力」を涵養することにある。しかし、生成AIの登場は、この思考プロセスそのものを外部化し、危機に晒している。

思考力低下への強い危惧

教員が異口同音に指摘する最大の懸念は、学生が生成AIに過度に依存することで、自ら深く考えることを放棄し、結果として思考力が著しく低下することである 9。河合塾が高校・大学の教員を対象に行った調査では、6割以上が学生の生成AI利用による「思考力低下」を懸念していると回答しており、これは教育現場における広範な共通認識となっている 20。この懸念は、「答え」を効率的に見つけることではなく、「答えに至るまでの苦闘のプロセス」にこそ学びの本質があるという、教育者の信念に基づいている。生成AIは、この「生産的な苦闘」のプロセスを学生から奪い去る可能性を秘めている。

学習プロセスの空洞化

学問的探求とは、単に最終的な「答え」を知ることではない。それは、未知の課題に対して仮説を立て、関連文献を渉猟し、データを分析し、論理を組み立て、試行錯誤を繰り返しながら結論を導き出す一連のプロセスである。このプロセスを通じて、知識は単なる情報から、学生自身の血肉となった「理解」へと昇華される。

しかし、生成AIは最終成果物に近い「答え」を瞬時に提供するため、学生はこの知的探求に不可欠なプロセスを経験する機会を失ってしまう 21。奈良工業高等専門学校で行われたプログラミング学習に関する実証研究は、この問題を象徴的に示している。生成AIを利用したグループは、教科書を利用したグループに比べて課題を完成させる時間は有意に短縮された。しかし、その後の理解度を確認するテストでは、両グループ間に有意な差は見られなかった。むしろ、AI利用グループの方が点数のばらつきが大きく、安定した理解度に繋がっていない可能性が示唆された 22。この結果は、AIが課題遂行の「効率」は高めるものの、思考や探索のプロセスを省略させることで、本質的な「学び」を阻害する危険性を示唆している。これはまさに「学習プロセスの空洞化」であり、見かけ上の成果とは裏腹に、知識の定着や応用力の育成を妨げる深刻な事態である。

批判的思考の抑制

生成AIが生成する文章は、文法的に正しく、構成も整っているため、非常に流暢で説得力があるように見える。この「もっともらしさ」が、学生の批判的な精神を麻痺させる危険性を孕んでいる。Microsoftとカーネギーメロン大学の研究者らによる報告では、ユーザーがAIの出力に対して高い信頼を置いている場合、自身の批判的思考能力を発揮しなくなる傾向が明らかにされた 23。つまり、AIを信じすぎるほど、人間は考えることをやめてしまうのである。

この傾向は、特に長期的な利用において顕著になる。上海大学の研究チームは、学生が長期にわたって自発的に生成AIを使い続けると、技術への依存度が普遍的に約10%以上向上し、AIが提示するアイデアや解決策に過度に頼るようになる「技術依存危機」が生じることを発見した 24。その結果、学生はAIが提示する標準的な回答パターンに思考が同質化され、認知が硬直化し、他の可能性を探求する能力が低下するという。一部の学生からは「AIのように生きて、問題解決の方法を探す能力を失ってしまった」という声も上がっており 24、これはAIが学生から多様な視点や創造的な発想を奪い、思考を画一化させてしまうという深刻なリスクを示している。大学が育成すべきは、唯一の「正解」を覚える人間ではなく、未知の問題に対して多様な解を模索できる人間である。その意味で、批判的思考の抑制は、大学教育の理念そのものへの挑戦と言える。

3.2 学習成果の評価困難性と学問的誠実性(アカデミック・インテグリティ)の毀損

学生の思考プロセスが外部化・空洞化する問題は、教員による学習成果の評価を根本から揺るがす。レポートや論文といった伝統的な評価手法は、学生が自らの思考力を用いて成果物を作成したという暗黙の前提の上に成り立っている。生成AIは、この大前提を崩壊させた。

判別の不可能性

最大の問題は、学生が提出したレポートや論文が、本人の思考の産物なのか、それともAIによる生成物を単にコピー&ペーストしたものなのかを、教員が確実に判別する技術的手段が存在しないことである 3。Turnitinをはじめとする剽窃検知ツールにはAI生成コンテンツの検知機能が搭載されているものもあるが、その精度は現時点では不完全であり、AIが生成した文章を人間が書いたものと誤判定したり、逆に人間が書いたものをAIが生成したと誤判定したりするリスクを常に孕んでいる 3。ある研究では、ChatGPTによるカンニングは94%が検出不能であったと報告されており 27、検知ツールへの過信は禁物である。

この「判別不可能性」は、評価の現場に深刻なジレンマをもたらす。従来、剽窃の疑いがある場合、教員側がその証拠を提示する責任(立証責任)を負っていた。しかし、AI利用に関しては、明確な証拠を掴むことが極めて難しい。教員がAI利用を疑い、学生に問いただしても、学生が「使っていない」と主張すれば、教員はそれを受け入れざるを得ないケースが多い 4。これにより、評価における立証責任が逆転し、教員は不正の疑いを持ちながらも、証拠不十分のために不本意な評価を下さざるを得ないという状況に追い込まれる。これは、正直に自力で課題に取り組んだ学生が、AIを不正利用した学生よりも低い評価を受けるという、極めて不公正な状況を生み出す。この構造的な不公正は、教員と学生の信頼関係を蝕み、成績評価システム全体の正当性を失墜させる。

評価の形骸化と教員の負担増

生成AIを使えば、文章力や専門知識が不十分な学生でも、容易に一定水準以上のレポートを作成することが可能になる。これにより、レポート評価を通じて学生の知識の理解度や論理的思考力、表現力を測るという、評価本来の目的が形骸化してしまう 4。

この事態に対応するため、教員はAIの不正利用を防ぐための追加的な対策を講じることを余儀なくされる。例えば、学期の初めに手書きのレポートを提出させて学生個々の文章スタイルを把握したり、レポート提出の際に複数の下書き原稿の提出を義務付けたり、途中で個人面談を設定して進捗や内容の理解度を口頭で確認したりといった手法が提案されている 26。しかし、これらの対策は、既に多忙を極める大学教員の業務負担をさらに増大させるものであり、現実的な解決策とは言い難い 29。結果として、評価の質を維持するための努力が、教員の教育・研究活動を圧迫するという本末転倒な事態を招いている。

アカデミック・インテグリティの崩壊

生成AIが生成したコンテンツを、あたかも自らが作成したものであるかのように偽って提出する行為は、単なるルール違反ではない。それは、学問の世界における最も基本的な倫理規範である「学問的誠実性(Academic Integrity)」、すなわち誠実、信頼、公正、尊敬、責任といった価値観を根底から覆す行為である 5。

大学というコミュニティは、構成員がこれらの価値観を共有しているという信頼の上に成り立っている。AIによる安易な剽窃が蔓延することは、この信頼の基盤を破壊し、学位の価値そのものを貶めることに繋がる。教員が抱く強い懸念は、個々の不正行為への対応というミクロなレベルに留まらず、大学という学問共同体の存立基盤そのものが脅かされているというマクロなレベルでの危機感に基づいているのである。

3.3 教育機会の公平性に対する新たな脅威

大学教育の重要な理念の一つに、出自や経済状況に関わらず、全ての学生に等しい学習機会を提供するという「教育機会の公平性」がある。しかし、生成AIの普及は、この理念に対して新たな、そして深刻な挑戦を突きつけている。

経済格差の反映

高性能な生成AIサービス、例えばOpenAI社のGPT-4を搭載した有料プランと、旧世代のモデルを用いた無料プランとでは、出力される文章の質、論理の整合性、情報の正確性において明確な性能差が存在する 31。これは、学生の家庭の経済力が、利用できるAIの性能に直結し、ひいては学業成績に直接的な影響を及ぼす可能性を意味する。

裕福な家庭の学生は月額数千円の有料プランに加入し、より高度なAIの支援を受けて質の高いレポートを効率的に作成できる一方で、経済的に余裕のない学生は性能の劣る無料プランで妥協せざるを得ない。このような状況は、学生本人の能力や努力とは無関係な要因によって学業成果に差がつくという、新たな教育格差を生み出す 9。東京大学の学生からも、高額なAIツールの利用料金が経済的なハードルになっているとの声が上がっており 32、これは能力主義を標榜する大学教育の理念とは相容れない深刻な問題である。

デジタル・デバイドの再来

経済的な格差に加え、生成AIを効果的に使いこなすための知識やスキル、すなわち「AIリテラシー」の差もまた、新たな格差(AIデバイド)を生み出す要因となる 21。生成AIから質の高い出力を引き出すためには、「プロンプトエンジニアリング」と呼ばれる、的確な指示を与える技術が必要となる。

この技術は、単にツールへのアクセス環境があるだけでは身につかず、家庭環境や社会経済的背景に由来する文化資本(例えば、論理的な対話や専門的なコミュニケーションへの習熟度)に影響される可能性がある。AIを効果的に活用できる学生と、そうでない学生との間で、学習の効率や成果に大きな差が開くことが懸念される 9。これは、単なる技術アクセスの問題であった従来のデジタル・デバイドとは異なり、経済的格差と技術的リテラシーが複合的に絡み合った、より根深い「社会技術的格差」とでも言うべき問題であり、大学は教育の公平性を確保するために、この新たな課題への対応を迫られている。

第4章:大学組織としての対応と葛藤:ガイドライン策定と現場の現実

学生による生成AIの利用が急速に広がる中、大学組織は教育の質と学問的誠実性を維持するため、対応を迫られている。しかし、その対応は一枚岩ではなく、国内外の大学で様々な模索が続いている。本章では、まず国内主要大学が公表しているガイドラインを比較分析し、その方針の多様性と共通の課題を明らかにする。次に、米英の先進的な動向と比較することで、日本の立ち位置を相対化する。最後に、各種調査データから、この問題の根底にある教員と学生の間の「認識のギャップ」を浮き彫りにし、大学組織が直面するジレンマの構造を解明する。

4.1 国内主要大学のガイドライン比較分析:禁止、制限、推奨のグラデーション

日本の大学が公表している生成AIに関するガイドラインは、その利用を一律に禁止するのではなく、各大学の学風や教育理念を反映し、「禁止」「制限」「推奨」の間に様々なグラデーションが見られる。

- 東京大学:積極的な活用推奨

東京大学は、国内の大学の中でも特に先進的かつ積極的な方針を打ち出している。「生成AIツールの利用を一律に禁止することはせず、教育・研究等における利用の可能性を積極的に探る」と明言し 33、構成員が安全に利用できる学内サービス(Microsoft Copilotなど)を提供している 33。さらに、ソフトバンクと共同で学生向けの「データハッカソン」を開催する 34 など、単なる利用に留まらず、AIを使いこなし、新たな価値を創造する人材の育成を明確に目指している。これは、AIを避けるべきリスクではなく、活用すべき機会と捉える思想の表れである。 - 京都大学:学問の本質を問う慎重な姿勢

対照的に、京都大学はより慎重な姿勢を示している。湊長博総長は入学式の式辞において、生成AIがもたらす誤情報のリスクや、安易な利用が学びの機会を損なう危険性に言及した 35。大学の公式見解でも、「文章を書く」という行為が持つ、自己の思考を検証する内省的なプロセスの重要性を強調し、AIによる自動文章作成にはその重要なプロセスが欠けていると指摘している 6。AIの出力をそのまま利用することは学問倫理に反するという強い警告を発しており、技術の利便性よりも学問の本質的な営みを重視する姿勢が色濃く出ている 6。 - 私立大学の現実的対応:場面に応じた利用

明治大学、日本福祉大学、十文字学園女子大学など多くの私立大学では、より現実的かつ具体的なガイドラインが策定されている。共通しているのは、レポートや論文においてAIの生成物をそのまま利用・引用することを剽窃行為として厳しく禁じる一方で 11、情報収集、アイデア出し、ブレインストーミングといった学習の準備段階での活用は問題ない、あるいは推奨するという、場面に応じた使い分けを促すアプローチである 11。

しかし、これらのガイドラインの多くには、「最終的には授業担当教員の指示に従うこと」という一文が付されている 6。これは、一見すると各授業の特性に応じた柔軟な対応を可能にする合理的な方針に見える。しかし、実態としては、大学執行部が直面する複雑なジレンマを、個々の教員に「委譲」している側面がある。AI利用の可否、不正とみなす基準の設定、AI利用を前提とした課題設計、不正が疑われる場合の対応といった、極めて困難な判断と責任が、十分な研修や支援体制がないまま現場の教員一人ひとりの肩にのしかかっている。これは教員の過大な負担に繋がり 30、学内での対応の不統一や学生への不公平感を生む原因ともなっている。

Table 1: 国内主要大学の生成AI利用に関するガイドライン比較

| 大学名 | 基本方針 | レポート等での利用 | 試験での利用 | 禁止・注意事項 | 出典 |

| 東京大学 | 積極的活用を推奨 | 適切な活用を推奨。ただし、教員の指示に従うこと。 | 教員の指示に従うこと。 | 個人情報・機密情報の入力禁止。著作権侵害への注意。 | 32 |

| 京都大学 | 慎重・制限的 | AIのみでの作成は認めない。剽窃とみなされる可能性を警告。 | 教員の指示に従うこと。 | 誤情報、出典の不正確さ、著作権侵害のリスクを強調。 | 6 |

| 明治大学(経営学部) | 条件付き許容 | 生成物のそのままの使用・引用は禁止。アイデア出し等での活用は可。出典明記の必要性。 | 使用が禁止されている試験での利用は不正行為。 | 生成AIそのものを出典とすることは不適切(孫引き)。個人情報の入力禁止。 | 14 |

| 日本福祉大学 | 条件付き許容 | AIのみで作成したものを自作として提出することは禁止。参考資料とする場合は出典を明記。 | 教員の指示に従うこと。 | 個人情報・機密情報の入力禁止。著作権侵害、誤情報、倫理的問題への留意。 | 11 |

| 十文字学園女子大学 | 積極的活用を推奨(一定の制限付き) | 生成物をそのまま利用することは不適切。教員の明確な指示に従う。 | 教員の指示に従うこと。 | 個人情報・秘密情報の入力禁止。著作権、商標権、パブリシティ権の侵害リスク。 | 15 |

この表から明らかなように、日本の大学の対応は「無条件の許容」ではなく、いずれも「アカデミック・インテグリティの確保」と「利用者の情報リテラシー」を核に据えている。しかし、その実現方法や強調点において、各大学が手探りで最適解を模索している現状が浮き彫りになる。

4.2 海外の動向との比較:米国・英国の先進事例と課題

日本の大学の葛藤をより広い文脈で理解するために、海外、特にこの分野で議論をリードする米国と英国の動向と比較することは有益である。

- 米国:産業界との連携による積極的な活用推進

米国の大学は、生成AIを教育革新の原動力と捉え、産業界と積極的に連携する動きが顕著である。その象徴的な事例が、アリゾナ州立大学とOpenAIとの包括的提携である 36。同大学は、全学的に「ChatGPT Enterprise」を導入し、学生の学習促進、研究の革新、業務プロセスの効率化といった明確な目的を掲げて、その活用方法を模索している。これは、AIを単なる学生の不正ツールとして規制するのではなく、大学運営全体のデジタルトランスフォーメーション(DX)の中核に据える戦略的な動きである。また、カーネギーメロン大学のように、理工系以外の学生にもAIリテラシー教育を拡大しようとする動きも見られ 37、AIを専門家だけのものとしない姿勢がうかがえる。

しかし、その一方で、AI利用を巡る学生と大学の間の対立も表面化しており、AIを使用したとして罰せられた学生の保護者が大学を提訴する事例も報告されている 27。推進と規制の間で、米国の高等教育界もまた揺れ動いている。 - 英国:政府主導の規制と現場のギャップ

英国では、政府の教育省が比較的早期に包括的なガイダンスを示し、特に「不正行為の防止」「個人データの保護」「サイバーセキュリティの強化」を三本柱として、教育機関に注意を促している 38。これは、リスク管理を重視する慎重なアプローチと言える。

しかし、その政策と現場の実態には大きなギャップが存在する。2025年の調査によれば、英国の大学生の92%が何らかの形でAIを使用しており、その利用はもはや常態化している 39。学生の80%が「大学は明確なAIポリシーを持っている」と認識している一方で、大学からAIスキル向上のための具体的な支援を受けていると回答した学生はわずか35%に留まっている 39。学生は大学に対して、AIツールの提供や実践的なリテラシー教育を強く求めているが、大学側の対応が追いついていない。この「期待と現実のギャップ」は、英国の大学が直面する深刻な課題となっている。

日米英の動向を比較すると、当初のパニック的な反応から脱し、AIの利用を禁止するのではなく、その存在を前提とした上で「いかに批判的かつ倫理的に利用させるか」という方向に、世界的に議論が収斂しつつあることがわかる 2。ただし、その具体的なアプローチは、米国の産学連携による積極推進型、英国の政府主導によるリスク管理型、そして日本の各大学による個別模索型と、それぞれ異なる様相を呈している。共通しているのは、AIの利用を学生の透明性に委ね(利用の申告)、AIには再現できない能力を評価する方向に、教育・評価方法を転換する必要性に迫られているという点である。

4.3 教員と学生の認識ギャップ:期待と不安の非対称性

大学組織の対応が揺れ動く背景には、生成AIに対する教員と学生の間に存在する、深く、そして構造的な「認識のギャップ」がある。各種の意識調査は、両者の期待と不安が非対称であることを明確に示している。

仙台大学などが実施した全国調査によれば、生成AIの教育・学習への利用について、学生の方が教員よりも肯定的に捉える傾向が強い 18。学生の69.4%がAIによって教育・学習の可能性が広がると考えているのに対し、同様の回答をした教員は53.2%に留まった 18。利用率を見ても、大学・大学院生の使用率が34.9%であるのに対し、大学・大学院教員の使用率は36.8%とほぼ同水準だが、高校まで含めた全教員の使用率は19.3%と学生を大きく下回っており、教員全体のAIへの習熟度が学生に追いついていない可能性が示唆される 8。

一方で、リスクに対する認識は逆転する。生成AIへの依存を不安に感じる割合は、学生・教員ともに6割程度と高いが 8、学生がカンニングなど不正行為をしてしまうのではないかという不安は、学生自身よりも教員の方が強く感じている 8。また、不正行為をさせないための取り組みが必要だと考える教員は7〜8割にのぼる 41。

この認識のギャップは、両者が生成AIに求める価値の根本的な違いに起因すると考えられる。学生の多くは、AIを面倒な課題を効率的にこなし、時間を節約するための「生産性向上ツール」として期待している 39。それに対し、教員の多くは、AIが学生から思考や試行錯誤といった「学習プロセスそのもの」を奪い、知的成長を阻害する「脅威」として懸念している。この根本的な価値観の相違が、現場でのコミュニケーションのすれ違いや対立を生み出す温床となっている。大学組織が効果的な方針を打ち出すためには、この認識のギャップを埋めるための対話と、双方のニーズに応える新たな教育アプローチの設計が不可欠である。

Table 2: 生成AI利用に関する学生と教員の意識調査結果

| 調査項目 | 学生の回答 | 教員の回答 | 主な示唆 | 出典 |

| 生成AI使用率 | 30.3%(高校生含む)34.9%(大学・大学院生) | 19.3%(全教員)36.8%(大学・大学院教員) | 大学レベルでは利用率に大差ないが、教員全体の習熟度は学生より低い可能性がある。 | 8 |

| 教育・学習へのAI利用への肯定的態度 | 69.4%が肯定的 | 53.2%が肯定的 | 学生はAIの教育利用に教員より積極的。 | 18 |

| 不正行為への注意の必要性 | 79.1%が必要と認識 | 76.9%が必要と認識 | 不正行為への警戒感は双方で高いレベルで共有されている。 | 18 |

| カンニングへの不安 | 学生自身より教員の方が強く感じる | 学生より強く感じる | 教員は学生の倫理観に対してより強い懸念を抱いている。 | 8 |

| AIへの依存への不安 | 約6割が不安を感じる | 約6割が不安を感じる | 依存リスクは、学生・教員双方にとって大きな懸念事項。 | 8 |

| ガイドラインの必要性 | – | 約7割が必要と認識 | 教員は組織的なルール作りを強く求めている。 | 8 |

| ファクトチェック方法の知識 | 64%が「知らない」と回答(利用者) | – | 学生のリテラシー不足が深刻であり、ハルシネーションのリスクが現実化しやすい。 | 8 |

| オプトアウト設定の利用経験 | 18.0%が利用経験あり | 18.8%が利用経験あり | 情報漏洩リスクに対するリテラシーが学生・教員ともに極めて低い。 | 8 |

このデータは、単に学生を規制・禁止するだけでは問題が解決しないことを明確に示している。学生の「効率化したい」というニーズと、教員の「思考力を育てたい」という教育的要請。この二つを両立させるような、新たな教育パラダイムの構築こそが、大学に課せられた喫緊の課題なのである。

第5章:歴史的文脈から見る教育とテクノロジー:インターネット、翻訳ツールとの比較

生成AIが今日の大学教育にもたらしている混乱と葛藤は、歴史上、全く前例のない現象というわけではない。過去にも、教育のあり方を根底から揺るがすような破壊的テクノロジーが登場し、その都度、教育現場は大きな変革を迫られてきた。本章では、特にインパクトの大きかった「インターネット」と「機械翻訳ツール」の普及期を振り返り、現在の生成AIを巡る状況を歴史的な文脈の中に位置づける。この比較分析を通じて、我々は過度な悲観論や技術万能論から距離を置き、テクノロジーの進化に伴って必然的に生じる「教員の役割変容」という本質的な課題を浮き彫りにすることができる。

5.1 インターネット普及時の衝撃と教育の変容

1990年代後半から2000年代にかけて、インターネットが一般家庭や教育機関に急速に普及した際の衝撃は、現在の状況と驚くほど酷似している。それまで図書館や教員がほぼ独占していた情報へのアクセスが、誰にでも瞬時に可能になったことは、知のあり方を革命的に変えた 42。しかし、その一方で、教育現場は深刻な混乱に見舞われた。

当時、教員たちが最も懸念したのは、ウェブサイトからの安易なコピー&ペーストによるレポートの剽窃が蔓延することであった。また、情報の信頼性が玉石混交であるインターネットの世界は、フェイクニュースや誤情報の拡散という新たな問題を生み出し 43、学生がそれらを無批判に信じ込むことへの危惧が広がった。さらに、ネットいじめやインターネット依存といった、教育の枠を超えた社会問題も深刻化した 44。これらの問題は、今日の生成AIが引き起こしている「剽窃」「ハルシネーション」「AI依存」といった懸念のリストと、ほぼ完全に重なり合う。

当時も「学生が図書館に行かなくなり、思考力が低下する」「本を読まなくなる」といった批判が教育界から噴出した 2。しかし、結果として大学教育はインターネットを禁止する方向には進まなかった。むしろ、その存在を前提とし、新たな時代に求められる能力を育成する方向へと舵を切ったのである。具体的には、単に知識を暗記・再生する能力ではなく、膨大な情報の中から必要なものを見つけ出し、その信頼性を吟味し、批判的に評価・分析し、自らの目的に沿って再構成する能力、すなわち「情報リテラシー」の教育が、文系・理系を問わず全ての学生にとって必須のスキルとして位置づけられるようになった。教育の目的が、「知識の伝達」から「情報活用の方法論の伝達」へとシフトしたのである。この歴史的経験は、テクノロジーの脅威に対して、それを禁止するのではなく、それを使いこなすための新たなリテラシー教育を構築することで乗り越えてきた、教育の適応力と発展の歴史を示唆している。

5.2 機械翻訳ツールの登場と外国語教育の葛藤

より最近の事例として、AI技術を応用した機械翻訳ツール(例: Google翻訳、DeepL)の精度が飛躍的に向上した際の、大学の外国語教育における葛藤もまた、示唆に富んでいる。

精度の低い機械翻訳が主流であった時代、多くの外国語教員はそれを「使えないもの」として無視することができた。しかし、ニューラル機械翻訳の登場により、その精度は人間の中上級レベルに匹敵、あるいはそれを超えるまでになり 45、もはや無視できない存在となった。この時、外国語教育現場で巻き起こったのは、「学生が自力で文法を学んだり、単語を覚えたりしなくなり、語学力が根本的に低下してしまうのではないか」という強い懸念であった 45。これは、生成AIに対して教員が抱く「思考力低下」への懸念と全く同じ構造を持っている。

実際、学生の利用は教員の懸念とは裏腹に急速に常態化していった。ある調査では、授業前にAI翻訳アプリを使ったことがある学生の割合が、2022年度には100%に達したと報告されている 46。学生たちは、教員が禁止したとしても、課題作成においてAI翻訳を利用していた 46。

しかし、その影響は必ずしも否定的なものばかりではなかった。AI翻訳を利用することで、難解な文章の大意を掴むことができ、学習へのハードルが下がった結果、かえって学習意欲が向上したと回答する学生が多数存在した 45。AIが提示した訳文を手がかりに、より自然な表現を考えたり、単語のニュアンスを調べたりすることで、表現の幅が広がったという肯定的な効果も報告されている 45。一方で、AI翻訳に頼りすぎることで、自分で文章を考えることをやめてしまい、学習意欲が低下したと答える学生も一定数存在した 45。

この外国語教育における経験は、極めて重要な教訓を示している。それは、テクノロジーの存在そのものが善でも悪でもなく、その価値は教育実践の中で「どのように位置づけ、活用するか」によって決まるということである。AI翻訳の登場により、外国語教員の役割は、唯一の正しい訳を教える「知識の伝達者」から、AIが生成した不完全な訳文を学生と共に批判的に検討し、文脈に応じたより適切な表現へと導く「ファシリテーター」や「コーチ」へと変化を遂げざるを得なかった 46。

これらの歴史的経験から導き出されるのは、新しいテクノロジーが登場するたびに教育現場が経験する「代替 対 拡張」のサイクルである。当初、テクノロジーは計算機が暗算を、インターネットが図書館での調査を「代替」するように、人間の持つ中核的なスキルを「代替」する脅威として恐れられる。しかし、時間が経ち、教育実践が成熟するにつれて、テクノロジーは人間の能力を「拡張」し、より高次の思考活動を可能にするツールとして再定義される。インターネットは、単に答えを見つけるツールから、膨大な情報を比較・分析し、新たな知見を生み出すためのツールへと進化した。

生成AIに対する現在の挑戦は、この進化のサイクルをいかに加速させるかにある。AIを文章作成能力の「代替」として恐れるのではなく、人間の批判的思考や創造性を「拡張」するツールとして活用する教育デザインが求められている。例えば、AIに意図的に反論を生成させてディベートの質を高めたり、AIが作成した凡庸な下書きを学生が批判的に推敲し、より高次の文章へと昇華させたりする課題が考えられる 47。

そして、このプロセスは必然的に、教員の役割そのものの再定義を迫る。印刷技術が「舞台上の賢人(Sage on the stage)」であった教員の役割を変えたように、インターネットは情報のキュレーターとしての役割を教員に与えた。そして生成AIは、コンテンツの生成そのものを民主化する。もはや教員の価値は、標準的な知識を伝達し、定型的なレポートを評価することに主軸を置くことはできない。AIには再現不可能な、学生一人ひとりの知的好奇心を刺激し、倫理的な葛藤を含む複雑な議論をファシリテートし、独自の知的探求の旅路を導くメンターとしての役割こそが、これからの大学教員に求められる新たな、そして不可欠な専門性となるだろう。教員が生成AIに示す「嫌悪感」とは、ある意味で、この自己のアイデンティティの変容を迫る、根源的な挑戦に対する自然な反応なのかもしれない。

第6章:結論と提言:生成AI時代における大学教育の再設計

本レポートでは、大学教員が学生の生成AI利用に抱く懸念について、技術的、教育的、組織的、そして歴史的な観点から多層的に分析してきた。その結果、教員の懸念が単なる技術への反発ではなく、ハルシネーションや著作権侵害といった具体的なリスクから、思考力の低下や評価の公平性といった教育の本質に関わる正当な危惧に基づいていることが明らかになった。しかし、歴史が示すように、テクノロジーの進化を止めることはできず、それを禁止・敬遠することは、もはや現実的な選択肢ではない。

したがって、大学教育が今後取るべき道は、守りの姿勢から攻めの姿勢へと転換し、生成AIの存在を前提とした上で、教育のあり方そのものを再設計することである。以下に、そのための具体的な提言を三つの柱で示す。

6.1 守りから攻めへ:AIを前提とした課題設計と評価方法の革新

生成AI時代の教育において最も重要な転換は、AIの利用を不正行為として取り締まるという発想から、AIを学生が当然使用するツールとして受け入れ、その上でなお学生の真の能力を育成・評価できるような教育環境を設計するという発想への転換である。

- 課題設計の転換:AIでは解けない問いを立てる

従来の「知識の再生」を問うようなレポート課題は、生成AIによって容易に代替されてしまう。今後は、AIの利用を前提としつつ、AIだけでは完遂できない、より高次の思考力を要する課題設計が不可欠となる 48。 - 具体的な課題例としては、

- 比較・分析課題: 特定のテーマについて、複数の生成AI(例: ChatGPT, Gemini, Claude)に回答を生成させ、それぞれの出力の論理構成、文体、内包されるバイアス、情報の正確性を比較・分析し、AIの特性自体を考察させる 47。

- 協働・創造課題: 生成AIをブレインストーミングのパートナーとして活用し、新たな事業計画、芸術作品、社会問題への解決策などを共同で創造させ、そのプロセスにおける人間とAIの役割分担や、AIの提案をどのように発展させたかをリフレクションレポートとして提出させる 47。

- 批判的推敲課題: 生成AIが作成した標準的な文章を「下書き」として提示し、学生にその文章の論理的欠陥や表現の陳腐さを指摘させ、より説得力と独創性のある文章へと批判的に推敲・改善させる 47。

これらの課題は、学生がAIを単なる「答えを出す機械」ではなく、「思考を深めるための対話相手」として活用する能力を育成することを目的とする。

- 評価方法の多様化:プロセスと対話を重視する

成果物(プロダクト)のみで評価する従来の方法は、AIによる代替のリスクに常に晒される。したがって、レポートや筆記試験への依存度を下げ、学生の思考のプロセスや人間的な対話の中でしか評価できない能力を重視する評価方法を、積極的に組み合わせる必要がある 4。 - 具体的な評価方法としては、

- 口頭試問・個人面談: 提出されたレポートの内容について、学生に口頭でその論理的根拠や背景知識を説明させることで、真の理解度を確認する 4。

- プロセス評価(ポートフォリオ評価): 最終的な成果物だけでなく、アイデア出しのメモ、複数回の下書き、修正の履歴といった、成果物に至るまでの学習プロセス全体を評価の対象とする 4。

- 対面での活動評価: 授業内でのディスカッションやグループワークへの貢献度、発言の質といった、AIが介在しにくい対面での活動を評価に組み込む 4。

6.2 AIリテラシー教育の必須化:学生と教員双方へのアプローチ

生成AIを責任ある形で活用するためには、利用者である学生と、指導者である教員の両者が、高度なAIリテラシーを身につけることが不可欠である。これは個人の努力に任せるべきではなく、大学が組織として提供すべき必須の教育インフラである。

- 学生への体系的なリテラシー教育

多くの大学ガイドラインがAIのリスクを指摘しているが、それだけでは不十分である。生成AIの基本的な仕組み、技術的な限界(ハルシネーション、バイアスなど)、倫理的・法的リスク(著作権、個人情報保護)、そして効果的な活用法(プロンプトエンジニアリングの基礎など)を体系的に学ぶ機会を、全学的な必修科目や共通リテラシー科目として導入すべきである 39。重要なのは、単なるツールの使い方を教えるのではなく、AIの出力を常に批判的に吟味し、その社会的影響を理解し、責任を持って活用する「批判的AIリテラシー」を育成することである 50。 - 教員への継続的な支援と研修(FD/SD)

教員自身が生成AIの進化に取り残されていては、適切な指導や評価は不可能である。大学は、教員向けのファカルティ・ディベロップメント(FD)やスタッフ・ディベロップメント(SD)を組織的に、かつ継続的に提供する責務がある 30。 - 具体的な支援策としては、

- 研修会の実施: 最新のAI動向、プロンプトエンジニアリングの基本、AIを前提とした授業設計のワークショップなどを定期的に開催する 50。

- 情報共有の場の提供: 専門分野ごとの具体的な活用事例や失敗談を教員間で共有できるコミュニティやプラットフォームを構築する 33。

- 相談体制の整備: 授業設計や評価方法に関する個別の相談に応じる専門部署やメンター制度を設ける。

6.3 教員の役割変容と大学が提供すべき支援体制

生成AIの普及は、大学教員の役割そのものの変容を不可逆的に促す。この変容を前向きに捉え、支援する体制を構築することが、大学の未来を左右する。

- 教員の役割の再定義:知識の伝達者から学びの伴走者へ

生成AIが基本的な知識の伝達や要約といったタスクを代替する時代において、教員の専門性の核は、もはや「知識を一方的に伝達すること」にはない。これからの教員に求められるのは、学生一人ひとりの知的好奇心や探求心を引き出し、彼らが自ら問いを立て、学ぶプロセスを支援し、AIにはできない人間ならではの深い対話を通じて批判的・創造的思考を促す「ファシリテーター」「コーチ」「メンター」としての役割である 29。 - 大学による教員の負担軽減と支援

この高度な役割変容を教員に求めるのであれば、大学はまず、教員の負担を軽減するための環境整備に投資すべきである。皮肉なことに、そのための最も強力なツールこそが生成AIである。シラバスの原案作成、小テスト問題の自動生成、ルーブリックに基づいたレポートの一次評価、授業準備のための資料収集など、教育活動に付随する定型的な業務にAIを積極的に導入することで、教員の時間を大幅に節約することができる 49。こうして創出された時間を、教員が学生との対話や、より創造的で質の高い教育活動の設計に充てられるようにすることこそ、大学が果たすべき組織的な責任である 29。

最終結論:脅威ではなく、教育の本質を問い直す触媒として

大学教員が生成AIに抱く一連の懸念は、決して単なる杞憂や時代への不適応ではない。それは、学問の根幹をなす「知の誠実性」と「人間の知的成長」を守ろうとする、教育者としての正当かつ真摯な危機感の表れである。

しかし、本レポートの分析が示してきたように、この巨大な技術的潮流に背を向け、禁止や制限のみで対抗することは、もはや不可能であり、教育的にも得策ではない。むしろ、大学が今なすべきことは、生成AIという強力な「鏡」に映し出された現代の大学教育が抱える課題—知識偏重のカリキュラム、画一的な成果物評価、学生の受動的な学習姿勢—と真摯に向き合うことである。

生成AIは、我々に問いかけている。AIが瞬時に情報を生成できる時代に、人間が大学で学ぶことの真の価値とは何か。AIには育成できない、人間ならではの能力—複雑な現実の中から本質的な問いを発見する能力、多様な価値観と対話し合意を形成する能力、倫理的なジレンマに直面した際に深く悩み抜き判断を下す能力、そして未知の領域に踏み出す創造性—を、我々はいかにして育むことができるのか。

この根源的な問いに答えるための努力の中にこそ、大学の未来は存在する。その意味で、生成AIは大学教育を破壊する脅威であると同時に、その教育の本質を我々に問い直し、より高次の次元へと進化させるための、またとない強力な「触媒」となりうるのである。この挑戦に応える覚悟と実行力が、今、日本のすべての大学に問われている。

引用文献

- AI(人工知能)とは?歴史や仕組みまでわかりやすく解説! – 北海道科学大学 https://www.hus.ac.jp/hokukadai-jiten/detail/113dbef3f1ff85ff754818bbce23d944aa141c39-17164/

- チャットGPTは破壊者か? それとも変革者か? 揺れる教育現場 – MITテクノロジーレビュー https://www.technologyreview.jp/s/304856/chatgpt-is-going-to-change-education-not-destroy-it/

- 生成AIに関する注意点 | 生成AI教育ガイド | 私たちの取り組み | 大阪 … https://www.tlsc.osaka-u.ac.jp/project/generative_ai/important_point.html

- 評価における生成AIの影響 | 生成AI教育ガイド | 私たちの取り組み … https://www.tlsc.osaka-u.ac.jp/project/generative_ai/assessment_ai.html

- 生成AIと教育評価 [2024年度 No.2] https://www.juce.jp/LINK/journal/2501/02_07.html

- ChatGPTへの主要大学の対応まとめ | データサイエンス百景 https://ds100.jp/report/r-23003/

- AIを教育現場に導入するメリット・デメリットとは?活用事例を紹介 – AIsmiley https://aismiley.co.jp/ai_news/what-are-the-advantages-and-disadvantages-of-ai-for-education/

- 学生と教員を対象とした生成AIの 教育利用状況と意識に関する全国調査 – 仙台大学 https://www.sendaidaigaku.jp/dnt2/_sendaidaigaku/access/nic_img/1/files/20240716.pdf

- 筑波大生は生成 AI をどう使う? リスク認知とプロンプトの戦略を探る https://www.risk.tsukuba.ac.jp/pdf/group-work2024/report/2024_group_06_final

- 教育における生成AI活用のガイドライン2024(教員向け) – 筑波大学 https://www.tsukuba.ac.jp/about/action-management/pdf/AI-20241114134800-2.pdf

- 日本福祉大学 生成AI利用ガイドライン(学生向け) https://www.n-fukushi.ac.jp/users/students/ai-guideline/

- 生成AIツールをアカデミアで使用する際の、倫理的に「すべきこと」と「してはいけないこと」 – Editage Blog https://www.editage.jp/blog/the-dos-donts-of-using-generative-ai-tools-ethically-in-academia/

- 生成AIの利活用に関する学生向けガイドライン|文学部・文学研究科 社会学教室 – 大阪公立大学 https://www.omu.ac.jp/lit/soc/info/news1/entry-74220.html

- 生成AIの活用に関するガイドライン – 明治大学 https://www.meiji.ac.jp/keiei/6t5h7p00003c8zr3-att/seiseiai.pdf

- 十文字学園女子大学における生成AI利用ガイドライン | 教育・学修支援 https://www.jumonji-u.ac.jp/campuslife/ai_guidelines/

- 初等中等教育段階における生成AIの利用に関する暫定的なガイドライン – 文部科学省 https://www.mext.go.jp/content/20230718-mtx_syoto02-000031167_011.pdf

- 生成系AIの利用に関する留意事項 Notes on the Use of Generative AI – www.open-ed.hokudai.ac.jp/ – 北海道大学オープンエデュケーションセンター https://www.open-ed.hokudai.ac.jp/%E6%9C%AA%E5%88%86%E9%A1%9E/31-3.html

- 学生と教員を対象とした生成AIの 教育利用状況と意識に関する全国調査 https://www.nii.ac.jp/event/upload/20241106-3_saito.pdf

- 教育における生成AI活用のELSI(倫理的・法的・社会的課題)と未来展望 | 研究プログラム https://www.tkfd.or.jp/research/detail.php?id=4664

- 高校・大学の先生、チャットGPT等生成AIの利用に「思考力低下」へ … https://www.kawaijuku.jp/jp/news/detail.html?id=593

- 生成AIを活用した探求学習ガイドブック #6 (教育に悪影響がある生成AIの使い方) – Qiita https://qiita.com/hisaho/items/842c433ac6bbbeaf43e8

- 生成AIによるプログラミングが学習効果に与える影響 – 教育システム情報学会 https://www.jsise.org/wp-content/uploads/2025/02/2024_kansai_p09.pdf

- 人類智慧同步喪失,研究:AI 工具用愈多認知力愈差 https://csrone.com/news/9136

- 为什么越使用AI,越活得像个AI—新闻 – 科学网 https://news.sciencenet.cn/htmlnews/2024/5/522304.shtm

- 生成系 AI が大学での成績評価に及ぼす影響 https://www.nii.ac.jp/event/upload/20230909-06_Kimura.pdf

- 生成AIの不正利用を回避し、適切なライティングを実践するための5つのポイント https://www.turnitin.jp/blog/5-easy-tips-for-safeguarding-good-writing-practices-and-navigating-ai-misuse-jp

- 学生がChatGPTを使いすぎると成績とモチベーションが低下するとの研究結果 – GIGAZINE https://gigazine.net/news/20250528-chatgpt-study-grades-motivation-ai/

- レポート採点AIの可能性 ~AIは教員の負担軽減と学習効果向上につながるのか~ | 柏村 祐 https://www.dlri.co.jp/report/ld/324880.html

- 生成 AI を教育にどう活用すべきか https://www.dlri.co.jp/files/ld/285589.pdf

- 教育現場における 生成Alの利活用に向けて https://www.mext.go.jp/content/20240828-mxt_jogai01-000037621_008.pdf

- 生成AI時代の大学における成績評価 https://www.juce.jp/LINK/journal/2501/pdf/02_08.pdf

- AI普及の今、学生はAIとどう付き合う? 東大AI研究会代表に聞く – 東大新聞オンライン https://www.todaishimbun.org/todaiaiken_20250116/

- 当面の全学構成員向け生成AIサービス提供方針について | utelecon https://utelecon.adm.u-tokyo.ac.jp/notice/2024/0327-ai-service

- 東大生が生成AIを活用した2030年のビジネス・サービスを提案。次世代AI人材を育むデータハッカソン開催 – ITをもっと身近に。ソフトバンクニュース https://www.softbank.jp/sbnews/entry/20250417_02

- ChatGPT「上智大:レポート等で原則使用禁止 処分も」「東大:AIのみを用いた論文禁止」大学で規制・注意喚起相次ぐ https://www.jinken-net.org/jiken/?p=1837

- 日米で進む大学での生成AI活用、今後は「利用が必須になる」かも … https://www.sbbit.jp/article/cont1/134272

- アメリカの大学は理工系以外の学生向けのAI講座を増やしている | Business Insider Japan https://www.businessinsider.jp/article/2503-ai-education-courses-increasingly-popular-non-stem/

- 教育における生成 A I:英国教育省声明 – 国立教育政策研究所 https://www.nier.go.jp/05_kenkyu_seika/pdf_seika/r06/Generative_artificial_intelligence_in_education_UK.pdf

- 大学生のAI利用実態2025 / イギリスの最調査 / 教育関係者向け – note https://note.com/tyaperujp01/n/n6b322606cf5d

- 世界の大学による生成型AIツール利用のガイドライン – Editage Blog https://www.editage.jp/blog/guidelines-for-generative-ai-use-from-universities-worldwide/

- 学生と教員を対象とした生成AIの教育利用状況と意識に関する 全国調査の報告書作成のお知らせ| News | 仙台大学 https://www.sendaidaigaku.jp/news.html?post=5126

- ICTと教育の進化 学校における技術導入の歴史と現状 https://ict.stylemap.co.jp/ict%E3%81%A8%E6%95%99%E8%82%B2%E3%81%AE%E9%80%B2%E5%8C%96%E3%80%80%E5%AD%A6%E6%A0%A1%E3%81%AB%E3%81%8A%E3%81%91%E3%82%8B%E6%8A%80%E8%A1%93%E5%B0%8E%E5%85%A5%E3%81%AE%E6%AD%B4%E5%8F%B2%E3%81%A8/

- 情報リテラシーとは?簡単に解説!自分を守るために情報リテラシーがない人にはリテラシー教育が必要! – Spaceship Earth(スペースシップ・アース)|SDGs・ESGの取り組み事例から私たちにできる情報をすべての人に提供するメディア https://spaceshipearth.jp/internet-literacy/

- スマホ依存と学力の関係性 平均点数にして10点以上の差が – キャリア教育ラボ https://career-ed-lab.mynavi.jp/career-column/1084/

- AI通訳・翻訳の使用が学生の英語学習意欲に与える影響 – Effects of … https://www.seiryo-u.ac.jp/u/research/gakkai/ronbunlib/j_ronsyu_pdf/no52/02_yokono_52.pdf

- AI 翻訳の外国語教育への影響を考える – 獨協大学 https://www2.dokkyo.ac.jp/ger/resources/%E3%83%89%E3%82%A4%E3%83%84%E5%AD%A6%E7%A0%94%E7%A9%B6/81/01-22_kimura.pdf

- 大学のレポートや卒業論文に生成AIを用いることの是非 – yoppa org https://yoppa.org/blog/17359.html

- 生成 AI は大学教員になれるのか https://cgu.repo.nii.ac.jp/record/2000016/files/g6-1-6.pdf

- 生成AI導入のメリットと注意点!教育現場での効率化事例解説と未来の学びを推進する方法 https://aka-link.net/ai-efficiency-education/

- オンラインを活用した生成AIに関する 教員向け研修の取り組みをふまえた政策提言 – 東京財団 https://www.tkfd.or.jp/research/detail.php?id=4616

- 生成aiを教育で活用した実践事例とメリットデメリットを現場目線で徹底解説 | AI https://assist-all.co.jp/column/ai/20250624-5693/

- 東大松尾豊教授と考える「生成AI時代の教育」とは? | データサイエンス百景 https://ds100.jp/report/r-23011/

- 授業における生成AIの活用法 – 大阪大学 全学教育推進機構 教育学習支援部 https://www.tlsc.osaka-u.ac.jp/project/generative_ai/support_al.html

- 大学での生成AIの活用事例5選|4つのメリットや注意点も紹介 – AI … https://metaversesouken.com/ai/generative_ai/university/

- 教育現場における生成AI活用事例|りんか | AI情報発信 /ビジネス/研究 – note https://note.com/gabc/n/nab057c874ee7