第1章 スケーリングの壁:大規模言語モデルにおける収穫逓減と停滞

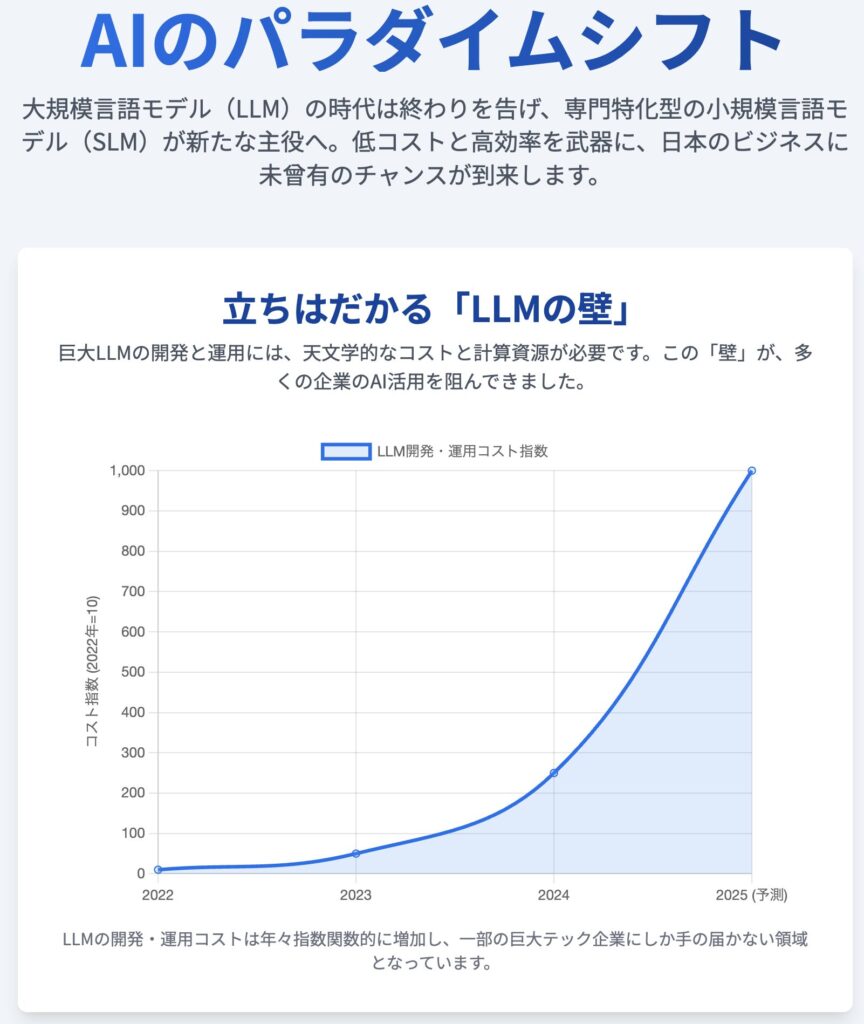

人工知能(AI)開発の最前線では、長らく「大きいことは良いことだ」という思想が支配的であった。この思想の根底には、モデルのパラメータ数、学習データ量、そして計算資源を増大させれば、性能が予測可能に向上するという「スケーリング則(Scaling Law)」が存在した 1。この法則に導かれ、AI業界は数十億から数兆パラメータにも及ぶ大規模言語モデル(LLM)の開発に巨額の投資を続けてきた。しかし、この指数関数的な成長パラダイムは、今や技術的・経済的な限界に直面しつつある。性能向上の鈍化、天文学的に膨れ上がるコスト、そして学習データの枯渇という「三重の壁」が、LLMの未来に影を落としている。本章では、LLMのスケールアップ戦略が直面する根本的な限界を多角的に分析し、来るべきパラダイムシフトの必然性を明らかにする。

1.1. スケーリング則の崩壊と新たな限界の出現

LLM開発競争を牽引してきたスケーリング則は、無限に続く魔法の杖ではないことが明らかになってきた。複数の査読済み研究を統合した分析によれば、スケーリング則は特定の閾値を超えると崩壊し、利用可能な資源の量に関わらず達成可能な性能に絶対的な限界を生み出すことが示されている 2。これらの限界は、単なる実用上の問題ではなく、数学的な不可能性定理、データ枯渇、アーキテクチャ上の制約といった、より根源的な要因に起因している 2。

特に、複雑な推論能力の向上は、単純なスケールアップだけでは達成できないことが指摘されている。モデルサイズを大きくすることが、かえって推論性能に悪影響を及ぼし、アライメント(AIの挙動を人間の意図に沿わせること)や堅牢性において新たな課題を生むことがある 1。例えば、推論のステップ数を単純に増やすだけでは、エラーが累積・増幅し、結果的に精度が低下する可能性がある 1。

このような現実を受け、AI研究の現場では、単純なスケーリング則への盲信から、より洗練された「性能則(Performance Law)」へと関心が移りつつある 3。性能則は、モデルアーキテクチャ、データ分布、計算精度といった多様な要因を考慮に入れ、限られた予算内で最大の性能を引き出すための指針を与える 3。この変化は、AI開発が力任せのスケールアップ競争から、より知的で効率的な設計を重視する成熟期へと移行しつつあることを示唆している。

1.2. 経済的な壁:持続不可能な訓練・推論コスト

フロンティアモデルの訓練コストは、指数関数的に高騰している。2019年に15億パラメータを持つGPT-2の訓練コストが約5万ドルであったのに対し、2022年のPaLM(5400億パラメータ)は800万ドル、2021年のMegatron-Turing NLG(5300億パラメータ)は約1100万ドルに達した 4。日本国内においても、基盤モデルの開発には「数千万円規模のコスト」と「山のような技術的課題」が伴うと報告されている 5。

このような莫大な資本と計算資源の要求は、フロンティアモデルの開発を一部の巨大テック企業に限定し、より広範なイノベーションや健全な市場競争を阻害する深刻な参入障壁となっている 7。さらに、環境への影響も無視できない。例えば、GPT-3の訓練には推定1,287 MWhの電力が消費されたが、これは米国の平均的な家庭120年分のエネルギー消費量に相当する 7。こうした経済的・環境的な持続不可能性は、より効率的な代替技術の探求を促す主要な動機となっている 9。

1.3. データという壁:高品質な学習コーパスの枯渇

LLMは「データによって駆動される」存在である 10。しかし、その燃料となる高品質な人間が書いたテキストデータは、もはや無限の資源ではない。コーネル大学の研究者らが引用した研究によれば、高品質な英語のテキストデータは早ければ2024年にも枯渇する可能性が示唆されていた 10。また、AI研究機関Epoch AIは、高品質な英語テキストのストックが2026年から2032年の間に完全に利用し尽くされると予測している 11。

この問題に拍車をかけているのが、「合成インターネット(Synthetic Internet)」現象の台頭である。現在、ウェブ上の新規コンテンツのかなりの部分がAIによって生成されており 4、その割合は最大30%に達する可能性も指摘されている 13。新しいモデルを古いモデルの出力で訓練することは、一種の「モデル近親交配」であり、世代を重ねるごとに性能が劣化する「モデル崩壊」を引き起こす危険性をはらむ 12。このため、開発者はデータクリーニングやフィルタリングに多大な労力を費やすか、あるいは事実性や多様性の観点で課題を抱える合成データに頼らざるを得ない状況に追い込まれている 4。

1.4. 性能のプラットフォーム化:収穫逓減の明確な証拠

主要なベンチマークにおいて、LLMの性能向上率が鈍化しているという事実は、収穫逓減の法則が働き始めていることを明確に示している。GPT-3.5からGPT-4への飛躍は、主要ベンチマークで15%から25%という劇的な性能向上をもたらしたが、その後のGPT-4からGPT-4oへの改善は3%から7%にとどまった 13。

知識や推論能力を測るMMLUベンチマークにおいても同様の傾向が見られる。GPT-4の登場により、スコアは80%台後半まで急速に上昇したが、それ以降、Claude 3.5やGemini Ultraといった後続の最新モデルも同水準に密集し、わずかな差を競う状況となっている 11。これは、技術開発における典型的なS字カーブのパターンであり、業界全体が急成長期から成熟期へと移行し、性能がプラットフォーム化(頭打ち)しつつあることを示している 11。

この現状に対し、ゲイリー・マーカス氏のような著名なAI研究者や、OpenAIの元科学者など、多くの専門家が「スケールアップだけでは限界に達しつつある」という見解で一致し始めている 7。AI開発の焦点は、もはや「より大きく」から「より賢く」へとシフトしているのである 7。

これらのスケーリング、経済、データの壁が同時に顕在化する状況は、AI業界にとって古典的な「イノベーターのジレンマ」の構図を生み出している。巨大LLMという既存パラダイムに巨額の投資を行ってきた支配的なプレイヤーたちは、より効率的でコスト効率に優れ、特定の現実世界のアプリケーションにおいて優れた価値を提供する破壊的技術、すなわち小規模言語モデル(SLM)の台頭に対して脆弱である可能性がある。AIの進化におけるこの停滞は、技術の終わりを意味するのではなく、SLMを中心とした、より現実的で経済的に実行可能な新しいアプローチへの扉を開く戦略的な転換点なのである。

第2章 小規模の台頭:効率的で高性能なAIの新パラダイム

大規模言語モデル(LLM)がスケーリングの壁に直面する一方で、AI開発の新たな潮流として小規模言語モデル(SLM)が急速に台頭している。SLMは、単にLLMを縮小したものではなく、効率性、専門性、そして現実世界への展開を最適化するために設計された、まったく新しいクラスのモデルである。本章では、SLMを定義し、その技術的・ビジネス的利点を詳細に分析する。ここでの中心的な論点は、SLMがLLMの「廉価版」ではなく、多くの応用分野においてより優れたソリューションを提供する、独自の価値を持つパラダイムであるということだ。

2.1. 小規模言語モデル(SLM)の定義

SLMは、LLMと比較してパラメータ数が大幅に少ないAIモデルを指し、その規模は数百万から数十億の範囲に及ぶ 15。例えば、約1.76兆のパラメータを持つとされるGPT-4に対し、MicrosoftのPhi-3-miniは38億パラメータである 17。

SLMの創出は、単なるモデルの小型化にとどまらない。知識蒸留(Knowledge Distillation:大規模な「教師モデル」から知識を転移させる)、量子化(Quantization:モデルの重みの精度を下げてサイズを圧縮する)、プルーニング(Pruning:不要なパラメータを刈り込む)といった高度な技術が用いられる 9。

特に画期的なのは、MicrosoftのPhiシリーズなどが開拓した「量より質」のデータ哲学である。このアプローチでは、インターネットから無差別に収集した巨大なデータセットではなく、合成データを含む、高度にキュレーションされた「教科書品質」の小規模なデータセットで訓練を行う 21。これにより、はるかに小さなモデルでも、従来は巨大モデルでしか見られなかった高度な推論能力を獲得することが可能になった。

2.2. SLMがもたらす圧倒的な利点

SLMは、そのコンパクトな設計思想から、LLMにはない数多くの利点を生み出す。

- コスト効率性: SLMは、開発から運用までのライフサイクル全体でコストを劇的に削減する。

- 訓練コスト: 計算能力、時間、エネルギー消費が大幅に少なく済むため、スタートアップ、学術機関、そして一般企業にとってAI開発のハードルを劇的に下げる 17。訓練期間は、数千基のGPUで数ヶ月を要するLLMとは対照的に、数基のGPUで数日から数週間で完了する 19。

- 推論コスト: 実行時のメモリや電力消費が少ないため、大量の処理を伴うアプリケーションに最適であり、コスト効率の高いスケーリングを可能にする 15。スタンフォード大学のAI Indexレポートによると、GPT-3.5レベルの性能を持つシステムの推論コストは、高性能な小型モデルの登場により280倍以上も低下した 32。

- 性能と速度:

- 低遅延: モデルサイズが小さいため処理が高速であり、秒未満の応答時間を実現する。これは、対話型チャットボット、産業用制御システム、オンデバイスアシスタントなど、リアルタイム性が不可欠なアプリケーションにおいて決定的に重要である 15。

- 展開の柔軟性:

- エッジ&オンデバイスコンピューティング: SLMは軽量であるため、スマートフォン、PC、IoT機器といった消費者向けハードウェア上で、クラウド接続なしに直接実行できる 9。例えば、MicrosoftのPhi-3-miniは量子化によりiPhone上で動作可能である 23。

- 専門性と精度:

- 目的に特化した性能: SLMは専門特化のために設計されている。医療、法律、金融といった特定のドメインデータでファインチューニングされると、その分野のタスクにおいては、はるかに大規模な汎用LLMと同等、あるいはそれを上回る性能を発揮することが多い 16。

- ハルシネーションの抑制: 限定的で高品質なデータセットで学習するため、LLMの大きな課題である事実に基づかないもっともらしい嘘を生成する「ハルシネーション」のリスクが低減される 17。

- ガバナンス、プライバシー、セキュリティ:

- データ管理: SLMはオンプレミス環境やプライベートクラウド内に展開できるため、企業は機密性の高い独自データや顧客情報を完全に自社の管理下に置くことができる 15。これは、データを外部のLLM APIに送信することに伴うセキュリティやコンプライアンス(GDPR、HIPAAなど)のリスクを回避する上で、極めて重要な利点となる。

2.3. 「小さいは弱い」という神話の打破:最先端SLMの性能

SLMが単なる「小さなLLM」ではなく、特定のタスクにおいてLLMに匹敵、あるいは凌駕する能力を持つことは、近年の最先端モデルのベンチマーク結果によって証明されている。

- Microsoft Phi-3: 3.8B(mini)、7B(small)、14B(medium)のパラメータを持つPhi-3ファミリーは、高品質な合成データを活用することで、Mixtral 8x7BやGPT-3.5といったはるかに大きなモデルとMMLUやMT-Benchなどのベンチマークで競合する性能を達成した 21。特に3.8Bの「mini」モデルは、スマートフォン上でローカルに動作するように設計されている 21。

- Google Gemma: GoogleのオープンモデルであるGemmaファミリー(Gemma 2B/7B、および最大27BのGemma 3)は、同社のフラッグシップモデルGeminiの研究成果を基に構築されており、特に数学や科学、コーディングといったSTEM分野で高い性能を示す 45。最新のGemma 3は、小型サイズでありながらマルチモーダル対応と128Kの長いコンテキスト長を実現している 46。

- Meta Llama 3 8B: MetaのLlama 3 8Bモデルは、15兆トークンという大規模なデータセットとGrouped Query Attention (GQA)などのアーキテクチャ改良により、Llama 2から飛躍的な進化を遂げた 51。MMLU、GSM8K、HumanEvalといった主要ベンチマークにおいて、同規模のモデルクラスで最高の性能を確立している 54。

| モデル名 | 開発元 | パラメータ数 | 主要なアーキテクチャ/特徴 | コンテキスト長 (トークン) | MMLU (5-shot) | GSM8K (8-shot, CoT) | |

| Microsoft Phi-3-mini | Microsoft | 3.8B | 高品質な合成データで訓練 | 128K | 68.8% | 82.5% | |

| Google Gemma 3 4B-IT | 4B | マルチモーダル、ローカル/グローバルアテンション | 128K | N/A | N/A | ||

| Meta Llama 3 8B-Instruct | Meta | 8B | GQA、15兆トークンのデータで事前学習 | 8K | 68.4% | 79.6% | |

| GPT-3.5-Turbo (参考) | OpenAI | (非公開) | – | 4K-16K | ~71.4% | ~86.4% | |

| 出典: 各モデルの技術報告書およびベンチマークデータ 21 |

この比較から明らかなように、SLMは多くの重要なタスクにおいて、はるかに大きなモデルに匹敵する、あるいはそれを超える能力を示している。

SLMの台頭は、最先端AI開発の「民主化」を意味する。これまでAIのリーダーシップは、最大のスーパーコンピュータと最大のデータセットを持つ組織の代名詞であった 4。しかし、Phi-3のようなモデルの成功は、データの「質」がデータの「量」やモデルの「サイズ」を代替しうることを証明した 21。イノベーションの源泉はもはやハードウェアだけでなく、データキュレーションや合成データ生成といった方法論に移っている。これらの新しい手法は、巨大なGPUクラスタを構築するよりも資本集約的ではない 9。これにより参入障壁が下がり、深いドメイン知識と高品質な独自データを持つ企業が、GoogleやMicrosoftのようなリソースを持たずとも、特定の分野で最先端の特化型モデルを開発できるようになった 26。SLMの時代における競争優位性は、「誰が最も多くの計算能力を持つか」から、「誰が最も優れた、関連性の高いデータを持ち、最も賢い訓練戦略を立てられるか」へと根本的に変化している。

第3章 日本の戦略的転換点:SLMがもたらす好機を掴む

世界的なAI開発の潮流が大規模から小規模へと移行する中、日本企業にとって歴史的な好機が訪れている。SLMの特性は、日本の産業構造、技術的強み、そして経済的現実と見事に合致する。本章では、SLMがなぜ日本にとって戦略的な転換点となりうるのかを、経済的、産業的、そしてエコシステムの観点から深く掘り下げる。LLM開発競争で直面した障壁を乗り越え、応用AIの分野で世界的なリーダーシップを確立するための道筋が、ここに示されている。

3.1. 開発の壁を乗り越える:経済的・戦略的必然性

これまで日本の企業がLLM開発競争で苦戦を強いられてきた一因は、その莫大なコストにあった。「数千万円かかるコスト」と「山のような技術的課題」が、多くの企業にとって高い壁となっていた 5。

SLMは、この力学を根本から覆す。開発コストの大幅な削減 17、訓練期間の短縮 17、そして計算資源消費の低減 29 により、AI開発はもはや一部の巨大テック企業だけの独占物ではなくなる。これにより、日本の大企業だけでなく、中堅・中小企業やスタートアップも、自社のニーズに合わせたAIソリューションを開発・導入することが可能になる 26。

さらに、SLMがオンプレミス環境やプライベートクラウド内で訓練・実行できるという特性は、日本企業にとって極めて重要である 27。金融や医療といった規制の厳しい業界では、機密性の高い顧客データや企業情報を国外のクラウドプロバイダーに送信することへの抵抗感が強い。SLMは、このデータ主権とセキュリティの課題を解決し、安全なAI活用を促進する鍵となる。

3.2. 産業シナジー:日本の強みとSLMの融合

SLMの特性は、日本の伝統的な産業の強みと深く共鳴し、新たな価値創出の触媒となる。

- 高品質な製造業と「カイゼン」: 精密さ、品質管理、そして継続的改善(カイゼン)を追求してきた日本の製造業は、SLMにとって理想的な応用分野である 58。専門化されたSLMを工場の生産ラインに導入することで、リアルタイムでの外観検査の自動化 58、機械の予知保全 61、生産プロセスの最適化 60、そして知能化した産業用ロボットの制御 64 など、現場レベルでの革新が期待できる。

- 組み込みシステムとロボティクス: 日本は、組み込みシステム、ロボティクス、自動車技術において世界をリードする存在である 65。SLMの軽量性は、これらの分野に革命をもたらす。家電製品やスマートホームデバイスから、自動車のインフォテインメントシステムや制御ユニットに至るまで、あらゆる機器に高度な知能を組み込むことが可能になる 9。これは、日本のハードウェア産業が「フィジカルAI」という巨大な成長機会を掴むための道筋を示すものである 67。

- 全産業へのAI民主化: SLMの導入しやすさは、日本の多様な経済セクター全体にAIの恩恵を広げる。

- 金融: 金融機関は、データプライバシーを確保しながら、リスク分析、コンプライアンスチェック、顧客対応に特化したSLMを自社内で開発・運用できる 27。

- 医療: 病院システム内で安全に稼働するSLMが、カルテの要約、診断支援、患者とのコミュニケーションを補助し、医療従事者の負担を軽減する 27。

3.3. 先駆者たち:日本の新興SLMエコシステム

SLMがもたらす好機は、もはや理論上の可能性ではない。日本の革新的な企業群は、すでにこの流れを捉え、具体的な行動を開始している。

- 大手技術企業:

- NTT: 高い日本語処理能力とマルチモーダル対応を特徴とする軽量(70億および6億パラメータ)なLLM「tsuzumi」を開発。オンプレミスでの運用を想定し、企業のデータセキュリティニーズに応える 75。

- NEC: 「cotomi Pro」および「cotomi Light」を開発。GPT-4やGPT-3.5といったグローバルモデルに匹敵する性能を、大幅に高速な推論速度で実現し、ビジネス応用をターゲットにしている 75。

- 富士通: 信頼性と安全性を重視したAIプラットフォーム「Fujitsu Kozuchi」を提供。業務支援に特化した独自の生成AIコンポーネントを含む 75。

- デジタルネイティブ企業:

- 楽天: 日本語に最適化され、エッジデバイスでの効率的な運用を目的としたオープンソースモデル「Rakuten AI 2.0 mini」(15億パラメータ)を公開 84。

- ELYZA & rinna: ELYZAによるLlama 2の日本語ファインチューニングモデルや、rinnaの対話型AIなど、日本語の機微を深く理解したモデル開発の先駆者として、国内のAI技術を牽引 84。

- 革新的スタートアップ:

- Sakana AI: 「進化的モデルマージ」や知識蒸留技術「TAID」といった独創的な手法を開拓。既存モデルから「TinySwallow-1.5B」のような高性能かつ効率的なSLMを生み出し、世界的に注目を集めている 90。

| モデル/プラットフォーム | 開発元 | パラメータ数 | 主要な特徴/イノベーション | 主な用途 | |

| tsuzumi | NTT | 7B / 0.6B | 軽量、高い日本語能力、マルチモーダル、オンプレミス対応 | コンタクトセンター、業界特化システム | |

| cotomi Light | NEC | (非公開) | 高速推論(GPT-3.5級性能)、省エネルギー | 業務自動化、組み込みシステム | |

| Fujitsu Kozuchi | 富士通 | (様々) | 信頼性・安全性を重視したAIプラットフォーム、業務特化AI | 企業のAI導入支援、業務プロセス改善 | |

| Rakuten AI 2.0 mini | 楽天 | 1.5B | 日本語最適化、オープンソース、エッジデバイス向け | モバイルアプリ、プライバシー重視の現場 | |

| TinySwallow-1.5B | Sakana AI | 1.5B | 知識蒸留技術「TAID」採用、軽量で高性能 | オフライン動作、スマートフォン・PC向け | |

| ELYZA-japanese-Llama-2 | ELYZA | 13B | Llama 2をベースに日本語能力を高度に拡張 | 高度な日本語タスク、対話システム | |

| 出典: 各社プレスリリースおよび技術文書 75 |

LLM競争が、巨大な汎用ウェブデータとGPUクラスタへのアクセス能力によって定義され、米国の巨大テック企業に有利な状況であったのに対し、SLMパラダイムは専門性を重視する 7。SLMの性能は、そのファインチューニングに用いられるドメイン特化データの質に決定的に依存する 38。日本の自動車 96、先端材料、ロボティクス 64、精密製造 58 といった基幹産業の企業は、インターネット上には存在しない、極めて価値の高い膨大な独自データを数十年にわたり蓄積してきた。センサーデータ、製造プロセスログ、品質管理画像、研究開発文書、顧客サポート記録などがそれに当たる。

Llama 3やPhi-3のようなコスト効率の高いオープンソースSLM、あるいはtsuzumiのような国産モデルを、これらの独自データでファインチューニングすることにより、日本企業は、海外の競合他社のいかなる汎用LLMも及ばない、自社の特定ニッチ分野における世界最高のAIモデルを創出することができる。SLMの時代において、日本の基幹産業が持つ「データの堀(Data Moat)」は、決定的な戦略的資産となる。ここでの好機は、より優れたGPT-4を構築することではなく、半導体製造、バッテリー化学、あるいはロボットオートメーションのための世界最高のAIを構築することにある。

第4章 アーキテクチャの進化:現代の企業システムにおけるSLMの展開

AI開発のパラダイムがLLMからSLMへと移行する中で、その価値を最大限に引き出すためには、企業システムへの統合方法、すなわちアーキテクチャも進化させる必要がある。本章では、SLMが実現する新しいアーキテクチャパターンを技術的かつ分かりやすく解説する。モノリシックな巨大AIから、より堅牢でスケーラブル、そして知的なアプリケーションを構築するための、マイクロサービスとAIエージェントという二つの先進的なアプローチに焦点を当てる。

4.1. モノリスから専門家集団へ:マイクロサービスアプローチ

すべてのタスクを単一の巨大なLLMに依存するアプローチは、システム全体を単一障害点(Single Point of Failure)とし、開発のボトルネックを生み出す 38。この「モノリシックLLM」は、更新、保守、そして特定業務への特化が困難な「ブラックボックス」となりがちである。

これに対し、より回復力と俊敏性に優れたアプローチが、複雑なアプリケーションを、それぞれが専門のSLMによって駆動される、小さく独立したサービスの集合体へと分解するマイクロサービスアーキテクチャである 15。例えば、電子商取引プラットフォームを構築する場合、レビューの感情分析、商品説明文の生成、顧客対応チャットボット、請求書からのデータ抽出といった各機能を、それぞれに特化したSLMが担うマイクロサービスとして実装することができる 15。

このように複数のSLMを組み合わせる「スタッキングSLM」アプローチは、システム全体の回復力(一つのサービスの障害が全体を停止させない)、技術的多様性(各タスクに最適なモデルを選択可能)、そして保守とスケーリングの容易性を飛躍的に向上させる 15。

このアーキテクチャにおいて重要な役割を果たすのがAPIゲートウェイである。APIゲートウェイは、クライアントからのリクエストを一元的に受け付け、適切なSLMマイクロサービスへと振り分ける単一の窓口として機能する 99。これにより、クライアント側のロジックが簡素化され、認証や流量制限といった横断的な関心事が一箇所に集約されるため、クライアントと内部サービスアーキテクチャの疎結合が実現される。

4.2. AIエージェントの台頭:SLMの群知能

AIエージェントとは、環境を認識し、計画を立て、目標達成のために自律的に行動するシステムである 16。NVIDIAが発表した重要な論文では、AIエージェントの未来は、単一のモノリシックなLLMではなく、複数の専門化されたSLMから成る異種混合システム(Heterogeneous System)にあると主張されている 103。

このアーキテクチャでは、より大規模な「プランナー」あるいは「オーケストレーター」モデルが、「大阪への出張を計画せよ」といった複雑なユーザーの要求を、一連のサブタスクに分解する。そして、これらのサブタスクは、フライト検索、ホテル予約、カレンダー確認など、特定のツールやドメインに特化した高度に効率的なSLMの「群れ(Swarm)」に委任される 106。

エージェントのワークフローは、API呼び出しやデータ抽出といった、反復的で、範囲が限定された、非対話的なタスクで構成されることが多い。このようなタスクに対しては、SLMが圧倒的に優れている。なぜなら、推論コストが10倍から30倍も安く、応答時間が短く(低遅延)、そして狭いタスクにおける挙動がより信頼でき、予測可能だからである 104。

さらに、最新の研究では、エージェントがツールや環境と対話することで自律的に訓練データを生成し、継続的に学習・改善していくフレームワークが提案されている 109。このような自己改善ループは、SLMを用いることで、よりコスト効率よく実現可能となる。

ソフトウェア工学の歴史が、巨大なモノリシックアプリケーションから、小さく独立したコンポーネントで構成されるマイクロサービスへと進化したように、AIのアーキテクチャもまた、「モノリスとしてのAI」から「構成可能なシステムとしてのAI」へと移行している 97。この変化は、AIソリューションの設計、構築、保守の方法を根本から変える。AIシステムの構築は、もはや一つの巨大モデルを訓練することではなく、適切なサブタスクを特定し、それぞれに最適なSLMをファインチューニングし、それらを堅牢なAPIやエージェントフレームワークを介して連携させる「システムインテグレーション」と「ワークフローオーケストレーション」の技術が中心となる。これは、まさに日本の広範なシステムインテグレーター(SIer)やエンタープライズソフトウェア開発企業の得意分野である。彼らの持つ深い業界知識と、ミッションクリティカルな複雑なビジネスシステムを構築・保守してきた中核的能力は、この新しい構成可能なAIシステムのアーキテクトとして、顧客企業に価値を提供する上で完璧に合致している。

第5章 ユビキタスインテリジェンスの時代:エッジで躍動するSLM

AIの進化は、その活動の場を中央集権的なデータセンターから、我々の日常生活や産業現場に遍在する無数のデバイスへと拡大させている。この「エッジAI」へのシフトを可能にする核心技術がSLMである。本章では、リソースに制約のある環境でSLMを展開することの変革的な可能性を探る。これは特に、日本のハードウェア中心の産業にとって、独自の優位性を築く絶好の機会となる。

5.1. オンデバイスAI:手の中の知性

SLMは、高度な最適化(量子化、プルーニング)を施すことで、現代のスマートフォン、PC、タブレットに搭載されているニューラルプロセッシングユニット(NPU)やCPU上で直接実行することが可能である 9。

この技術はすでに現実のものとなっている。MicrosoftのPhi-3-miniはiPhone上でオフライン動作し 21、GoogleのGemini NanoはPixelスマートフォンの機能を強化 114、そしてApple Intelligenceはプライバシーを保護するためにオンデバイス処理を優先している 111。これにより、リアルタイム翻訳、インテリジェントなカメラ機能、高速応答の音声アシスタントなど、プライバシーを損なうことなくパーソナライズされたユーザー体験が実現する 34。

5.2. 産業におけるエッジAI:スマートファクトリーとその先へ

エッジAIとは、データが生成されるデバイス上、あるいはその近傍(工場のセンサー、カメラ、産業用ロボットなど)でAIモデルを実行し、遠隔のクラウドにデータを送信するのを回避する技術である 9。SLMは、エッジAIを実現するための不可欠な要素である。

- 低遅延: 高速生産ラインでの欠陥検出や、作業員と機械の衝突防止など、リアルタイムの制御と安全性が求められるアプリケーションには、ミリ秒単位の応答が不可欠である 27。

- 帯域幅の削減: 大量のセンサーデータや映像データをローカルで処理することで、膨大なデータをクラウドにストリーミングするコストと複雑さを回避できる 9。

- オフライン運用: 遠隔地のインフラ、船舶、あるいは無線接続が不安定な工場内など、インターネット接続が断続的、あるいは全くない環境でも、インテリジェントシステムを安定して稼働させることができる 27。

- データセキュリティ: 機密性の高い操業データを工場内に留めることで、知的財産を保護し、サイバーセキュリティのリスクを低減する 41。

日本の産業界における具体的なユースケースは多岐にわたる。スマートファクトリーでは、SLMを搭載したビジョンシステムによる品質検査、センサーデータ分析による予知保全、そしてより適応性の高いロボットの実現が期待される 58。自動車産業では、車載SLMによる自然言語での車両機能制御や、高度運転支援システム(ADAS)の進化が考えられる 66。さらに、IoTやスマートインフラ分野では、監視カメラによるセキュリティ強化、農業センサーによる作物管理、スマートホームデバイスによるエネルギー管理など、応用範囲は無限に広がる 121。

クラウド中心のLLM時代が、ソフトウェアとデータセンターを主戦場とし、米国企業が構造的な優位性を持っていたのに対し、SLMが駆動するエッジAI時代は、物理的なデバイス、すなわちチップ、センサー、ロボットそのものがAIシステムの性能と効率を決定する重要な要素となる 112。エッジで最適な性能を発揮するためには、SLMとそれを実行するハードウェア(専用NPUなど)との協調設計が不可欠となる。これは、AIモデル開発者とハードウェア技術者の間の深い連携を要求する。

日本は、半導体設計、電子機器製造、そして高信頼性の産業用ハードウェア構築において、世界トップクラスの歴史と深い専門知識を有している 65。この強みは、次世代の「AIネイティブ」なハードウェア、すなわちIoTデバイス向けの低消費電力AIチップから、ロボティクスや自動車向けの統合制御ユニットまで、新たな市場を創出する上で決定的な優位性となる。これは単にAIを「利用する」機会ではなく、世界のユビキタスインテリジェンス経済を支える基盤プラットフォームそのものを「構築する」という、より大きく、より防御可能な経済的機会を意味している。

第6章 戦略的提言と将来展望

本レポートで詳述してきたように、AIの技術的・経済的潮流は、大規模から小規模へ、クラウドからエッジへ、そして汎用から特化へと大きくシフトしている。この地殻変動は、日本の産業界が持つ固有の強みを最大限に活かす、またとない機会を提供する。本章では、これまでの分析を総括し、日本の企業および政策立案者がこの好機を掴むための具体的な行動指針を提言する。

6.1. 日本企業への提言

- データ戦略を最優先事項とせよ: AI開発の思考法を「モデル中心」から「データ中心」へと転換することが急務である。今後の競争優位性は、高品質な独自データセットをいかに構築・活用できるかにかかっている。特に専門分野におけるデータガバナンス、クリーニング、そしてアノテーションへの戦略的投資が不可欠である 27。アノテーションのコストは、単純な画像分類で1枚数円から、複雑なタスクでは数百円に及ぶこともあり、その投資対効果を慎重に見極める必要がある 127。

- ポートフォリオアプローチを採用せよ: すべての課題を解決する単一の万能モデルを探すのではなく、オープンソースの基盤モデルと国産モデルを組み合わせ、複数の特化型SLMから成るポートフォリオを構築すべきである 38。まずはROI(投資収益率)の高い小規模なパイロットプロジェクトから着手し、社内の知見を蓄積しながら成功事例を積み重ねることが賢明である 117。

- 社内人材の育成に注力せよ: 初期開発は外部パートナーとの協業が有効であるが、長期的な成功は、データサイエンス、機械学習工学、そしてファインチューニングのスキルを持つ社内チームの育成にかかっている。SLMのファインチューニングは、LLMをゼロから構築するよりも技術的なハードルが低いため、これは十分に達成可能な目標である 17。

- オープンソースを積極的に活用せよ: Llama 3、Phi-3、Gemmaといった高性能なオープンソースモデルを、カスタムファインチューニングのための強力かつコスト効率の高い出発点として活用すべきである 85。さらに、エコシステムに貢献することで、集合的な技術進歩を加速させることができる。

6.2. 政策立案者および業界団体への提言

- 「データインフラ」を国家資産として推進せよ: 高品質かつ大規模な日本語および各産業分野のデータセットを整備し、AIモデルの訓練とベンチマークのための国家的な基盤を構築するイニシアチブを支援すべきである。

- エッジAIハードウェアに投資せよ: 次世代の低消費電力AIアクセラレータやNPUの研究開発に資金を投じるべきである。これらの重要部品に関する国内の半導体製造を優遇する政策を策定し、産業の空洞化を防ぐ必要がある。

- 標準化とセキュリティを確立せよ: 重要インフラ、製造業、医療といった分野でSLMを展開するための共通プラットフォームやセキュリティ基準の策定を奨励し、相互運用性と社会的な信頼を醸成すべきである。

6.3. 将来展望:応用・ユビキタスAIのリーダーとしての日本

本レポートの結論は明確である。AIを巡る技術的・経済的な風は、日本の産業的な強みに強く追い風となる方向に吹いている。SLMパラダイムを断固として受け入れることで、日本は、他国で開発されたAI技術の単なる消費者から、実用的で信頼性が高く、高度に統合されたAIソリューションを創出するグローバルリーダーへと変貌を遂げることができる。

未来のAI社会は、クラウド上に存在する単一の全知全能なAIによって支配されるのではなく、我々の社会と産業の隅々にまで埋め込まれた、無数の小さく専門的な知性のネットワークによって形作られるだろう。そのような未来において、日本は繁栄するためのまたとない好位置につけている。今こそ、その機会を掴むための行動を起こす時である。

引用文献

- A Survey of Scaling in Large Language Model Reasoning – arXiv https://arxiv.org/html/2504.02181v1

- Fundamental Limits of Large Language Model Scaling: Analysis of Mathematical Impossibility Theorems and Resource Constraints | by Dev Das | HackrLife | Sep, 2025 | Medium https://medium.com/hackrlife/fundamental-limits-of-large-language-model-scaling-analysis-of-mathematical-impossibility-theorems-53ece210e23e

- Performance Law of Large Language Models – arXiv https://arxiv.org/html/2408.09895v2

- Large language model – Wikipedia https://en.wikipedia.org/wiki/Large_language_model

- NTTが「LLMの学習コストを削減する」新技術を開発、tsuzumiへの導入目指す https://businessnetwork.jp/article/27112/

- 「数千万円かかるコスト」と「山のような技術的課題」 開発者たちが語る、日本語LLMの現在地 https://logmi.jp/main/technology/330362

- LLM Fatigue: Is Language Model Innovation Reaching a Plateau? – TechGig https://content.techgig.com/technology/are-we-hitting-a-plateau-in-large-language-model-innovation/articleshow/122808032.cms

- LLM performance is plateauing, causing some experts to believe AI crash is imminent https://getcoai.com/news/llm-performance-is-plateauing-causing-some-experts-to-believe-ai-crash-is-imminent/

- Why Are Small Language Models on the Rise – WDSAI https://www.wdsai.org/blogs/why-are-small-language-models-on-the-rise

- Award-Winning Paper Unravels Challenges of Scaling Language Models – Cornell Tech https://tech.cornell.edu/news/award-winning-paper-unravels-challenges-of-scaling-language-models/

- Is there a wall? An Evidence-Based Analysis of Diminishing Returns in Large Language Model Scaling: Investigating Benchmark Plateaus, Data Scarcity, and Computational-Economic Constraints | by Adnan Masood, PhD. | Medium https://medium.com/@adnanmasood/is-there-a-wall-34d02dfd85f3

- Is LLM progress plateauing? : r/ArtificialInteligence – Reddit https://www.reddit.com/r/ArtificialInteligence/comments/1lomj6i/is_llm_progress_plateauing/

- Why Progress in Non-Reasoning LLMs Has Plateaued: Analysis and Future Directions https://blog.leena.ai/why-progress-in-non-reasoning-llms-has-plateaued-analysis/

- Gary Marcus: AI models are reaching a performance plateau https://getcoai.com/news/ai-models-are-reaching-a-performance-plateau/

- Small language models vs. large language models | Invisible Blog – Invisible Technologies https://www.invisible.co/blog/how-small-language-models-can-outperform-llms

- Why Specialized, Small Language Models (SLMs) are Outperforming General-Purpose LLMs – OneReach https://onereach.ai/blog/small-specialized-language-models-vs-llms/

- SLM(小規模言語モデル)とは?LLMとの違いや企業導入のメリット・デメリット – AIsmiley https://aismiley.co.jp/ai_news/slm-explanation-advantages-and-disadvantages/

- LLMs vs. SLMs: The Differences in Large & Small Language Models | Splunk https://www.splunk.com/en_us/blog/learn/language-models-slm-vs-llm.html

- SLM vs LLM: The Key Differences – WEKA https://www.weka.io/learn/ai-ml/slm-vs-llm/

- What are Small Language Models (SLM)? – IBM https://www.ibm.com/think/topics/small-language-models

- Phi-3 Technical Report: A Highly Capable Language Model Locally … https://arxiv.org/pdf/2404.14219

- Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phone – arXiv https://arxiv.org/html/2404.14219v1

- Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phone – arXiv https://arxiv.org/html/2404.14219v3

- Tiny but mighty: The Phi-3 small language models with big potential – Microsoft News https://news.microsoft.com/source/features/ai/the-phi-3-small-language-models-with-big-potential/

- Phi-3: Microsoft’s Mini Language Model is Capable of Running on Your Phone – Encord https://encord.com/blog/microsoft-phi-3-small-language-model/

- Advantages of Small Language Models Over Large Language Models? | by Eastgate Software | Medium https://medium.com/@eastgate/advantages-of-small-language-models-over-large-language-models-a52deb47d50b

- 小規模言語モデル(SLM)とは?メリット・デメリットや活用分野もご紹介 – SBテクノロジー https://www.softbanktech.co.jp/corp/hr/recruit/articles/139/

- 生成AIに革命を起こす!小規模言語モデルの最新動向 – KOTORA JOURNAL – コトラ https://www.kotora.jp/c/44506/

- SLMとは|デバイスと共に進化するAI | HP Tech&Device TV https://jp.ext.hp.com/techdevice/ai/ai_explained_03/

- Why enterprises are turning to small AI models – CIO Dive https://www.ciodive.com/news/small-language-models-AI-LLMs/740281/

- Small Language Models (SLMs): Efficient, Secure AI for Enterprises | Domo https://www.domo.com/blog/what-are-small-language-models

- The 2025 AI Index Report | Stanford HAI https://hai.stanford.edu/ai-index/2025-ai-index-report

- 15 Best Small Language Models [SLMs] in 2025 | Dextralabs https://dextralabs.com/blog/top-small-language-models/

- The Rise of Small Language Models: Why Bigger Isn’t Always Better | by Anirudh Sekar https://medium.com/@anirudhsekar2008/the-rise-of-small-language-models-why-bigger-isnt-always-better-c3d3302738ff

- SLM(小規模言語モデル)とは何か?活用方法とメリット・デメリット – Feel Flow https://feelflow.co.jp/develop/slm/

- Microsoft’s Phi-3: 3.8 Million Parameters, Rivaling Mixtral 8x7B and GPT-3.5 – Medium https://medium.com/@zergtant/microsofts-phi-3-3-8-b23fb7145933

- Explore AI models: Key differences between small language models and large language models | The Microsoft Cloud Blog https://www.microsoft.com/en-us/microsoft-cloud/blog/2024/11/11/explore-ai-models-key-differences-between-small-language-models-and-large-language-models/

- Why Small Language Models Are the Next Big Thing in Enterprise AI – ITBusinesstoday https://itbusinesstoday.com/tech/ai/why-small-language-models-are-the-next-big-thing-in-enterprise-ai/

- How Small Language Models Deliver Big Business Benefits – Forbes https://www.forbes.com/sites/sap/2025/05/09/how-small-language-models-deliver-big-business-benefits/

- What Are Small Language Models (SLMs)? A Practical Guide – Aisera https://aisera.com/blog/small-language-models/

- 小規模言語モデル(SLM)とは? 活用シーンから導入メリットまで|アイノト – note https://note.com/akik21/n/n3b27c97d8af2

- Trustworthy and Secure AI: How Small Language Models Strengthen Data Security https://www.pscouncil.org/__p/cr/p/Service_Contractor_Magazines/Fall_2024_Service_Contractor_Magazine/Trustworthy_and_Secure_AI__How_Small_Language_Models_Strengthen_Data_Security.aspx

- Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phone https://huggingface.co/papers/2404.14219

- Phi-3 Technical Report, Impressive! : r/singularity – Reddit https://www.reddit.com/r/singularity/comments/1catcdv/phi3_technical_report_impressive/

- Gemma: Open Models Based on Gemini Research and Technology – arXiv https://arxiv.org/html/2403.08295v1

- [2503.19786] Gemma 3 Technical Report – arXiv https://arxiv.org/abs/2503.19786

- google/gemma-7b – Hugging Face https://huggingface.co/google/gemma-7b

- An In-Depth Review of Google Gemma 2 2B – XPNDAI https://www.xpndai.com/an-in-depth-review-of-google-gemma-2-2b

- Gemma 3 Technical Report – arXiv https://arxiv.org/pdf/2503.19786

- 1月 1, 1970にアクセス、 https://arxiv.org/pdf/2403.08295.pdf

- An Empirical Study of LLaMA3 Quantization: From LLMs to MLLMs – arXiv https://arxiv.org/pdf/2404.14047

- Llama 3 vs. Phi: Which LLM is Better? – Sapling https://sapling.ai/llm/llama3-vs-phi

- Introducing Meta Llama 3: The most capable openly available LLM … https://ai.meta.com/blog/meta-llama-3/

- meta-llama/Meta-Llama-3-8B · Hugging Face https://huggingface.co/meta-llama/Meta-Llama-3-8B

- microsoft/Phi-3-mini-128k-instruct · Good model but Bullshit chart and inaccurate numbers https://huggingface.co/microsoft/Phi-3-mini-128k-instruct/discussions/20

- The Big Impact of Small AI: A Guide to Small Language Models – Signity Solutions https://www.signitysolutions.com/blog/guide-to-small-language-models

- SLM と LLM:小規模言語モデルとは – Red Hat https://www.redhat.com/ja/topics/ai/llm-vs-slm

- 製造業におけるAI活用事例12選! 工場の生産性向上などAI導入のメリットを解説 – ニッセイコム https://www.nisseicom.co.jp/growone-production/column/02.html

- 製造業のAI導入・活用事例23選!生産性向上・工場自動化は可能?メリット・失敗事例も解説【2025年最新版】 – AI Market https://ai-market.jp/industry/manufacturing_ai/

- 「品質改善」AI活用 事例7選、製造業・工場のAIカイゼンをご紹介 – MatrixFlow https://www.matrixflow.net/case-study/66

- 現場へのAI適用の鍵となる「エッジAI」 | DATA INSIGHT | NTTデータ https://www.nttdata.com/jp/ja/trends/data-insight/2025/0108/

- AI活用による業務効率化の実例3選 | 注意すべき5つのポイントも詳しく解説! https://www.jdla.org/column/ai-business-efficiency-3-examples/

- 製造業のAI活用事例19選!製品設計や需要予測など大手企業の成果を紹介 – BizRobo! https://rpa-technologies.com/insights/ai_manufacturer/

- 大手日本企業の生成AIの活用事例30選|9つの活用方法も紹介 – AI総研 – メタバース総研 https://metaversesouken.com/ai/generative_ai/japanese-companies/

- AIが予測する組み込みソフトウェア業界 業界|2030年市場規模推移と主要企業ランキング https://service.xenobrain.jp/forecastresults/market-size/embedded-software

- SLM(小規模言語モデル)とは?LLMとの違いや日本語モデルを徹底解説! – AI総合研究所 https://www.ai-souken.com/article/what-is-slm

- 【2025年9月版】日本の製造業が攻略できる3つのフィジカルAI市場と2つの領域 https://blogs.itmedia.co.jp/serial/2025/09/202593ai2.html

- 金融機関における 生成AIの活用とその課題 – 日本銀行 https://www.boj.or.jp/finsys/c_aft/data/aft240521a3.pdf

- 金融特化型LLMの最新事情と活用事例 – KOTORA JOURNAL – コトラ https://www.kotora.jp/c/45515/

- 金融業界を革新する生成AI導入事例:業務効率化と顧客サービス向上 | NOVEL株式会社 https://n-v-l.co/blog/CepsYR_x

- 日本の金融知識を学習した金融特化型PLaMoによる各社専用モデル構築サービスを開始 https://www.preferred.jp/ja/news/pr20250617/

- 医療機関のデジタル担当者必見!SLMで変わる病院業務の未来|Minoru Tanaka – note https://note.com/tanakaminoru_/n/nc5a9f2ff0b11

- SLM(小規模言語モデル)とは?特徴やLLMとの違いを解説 – 発注ナビ https://hnavi.co.jp/knowledge/blog/slm/

- 【2024年版】SLM vs LLM徹底比較!選び方のポイント – ナンバーワンソリューションズ|生成AI https://no1s.biz/blog/6656/

- 【2025年最新】注目の国産AI12選!大手企業からベンチャーまで徹底解説 – 株式会社SHIFT AI https://shift-ai.co.jp/blog/15414/

- NTT’s LLM “tsuzumi” | NTT Technical Review https://ntt-review.jp/archive/ntttechnical.php?contents=ntr202408fa1.html

- NTT’s Large Language Model “tsuzumi”:A High-performance and Low-energy-consumption … – NTT R&D Website https://www.rd.ntt/e/research/JN202406_26659.html

- NEC Upgrades “cotomi” to Advance AI Agent Adoption – ITBusinesstoday https://itbusinesstoday.com/tech/nec-upgrades-cotomi-to-advance-ai-agent-adoption/

- NEC Develops High-speed Generative AI Large Language Models … https://www.nec.com/en/press/202404/global_20240424_01.html

- NEC Unveils High-Performance Generative AI with NEC cotomi Pro and NEC cotomi Light – Elnion https://elnion.com/2024/05/11/nec-unveils-high-performance-generative-ai-with-nec-cotomi-pro-and-nec-cotomi-light/

- Fujitsu Kozuchi : Fujitsu Global https://www.fujitsu.com/global/services/kozuchi/

- Fujitsu and Headwaters trial on-device generative AI solution to streamline JAL cabin crew workflows https://www.fujitsu.com/global/about/resources/news/press-releases/2025/0410-01.html

- Fujitsu Launches AI Platform ‘Fujitsu Kozuchi,’ Streamlining Access to AI and ML Solutions – HPCwire https://www.hpcwire.com/off-the-wire/fujitsu-launches-ai-platform-fujitsu-kozuchi-streamlining-access-to-ai-and-ml-solutions/

- Rakuten AI 2.0 Large Language Model and Small Language Model Optimized for Japanese Now Available | Rakuten Group, Inc. https://global.rakuten.com/corp/news/press/2025/0212_02.html

- Rakuten Releases High-Performance Open Large Language Models Optimized for the Japanese Language https://global.rakuten.com/corp/news/press/2024/0321_01.html

- elyza/ELYZA-japanese-Llama-2-13b · Hugging Face https://huggingface.co/elyza/ELYZA-japanese-Llama-2-13b

- PepperにrinnaのAI会話エンジン新版を採用 | DXを推進するAIポータルメディア「AIsmiley」 https://aismiley.co.jp/ai_news/new-version-of-ai-conversation-engine-adopted-for-pepper/

- りんな (人工知能) – Wikipedia https://ja.wikipedia.org/wiki/%E3%82%8A%E3%82%93%E3%81%AA_(%E4%BA%BA%E5%B7%A5%E7%9F%A5%E8%83%BD)

- rinna/japanese-gpt-neox-3.6b · Hugging Face https://huggingface.co/rinna/japanese-gpt-neox-3.6b

- 【2025年最新】日本の生成AI企業18社!大手からベンチャーまで紹介 – 株式会社SHIFT AI https://shift-ai.co.jp/blog/3069/

- Japan in the game of generative AI. Focus on Japanese. – Space and Lemon Innovations https://spaceandlemon.medium.com/japan-in-the-game-of-generative-ai-focus-on-japanese-6d7b04e5fac7

- Letting nature lead: How Sakana AI is transforming model building – AWS Startups https://aws.amazon.com/startups/learn/letting-nature-lead-how-sakana-ai-is-transforming-model-building

- TAID: A Novel Method for Efficient Knowledge Transfer from Large … https://sakana.ai/taid/

- Reinforcement Learning Teachers of Test Time Scaling – Sakana AI https://sakana.ai/rlt/

- What are small language models? – Salesforce https://www.salesforce.com/blog/small-language-models/

- AIは自動車業界をどう変えている?活用方法・メリット・事例を徹底解説! – AI Market https://ai-market.jp/industry/automotive/

- What Is Microservices Architecture? – Google Cloud https://cloud.google.com/learn/what-is-microservices-architecture

- Microservices Use Cases | Practical Examples and Case Study – ALPACKED https://alpacked.io/blog/microservices-use-cases/

- マイクロサービスとAPIゲートウェイ:重要性と実用例 https://bap-software.net/knowledge/microservices-and-api-gateway/

- API ゲートウェイパターン – AWS 規範ガイダンス https://docs.aws.amazon.com/ja_jp/prescriptive-guidance/latest/modernization-integrating-microservices/api-gateway-pattern.html

- 【ZOZOTOWNマイクロサービス化】API Gatewayを自社開発したノウハウ大公開! – ZOZO TECH BLOG https://techblog.zozo.com/entry/zozotown-api-gateway-intro

- Large Language Model Agent: A Survey on Methodology, Applications and Challenges https://arxiv.org/html/2503.21460v1

- NVIDIA new paper : Small Language Models are the Future of Agentic AI – Reddit https://www.reddit.com/r/LocalLLaMA/comments/1mxrarl/nvidia_new_paper_small_language_models_are_the/

- NVIDIA’s Peter Belcak Distills Why Small Language Models are the Future of Agentic AI https://arize.com/blog/nvidias-small-language-models-are-the-future-of-agentic-ai-paper/

- Small Language Models are the Future of Agentic AI – Research at NVIDIA https://research.nvidia.com/labs/lpr/slm-agents/

- Small Language Models vs Large Language Models: Why Tiny Is the Future of Agentic AI https://vatsalshah.in/blog/small-language-models-future-of-agentic-ai

- How Small Language Models Are Key to Scalable Agentic AI | NVIDIA Technical Blog https://developer.nvidia.com/blog/how-small-language-models-are-key-to-scalable-agentic-ai/

- Small Language Models are the Future of Agentic AI – arXiv https://arxiv.org/pdf/2506.02153

- ALAS: Autonomous Learning Agent for Self-Updating Language Models – arXiv https://arxiv.org/html/2508.15805v1

- Self-Challenging Language Model Agents – arXiv https://arxiv.org/html/2506.01716v1

- サーバやクラウドに接続せず、モバイルデバイス上で直接稼働する「オンデバイスAI」 https://bizdev-career.jp/2024/12/27/on-device-ai/

- サムスンが切り拓くオンデバイス生成AIの転換期 – Samsung Semiconductor https://semiconductor.samsung.com/jp/news-events/tech-blog/samsungs-pivotal-role-in-pioneering-on-device-generative-ai/

- エッジAI・オンデバイスAI・ローカルLLMで加速する生成AIのビジネス活用 | HP Tech&Device TV https://jp.ext.hp.com/techdevice/ai/ai_explained_14/

- 【AI搭載デバイス】スマホ・パソコンの革新機能について徹底解説 – 株式会社Nuco https://nuco.co.jp/blog/article/e8Pe_tfh

- Android で Gemini Nano を使ってみる:オンデバイス AI の新時代 – Zenn https://zenn.dev/sunwood_ai_labs/articles/gemini-nano-android-on-device-ai

- エッジAI開発に強いプロ厳選AI開発会社10社!【2025年最新版】 https://ai-market.jp/services/edgeai_company/

- エッジAI導入によるデジタル変革:市場動向、導入事例、ROI評価 | HP Tech&Device TV https://jp.ext.hp.com/techdevice/ai/ai_explained_08/

- 製造業におけるAIの活用方法とは?メリット・デメリットや導入事例を紹介 https://www.fiweek.jp/hub/ja-jp/blog/article05-ai.html

- 製造業でAIを導入した事例|導入状況やメリット・デメリットを説明 – リコー https://www.ricoh.co.jp/service/digital-manufacturing/media/article/detail31

- SLM(小規模言語モデル)アプリ開発 – 株式会社ヘッドウォータース https://www.headwaters.co.jp/service/generative_ai/slm.html

- AI×IoTの活用事例4選。IoT市場の2023年はどうなる? – 株式会社ヒューマンサイエンス https://www.science.co.jp/annotation_blog/30933/

- 行動計画参加企業のIoT/AI活用ソリューション実装事例 – 電機・電子温暖化対策連絡会 https://www.denki-denshi.jp/contribution_example.php

- AIとIoTの違い・関係性・活用事例を解説|2025年の最新動向も紹介 – Yopaz https://yopaz.jp/tech-blog/AI-and-IoT/

- IoTとAIの活用方法は? | ソニーの開発者ポータル https://developer.sony.com/ja/spresense/ai-column/iot-columns/how-to-utilize-iot-and-ai

- 日本エッジAI市場規模、シェア、トレンド、予測2022年~2032年 https://www.sphericalinsights.com/jp/reports/japan-edge-ai-market

- 2025年注目の組み込みトレンド!AI統合から市場動向まで徹底解説 – Accio https://www.accio.com/business/ja/%E7%B5%84%E3%81%BF%E8%BE%BC%E3%81%BF%E3%83%88%E3%83%AC%E3%83%B3%E3%83%89

- アノテーション料金相場を画像・動画・音声・テキスト別に解説!高くなる要因・費用節減のコツとは? – AI Market https://ai-market.jp/ai_price/annotation-fee/

- アノテーションの厳選外注先8選を徹底比較!データ種類別の費用相場の目安は? https://ai-kenkyujo.com/artificial-intelligence/annotation/gaityu/

- アノテーションサービス比較!利用するメリットとサービスの選び方 | BOXIL Magazine https://boxil.jp/mag/a7536/

- アノテーション代行比較13選。外注相場やタイプ別の選び方は? – BOATER(ボーター) https://boater.jp/article/6652

- アノテーション代行サービス徹底解説|AI開発を加速する効率化の秘訣 – Timers Inc. https://timers-inc.com/blog/annotation_agency

- Small Language Models: A Beginner’s Guide – Ataccama https://www.ataccama.com/blog/small-language-models

- Power of small language models | IBM https://www.ibm.com/think/insights/power-of-small-language-models