エグゼクティブサマリー

大規模言語モデル(LLM)市場の競争は激化の一途をたどっており、その中で「コンテキストウィンドウ」のサイズが勝敗を決する決定的な要因であるという見方が広まっている。本レポートは、この仮説を徹底的に検証し、より長期的かつ戦略的な視点からLLM競争の本質を分析するものである。

分析の結果、コンテキストウィンドウは現在のLLM競争における極めて重要な、そして基盤となる戦場であることは間違いない。その拡大は、これまで不可能だった多くの応用を可能にし、モデルの基本的な対話能力を飛躍的に向上させた。しかし、それは長期的な市場リーダーシップを保証する最終的な決定要因ではない。本レポートが明らかにするのは、持続的な競争優位性は、単なる記憶容量(コンテキストウィンドウ)ではなく、より高度な「推論能力」、卓越した「計算効率」、そして現行モデルの限界を超える「革新的なアーキテクチャ」によって確立されるという事実である。

コンテキストウィンドウの拡大競争は、いわば短距離走である。各社が技術的・経済的限界に突き当たる中で、その差は次第に縮小し、やがてはコモディティ化するだろう。真の競争、すなわちAIの次なる時代を定義する競争は、より複雑で、より効率的に「思考」できるモデルを開発するマラソンなのである。本レポートは、企業導入担当者、投資家、AI戦略家に対し、現在の指標の裏に潜む技術的・経済的力学を解き明かし、次世代のLLM覇権をめぐる真の戦場がどこにあるのかを指し示す。

1. コンテキストウィンドウ:AIにおける新たな戦略的戦場

現在のLLM開発競争において、コンテキストウィンドウは最も目立ち、最もマーケティングしやすい指標として prominence を増している。本セクションでは、この概念を定義し、その重要性が高まった背景を分析することで、コンテキストウィンドウがAI業界における「パワー」の代理指標としてどのように機能しているかを明らかにする。

1.1. デジタルワーキングメモリの定義:トークンからTransformerまで

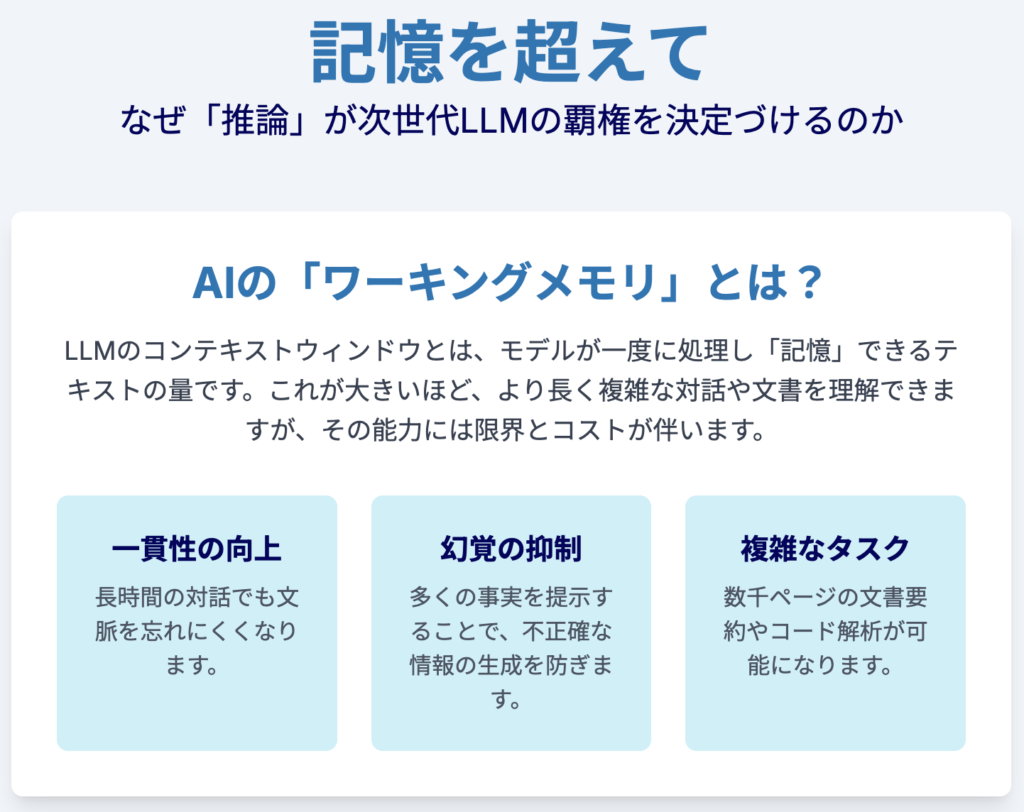

LLMのコンテキストウィンドウ(またはコンテキスト長)とは、モデルが一度に処理し、「記憶」できるテキストの量を指す、AIの短期記憶あるいはワーキングメモリに相当する概念である 1。この能力の根幹には、「トークン」という基本単位と、「自己注意機構」というアーキテクチャ上の革新が存在する。

基本構成要素(トークン)

LLMは人間のように文字単位でテキストを処理するのではなく、「トークン化(tokenization)」と呼ばれるプロセスを通じて、テキストを単語、サブワード(単語の一部)、あるいは文字といった単位に分割する 6。このトークンが、モデルが情報を処理する際の最小単位となる 11。トークン化の仕様はモデルや言語によって異なり、例えば英語では100トークンが約75単語に相当するのに対し、日本語では約100文字に相当するなど、その換算には差異がある 11。この違いは、グローバル企業がAPI利用時のコストやパフォーマンスを算出する上で、無視できない重要な要素となる。入力(プロンプト)、出力(生成されたテキスト)、そしてシステム制御用のトークンすべてが、このコンテキストウィンドウの容量を消費する 10。

アーキテクチャのエンジン(自己注意機構)

現代のLLMのほとんどが採用するTransformerアーキテクチャの核心は、「自己注意機構(self-attention mechanism)」にある 5。この機構は、入力されたシーケンス内のすべてのトークン間の関連性や依存関係を並行して計算する。ある単語が文中の他のどの単語と強く関連しているかを判断することで、文脈を深く理解することが可能になる 13。コンテキストウィンドウのサイズは、この自己注意機構が一度に「注意を払う」ことができるトークンの最大数を直接的に決定する。つまり、ウィンドウが大きければ大きいほど、より広範な文脈を考慮した、首尾一貫した出力を生成できる可能性が高まる 5。しかし、この強力な能力は、後述するように膨大な計算コストという代償を伴う。

1.2. 指数関数的な飛躍:コンテキストウィンドウの爆発的成長の軌跡

LLMの歴史は、コンテキストウィンドウの拡大の歴史でもある。その成長速度は近年、指数関数的に加速しており、AI開発競争の激しさを象徴している。

歴史的変遷

初期のLLM、例えばGPT-2やGPT-3のコンテキストウィンドウは約2,000から4,000トークン程度に過ぎなかった 10。これは数ページ程度のテキストに相当し、長い文書の読解や長時間の対話の維持には大きな制約があった。しかし、技術の進歩に伴い、この上限は劇的に引き上げられてきた 16。

加速する開発競争

データによれば、2023年半ば以降、主要なLLMの最大コンテキストウィンドウは年間約30倍のペースで成長している 15。この驚異的な速度は、コンテキストウィンドウのサイズが主要な競争指標として認識されていることを明確に示している。OpenAI、Google、Anthropicといった主要プレイヤーは、新モデルを発表するたびにウィンドウサイズを更新し、互いに優位性を示そうと競い合っている 11。

100万トークンの壁、そしてその先へ

この競争のマイルストーンとなったのが、100万トークンという大台の突破である。GoogleのGemini 1.5 Proが100万トークン(内部研究では1,000万トークンに到達)を達成し、これに追随する形でAnthropicのClaude Sonnet 4も100万トークン対応を発表、さらにMetaのオープンソースモデルLlama 4 Scoutも1,000万トークンを主張している 13。これは、数千ページに及ぶ文書や数時間の音声データを一度に処理できる能力を意味し、AIの応用範囲を根底から変える可能性を秘めている。この急速な拡大は、「巨大な」コンテキストウィンドウが、近い将来には特別な機能ではなく、標準的な仕様(コモディティ)になることを示唆している。

1.3. なぜ重要なのか:モデルの能力と一貫性への直接的インパクト

コンテキストウィンドウの拡大は、単なる数値上の競争ではない。それはLLMの基本的な能力を直接的に向上させ、ユーザー体験と応用可能性を大きく左右する。

一貫性の向上

コンテキストウィンドウが大きければ大きいほど、モデルは対話の初期段階で与えられた指示や過去のやり取りを「忘れにくく」なる 9。これにより、長時間の対話でも文脈が維持され、首尾一貫した応答が可能になる。これは、カスタマーサポート用のチャットボットや、複雑なタスクを段階的に実行するAIアシスタントなど、継続的な対話が求められるアプリケーションにおいて極めて重要である 23。

ハルシネーション(幻覚)の抑制

ハルシネーション、すなわちモデルが事実に基づかない情報を生成する現象は、特に企業利用における大きな課題である。コンテキストウィンドウが大きいと、より多くの正確な情報や参照データをプロンプト内に直接提供できる。この「グラウンディング(grounding)」によって、モデルが不確かな内部知識に頼る必要性が減り、事実に基づいた信頼性の高い応答を生成する可能性が高まる 5。

複雑なタスクの実現

最も重要なのは、コンテキストウィンドウの拡大が、これまで技術的に不可能だった、あるいは非常に困難だったタスクを可能にすることである 11。例えば、数千ページに及ぶ法律文書や財務報告書全体の要約、数万行にわたる大規模なコードベースの解析、複数の情報源を統合した上での高度な質疑応答などが、単一のプロンプトで実行可能になる 6。これは、セクション3で詳述するように、多くの産業に変革をもたらすポテンシャルを秘めている。

コンテキストウィンドウのサイズは、技術者でない意思決定者にとって最も理解しやすく、比較しやすい数値である。デジタルカメラの「メガピクセル数」や自動車の「馬力」のように、それはモデルの総合的な性能を完全に表すものではないにもかかわらず、優位性を示すための強力なマーケティングツールとして機能している 11。このため、各社は実用性やコスト効率以上に、競合他社を上回る数値を発表することに戦略的価値を見出している。この現象は、コンテキストウィンドウが単なる技術仕様ではなく、市場における認識を形成するための「見栄えの指標(vanity metric)」としての側面を持つことを示唆している。

さらに、このコンテキストウィンドウをめぐる開発競争は、現在の主流であるTransformerアーキテクチャが持つ根源的な制約から生まれた必然的な帰結でもある。自己注意機構は文脈理解に革命をもたらしたが、その計算コストがシーケンス長の二乗に比例して増大する(O(n2))という深刻な弱点を抱えている 2。したがって、コンテキストウィンドウ拡大に向けた現在の膨大な研究開発努力は、スパースアテンションやハードウェア最適化といった技術を駆使して、このアーキテクチャ上のボトルネックを克服しようとする試みに他ならない 26。これは、コンテキストウィンドウへの注力が単なる戦略的選択ではなく、現行アーキテクチャの支配下における技術的な必然であることを意味する。将来、Transformerに代わる新たなアーキテクチャが登場すれば、現在我々が知るコンテキストウィンドウという指標そのものが時代遅れになる可能性すらある。

2. フロンティアモデル:コンテキスト長をめぐる競争分析

LLM市場の覇権争いは、各社が投入するフロンティアモデルの性能によって左右される。本セクションでは、主要プレイヤーのモデルを、公称のコンテキストウィンドウサイズだけでなく、価格、性能、そしてその背景にある戦略的意図という多角的な視点から徹底的に比較分析する。

2.1. テクノロジーの巨人たち:Google、OpenAI、Anthropicの三つ巴

クローズドソースモデル市場は、3つの主要プレイヤーによって形成されており、それぞれがコンテキストウィンドウに対して異なる戦略的アプローチをとっている。

Google(Geminiシリーズ)

Googleは、コンテキストウィンドウの絶対的なサイズで市場をリードする戦略をとっている。Gemini 1.5 Proは標準で100万トークン、プレビュー版では200万トークンという業界最大級のコンテキストウィンドウを提供する 13。この圧倒的な「力押し」のアプローチは、開発者が複雑なRAG(Retrieval-Augmented Generation)システムを構築せずとも、大量の情報を直接プロンプトに投入するだけで高度なタスクを実行できる未来を描いている 31。よりコスト効率の高いGemini 1.5 Flashも100万トークンを提供しており 29、Googleがコンテキスト容量を中核的な競争優位性と位置づけていることは明らかである。

OpenAI(GPTシリーズ)

一方、OpenAIはよりバランスの取れたアプローチを採用している。主力モデルであるGPT-4 TurboおよびGPT-4oは128,000トークンのコンテキストウィンドウを提供し、最新のGPT-4.1では100万トークンへと拡張している 34。これは、単に最大のウィンドウを追求するのではなく、推論の質、応答速度(レイテンシ)、そしてコストの間の最適なバランスを見出すことに重点を置いた戦略を示唆している。OpenAIは、コンテキストサイズを重要な要素としながらも、それが唯一の決定要因ではないという立場をとっているように見える。

Anthropic(Claudeシリーズ)

Anthropicは、特にエンタープライズ市場を強く意識した戦略を展開している。Claude 3ファミリー(Opus, Sonnet, Haiku)は200,000トークン、最新のClaude Sonnet 4は100万トークンのコンテキストウィンドウを提供する 20。同社の強みは、長いコンテキスト全体にわたる高い信頼性と一貫した性能、そして安全性にある。これは、金融や法務など、大量の文書を正確に分析する必要がある、ミスの許されないビジネスユースケースに強く訴求するポジショニングである 40。

2.2. オープンソースの攻勢:MetaのLlamaとその他の挑戦者

クローズドソースモデルが市場を牽引する一方で、オープンソースコミュニティもコンテキストウィンドウの拡大において急速に進化しており、市場の力学を大きく変えつつある。

Meta(Llamaシリーズ)

Metaは、オープンソースLLMの分野で長コンテキスト化を積極的に推進している。Llama 3.1は128,000トークン、研究向けのLlama 4 Scoutは1,000万トークンという巨大なコンテキストウィンドウを主張している 13。これにより、これまで高価なプロプライエタリAPIに依存せざるを得なかった長コンテキストアプリケーションの開発が、より多くの企業や研究者にとって可能になる。この「民主化」は、イノベーションを加速させると同時に、プロプライエタリモデルの優位性に挑戦する強力な動きである 6。

その他の注目モデル

Meta以外にも、AlibabaのQwenやDeepSeekなど、多くのオープンソースモデルがコンテキスト長の限界を押し広げている 38。これらのモデルは、しばしば最新の効率化技術を積極的に採用し、限られた計算資源でも高性能な長コンテキスト処理を実現しようと試みている。

2.3. スペックシートを超えて:多角的性能分析

モデルの真の価値は、コンテキストウィンドウのサイズだけでは測れない。コスト、速度、そして総合的な推論能力を組み合わせた評価が不可欠である。

価格と経済性

長コンテキストはプレミアムな機能であり、その利用には相応のコストがかかる。APIプロバイダーは通常、入力と出力のトークン数に基づいて課金するため、コンテキストが長くなるほどコストは増大する 12。例えば、Gemini 1.5 Flashはプロンプトが128,000トークンを超えるかどうかで料金が変動する 33。また、GPT-4oはClaude 3.5 SonnetやGemini 1.5 Proよりも高価であると報告されている 46。このコスト要因は、後述するRAGが依然として重要な選択肢であり続ける最大の理由の一つである。

レイテンシと速度

長いコンテキストを処理することは、本質的に応答時間を増加させる 2。最初のトークンが出力されるまでの時間(Time to First Token, TTFT)は長くなり、秒間に出力されるトークン数(Tokens per Second, TPS)は減少する。リーダーボードのデータを見ると、速度に最適化されたモデル(例:Llama 4 Scout, GPT-4o mini)は、比較的小さなコンテキストウィンドウを持つ傾向がある 48。特に長いプロンプトにおいては、GPT-4oがClaude 3.5 SonnetやGemini 1.5 Proよりも低いレイテンシを示すというデータもある 46。

総合性能ベンチマーク

コンテキストサイズは一つの指標に過ぎず、モデルの「知能」を測るには、MMLU(一般知識)、GPQA(専門家レベルの推論)、HumanEval(コーディング能力)といった総合的なベンチマークが用いられる 49。これらのベンチマークでは、しばしばGPT-4oがより大きなコンテキストウィンドウを持つモデルを上回るスコアを記録しており、本レポートの中心的な主張、すなわち「記憶容量」と「推論能力」は必ずしも一致しないという事実を裏付けている 29。

| モデル | 開発元 | 最大コンテキスト長(公称) | 標準コンテキスト長 | 入力コスト($/1Mトークン) | 出力コスト($/1Mトークン) | 主要なアーキテクチャ特徴 |

| Gemini 1.5 Pro | 2,000,000 | 1,000,000 | $3.50 | $10.50 | Mixture-of-Experts (MoE), ネイティブマルチモーダル | |

| GPT-4o | OpenAI | 128,000 | 128,000 | $5.00 | $15.00 | Transformer, エンドツーエンドのマルチモーダル |

| Claude 3.5 Sonnet | Anthropic | 200,000 | 200,000 | $3.00 | $15.00 | Transformer, 安全性重視の設計 |

| Claude Sonnet 4 | Anthropic | 1,000,000 | 1,000,000 | (Tier 4以上限定) | (Tier 4以上限定) | Transformer, 長文脈での一貫性 |

| Llama 3.1 405B | Meta | 128,000 | 128,000 | オープンソース | オープンソース | Transformer, オープンソース |

| Llama 4 Scout | Meta | 10,000,000 | 10,000,000 | オープンソース | オープンソース | Transformer, 効率化されたアテンション |

注:コストは2024年後半の標準的なAPI価格に基づき、変更される可能性がある。Llamaはホスティング費用が別途発生する。

各社のコンテキストウィンドウ戦略を深く分析すると、単なる技術選択ではなく、AIアプリケーションの未来のアーキテクチャに関する競合する思想が見えてくる。Googleの100万〜200万トークンという巨大なウィンドウ 19 は、開発者がすべてのデータをコンテキストに「詰め込む」ことで、複雑性をモデルプロバイダー側にオフロードするという未来への賭けである。これは「力押し」あるいは「オールインワン」思想と言える。対照的に、OpenAIやAnthropicのより穏健な(それでも巨大な)128,000〜100万トークンというウィンドウ 20 は、モデルのコンテキストを強力だが有限なリソースと捉え、RAGや関数呼び出しといった他のツールと組み合わせて使うハイブリッドなアーキテクチャを想定している。これは「管理されたリソース」思想である。そして、Metaのオープンソース戦略 13 は、これらの強力なツールをエコシステム全体の基盤レイヤーにすることで、イノベーションを民主化しようとする「民主化」思想を体現している。

この文脈で、Metaによるオープンソースの長コンテキストモデルのリリースは、プロプライエタリリーダーによるプラットフォームロックインを防ぐための戦略的な対抗策と解釈できる。もしGoogle、OpenAI、Anthropicだけが巨大なコンテキストウィンドウを提供できれば、彼らは強力な参入障壁を築くことができる。これらの独自の能力に依存するアプリケーションを構築した企業は、彼らのエコシステムと価格体系に縛られることになるからだ。Llama 4のような1,000万トークンウィンドウを持つモデルをリリースする 13 ことで、Metaは単に技術を共有しているだけでなく、この潜在的な参入障壁を戦略的に侵食している。これにより、長コンテキスト能力は単一ベンダーの独占的な高収益製品ではなく、インフラ層のコモディティ化された機能となり、エコシステムのオープン性を保ち、権力の集中を防ぐのである。

3. 長コンテキストのバリューチェーン:変革的なエンタープライズアプリケーションの解放

本セクションでは、抽象的な議論から実践的な応用へと焦点を移し、巨大なコンテキストウィンドウによって新たに可能になった、あるいは大幅に強化された具体的な高価値ユースケースを詳述する。これらのアプリケーションを分類することで、最も大きなビジネスインパクトがどこに存在するのかを明らかにする。

3.1. ページからライブラリへ:文書分析の革命

コンテキストウィンドウの拡大が最も直接的な影響を及ぼす分野の一つが、大量のテキストデータを扱う文書分析である。

包括的な要約

従来、長い文書を要約する際には、テキストを小さな「チャンク」に分割し、それぞれを要約してから統合する必要があった。このプロセスは、文脈の損失や重要なニュアンスの見落としといった問題を生じやすかった 13。しかし、数百万トークンを扱えるモデルは、書籍一冊、長大な研究論文、財務報告書、あるいは法律契約書全体を一度に読み込み、全体的な文脈を理解した上で高品質な要約を生成できる 14。これは、法務、金融、学術研究といった分野において、情報処理の効率と質を根本から変えるゲームチェンジャーである。

複数文書にまたがる質疑応答(QA)と推論

単一の文書から情報を探し出すだけでなく、複数の文書を同時にコンテキストウィンドウに入力することで、より高度な分析が可能になる。例えば、複数の年度の財務報告書を比較して傾向を分析したり、関連する複数の判例を読み込ませて法的な論点を整理したり、競合他社の製品マニュアルを比較して自社の強みを洗い出したりといったタスクが実現できる 14。これにより、これまで専門家が多大な時間を費やしていた複雑なリサーチやデューデリジェンス業務の自動化が可能になる。

ナレッジマネジメント

企業は、社内の全マニュアル、過去の議事録、技術ドキュメントといったナレッジベース全体をコンテキストとしてモデルに提供できる 8。これにより、従来の複雑なRAGパイプラインを構築することなく、極めて精度の高い社内向けヘルプデスクや専門家システムを迅速に構築することが可能になる 14。従業員は、自然言語で質問するだけで、膨大な社内文書の中から必要な情報を文脈に沿った形で得ることができる。

3.2. コードベース全体を俯瞰:ソフトウェア開発のパラダイムシフト

ソフトウェア開発の分野においても、長コンテキストは生産性を飛躍的に向上させる可能性を秘めている。

リポジトリレベルでのコード理解

数万行、あるいは数百万行のコードを一度に処理できる能力は、LLMがソフトウェアリポジトリ全体の構造、依存関係、そしてロジックを把握することを可能にする 6。これは、個別のファイルを見るだけでは得られない、システム全体としての鳥瞰的な理解である。

高度なコード生成とリファクタリング

この全体的な文脈理解に基づき、モデルはより高度な開発タスクを実行できる。例えば、プロジェクト全体にわたる大規模なコードのリファクタリング、既存のコーディング規約や設計思想に準拠した新機能の追加、あるいは複数のファイルにまたがるモジュール全体のドキュメンテーション生成などが可能になる 47。

バグ検出とセキュリティ監査

個別のファイル単位では見過ごされがちなバグやセキュリティ脆弱性も、コードベース全体を分析することで発見しやすくなる。あるファイルでの変更が、依存関係にある別のファイルに予期せぬ影響を与えていないか、あるいはプロジェクト全体で一貫性のないロジックが使用されていないかといった、システムレベルでの問題点を特定できる 13。

3.3. エージェント型AIの実現:複雑なワークフローを維持する文脈の役割

自律的にタスクを遂行するエージェント型AIの実現には、長期間にわたって状態を維持する能力が不可欠であり、その基盤となるのが長コンテキストである。

エージェントの長期記憶

エージェント型ワークフローは、複数のステップ、外部ツールの使用、APIとの連携など、複雑なプロセスを伴う。巨大なコンテキストウィンドウは、エージェントの「ワーキングメモリ」として機能し、自身の目標、過去の行動、そして外部から得た情報を数百、数千ステップにわたって保持し続けることを可能にする 31。これにより、エージェントは途中で文脈を見失うことなく、首尾一貫したタスク遂行が可能になる。

メニーショット・インコンテキスト学習

従来、モデルに新しいタスクを教えるには、大量のデータセットを用いた高コストなファインチューニングが必要だった。しかし、長コンテキストウィンドウの登場により、「メニーショット・インコンテキスト学習」という新たなパラダイムが生まれた。これは、数百、数千もの例題(ショット)を単一のプロンプト内に含めることで、ファインチューニングなしでモデルにその場で新しい複雑なタスクを学習させる手法である 13。

3.4. マルチモーダル・フロンティア:動画、音声、画像を大規模に処理

最新のフロンティアモデルは、テキストだけでなく、画像、音声、動画といった多様なモダリティをネイティブに扱う能力を持つ。長コンテキストは、このマルチモーダル能力を飛躍的に拡張する。

ネイティブ・マルチモーダルモデル

Gemini 1.5やGPT-4oのようなモデルは、100万トークンのコンテキストウィンドウを活用して、1時間の動画、11時間の音声、あるいは30,000行以上のコードを一度に処理できる 6。

新たなユースケース

これにより、全く新しいアプリケーションが生まれる。例えば、数時間にわたる講義動画全体を要約したり、長時間のポッドキャストの内容について質疑応答したり、防犯カメラの映像から特定のイベントを検索したりすることが可能になる 32。医療分野では、患者の全医療記録(テキスト)と医用画像(画像)を同時に分析し、より精度の高い診断支援を行うといった応用が期待される。

これらのユースケースに共通するのは、単に大量のデータを処理するだけでなく、データ間の相互接続性を理解し、「全体論的な推論」を行う点にある。複数文書QA 58、リポジトリレベルのコード分析 63、エージェント型ワークフロー 31 など、その価値は広大な情報の中から単一の事実を見つけ出すことではない。むしろ、その情報全体に散らばる複数の情報片間の複雑でしばしば微妙な関係性を理解することにある。法律契約の意味は条項間の相互作用に依存し、あるファイルのバグは別のファイルの依存関係によって引き起こされるかもしれない。長コンテキストは、LLMがシステム全体を一度に見ることを可能にすることで、単純な情報検索機から強力な統合・分析エンジンへと変貌させる。

この能力の進化は、AIアプリケーション市場を「単純な検索」と「複雑な統合」という二つのカテゴリに二分させるだろう。静的な単一マニュアルから質問に答えるチャットボットのような単純なアプリケーションは、依然としてRAGで補強された、より安価で高速な小規模コンテキストモデルで十分かもしれない。しかし、法務調査、科学研究、複雑なソフトウェア工学といった高価値で変革的なアプリケーション 13 は、「複雑な統合」カテゴリに属する。これらのアプリケーションが機能するためには、高価で最先端の長コンテキストモデルが不可欠となる。これは、企業が単一のLLMを選択するのではなく、解決すべき問題の価値に応じて、長コンテキストモデルの高いコストとレイテンシを許容するポートフォリオ戦略をとる必要があることを示唆している。200万トークンウィンドウを使用するためのROI計算は、重要な戦略的決定となるだろう。

4. パフォーマンスのパラドックス:「中だるみ」問題と長コンテキストの限界

マーケティング上の喧伝とは裏腹に、コンテキストウィンドウの拡大は必ずしも性能向上を意味しない。本セクションでは、コンテキストウィンドウが長くなるにつれて顕在化する精度、コスト、レイテンシに関する深刻な課題、すなわち「パフォーマンスのパラドックス」を掘り下げる。

4.1. 公称値と実効値のギャップ

LLMのコンテキストウィンドウには、カタログスペックとしての「公称コンテキスト長」と、実際に信頼性の高い性能を発揮できる「実効コンテキスト長」の間に大きな乖離が存在する。

「Lost in the Middle(中だるみ)」問題の紹介

複数の研究によって、LLMの性能がU字型の曲線を描くことが示されている 5。つまり、モデルは長いコンテキストの最初と最後にある情報を参照するのは得意だが、その中間に埋もれた情報にアクセスする能力は著しく低下する。この現象は「Lost in the Middle」として知られ、長コンテキストモデルの信頼性を揺るがす根本的な課題となっている。

ベンチマークによる証拠(Needle-in-a-Haystack & RULER)

この性能低下は、長コンテキスト専用のベンチマークによって定量的に示されている。「Needle-in-a-Haystack(干し草の中の針)」(NIAH)テストは、長い無関係なテキスト(干し草)の様々な深さに特定の情報(針)を配置し、モデルがそれを正確に取得できるかを測定する 5。より高度なベンチマークであるRULERやNoLiMaは、さらに複雑な長文脈上の推論を評価し、ほぼ全てのモデルが公称値よりはるかに短い32,000〜64,000トークンといった閾値を超えると、性能が急激に低下することを示している 45。

実効コンテキスト長

この結果、モデルが実際に信頼して利用できるウィンドウの範囲、すなわち「実効コンテキスト長」という概念が重要になる 43。例えば、128,000トークンのコンテキストウィンドウを謳うモデルでも、実効長は32,000トークン程度で、それを超えると性能が急落する可能性がある 43。これは、ユーザーや開発者がスペックシートの数値を鵜呑みにすることの危険性を示している。

4.2. U字型曲線の可視化:なぜモデルは「忘れる」のか

この性能低下の背景には、現在のLLMアーキテクチャに内在する技術的な要因がある。

注意機構のバイアス

性能低下は、Transformerの自己注意機構と位置エンコーディングの性質に関連していると考えられている。これらの仕組みは、長いシーケンスのすべての部分に均等に重み付けを行うように設計されていない可能性がある 25。また、モデルの事前学習データには、数百万トークンにわたるような超長距離の依存関係を持つテキストがほとんど含まれていないため、モデルはそのようなタスクに最適化されていない 75。

ノイズと注意散漫

コンテキストが長くなるにつれて、タスクに無関係な情報、すなわち「ノイズ」の量も増大する。これにより、モデルが重要な情報に集中することが困難になり、「文脈的注意散漫(contextual distraction)」や、古い情報や誤った情報に引きずられる「文脈的ドリフト(contextual drift)」といった現象が発生しやすくなる 7。

4.3. 隠れた税金:二次関数的に増大するコスト、レイテンシ、計算需要

長コンテキストの利用には、性能低下だけでなく、深刻な経済的・技術的コストが伴う。これは「隠れた税金」とも言うべき負担である。

$O(n^2)$問題

標準的な自己注意機構の計算コストとメモリ使用量は、入力シーケンス長(n)の二乗に比例して増大する 2。これは、コンテキスト長を2倍にすると、必要な計算リソースが4倍になることを意味する。この二次関数的なスケーリングは、長コンテキスト化における最大の技術的障壁である。

経済的インパクト

この$O(n^2)$問題は、アプリケーションの経済性に直接的な影響を及ぼす。

- 高コスト: APIプロバイダーはトークン単位で課金するため、数百万トークンをプロンプトとして入力するコストは非常に高額になる 6。

- 高レイテンシ: 処理するトークン数が増えれば、応答にかかる時間も長くなる。これは、リアルタイム性が求められるアプリケーションでは致命的な欠点となる 6。

- ハードウェア要求: 特に推論時に状態を保持するKVキャッシュのメモリ要求量が著しく増加するため、より高性能で高価なハードウェア(GPU)が必要となる 7。

| モデル | 公称コンテキスト長 | ベンチマーク | 精度(針が冒頭) | 精度(針が中間) | 精度(針が末尾) | 推定実効コンテキスト長 |

| GPT-4-Turbo (128K) | 128,000 | NIAH / RULER | 高 | 低下 | 高 | 64,000 |

| Claude 3 Sonnet (200K) | 200,000 | RULER | 比較的高 | 大幅に低下 | 比較的高 | 32,000-64,000 |

| Gemini 1.5 Pro (1M) | 1,000,000 | NIAH | ほぼ100% | ほぼ100% | ほぼ100% | > 512,000 |

| Llama-3.1-405B (128K) | 128,000 | RULER | 高 | 32K以降で低下 | 高 | 32,000 |

注:数値は公開されているベンチマーク結果 43 に基づく概算であり、タスクの複雑さによって変動する。Gemini 1.5 Proは「Lost in the Middle」問題に対して高い耐性を示しているが、これは例外的なケースである。

「Lost in the Middle」問題は、単なるバグや最適化不足ではなく、現在のTransformerアーキテクチャの根本的な特性である可能性が高い。この問題は、長コンテキスト処理専用に設計されたモデル(例:GPT-4 32K, Claude 100K)でも持続して観測される 69。研究では、位置エンコーディングの限界 71 や注意機構そのものの性質 73 が原因として指摘されている。これは、現行のアーキテクチャには性能上の上限が存在することを示唆しており、業界がState Space Modelやリカレントモデルといった全く新しい設計へと向かう動機となっている 27。

この状況は、コンテキストウィンドウをめぐる開発競争が一種の「性能的負債」を生み出していることを意味する。データが示すように、コンテキスト長が増加するにつれて性能は飽和、あるいは低下する 27 一方で、コストは二次関数的に増大する 13。つまり、開発者は信頼性の低い能力のために指数関数的に多くの費用を支払っていることになる。この持続不可能な力学は、「すべてをプロンプトに詰め込む」アプローチからの戦略的撤退を促し、必要な文脈だけを選択的に提供することで同等以上の性能をわずかなコストで実現できるRAGのような、より効率的なソリューションに対する強力で永続的な経済的インセンティブを生み出している。

5. 戦略的アーキテクチャ:Retrieval-Augmented Generation (RAG) の永続的な妥当性

LLMアプリケーションを設計する上で、モデル固有の長コンテキスト能力に依存するのか、あるいはRAG(Retrieval-Augmented Generation)を用いるのかは、重要な戦略的選択である。本セクションでは、この二つのアプローチを比較し、未来のアーキテクチャが二者択一ではなく、両者を統合したハイブリッドな形になることを論じる。

5.1. 精密性と力任せ:比較分析

長コンテキスト(LC)アプローチ

これは、関連する可能性のあるすべての情報を直接モデルのプロンプトに入力する手法である。「プロンプトスタッフィング」とも呼ばれ、実装は比較的単純である 15。このアプローチの最大の利点は、モデルがすべてのデータを全体として俯瞰できるため、文書間にまたがる微妙な関係性を捉える可能性があることだ 82。

Retrieval-Augmented Generation (RAG) アプローチ

RAGは多段階のプロセスである。まず、ベクトル検索などの検索システムが、外部の巨大なナレッジベースからクエリに最も関連性の高い情報の「チャンク」を見つけ出す。次に、その厳選されたチャンクのみをLLMにコンテキストとして与え、回答を生成させる 12。

主要なトレードオフ

- 性能: 必要な情報がすべてコンテキストウィンドウに収まり、かつモデルがそれを効果的に利用できる場合、LCはRAGを上回る性能を発揮することがある。これは、RAGにおける不完全な検索ステップによる情報損失を回避できるためである 83。しかし、コンテキストが非常に大きい、あるいはノイズが多い場合、RAGはモデルの注意を最も重要な事実に集中させるため、より正確な結果をもたらすことがある 23。

- コストとレイテンシ: 最終的な生成ステップで処理するトークン数がはるかに少ないため、RAGはほぼ常にLCよりも高速かつ低コストである 23。

- データの鮮度: RAGシステムはリアルタイムのデータベースに接続できるため、常に最新の情報に基づいた回答を生成できる。これは、プロンプトに入力された情報しか知らないLCモデルには不可能な芸当である 15。

- スケーラビリティとデバッグ容易性: RAGは事実上無制限のナレッジベースにスケールでき、コンテキストウィンドウのサイズをはるかに超える。また、どの文書が検索されたかを特定できるため、デバッグも容易である 17。

5.2. 進化する議論:長コンテキストはRAGを時代遅れにするか?

LC優位論

一部の研究者は、コンテキストウィンドウがほぼ無限になり、コストが劇的に低下すれば、RAGのような独立した検索ステップは不要になると予測している。「ライブラリ全体をコンテキストに入れられるなら、なぜわざわざ検索する必要があるのか?」という考え方である 15。

RAG永続論

しかし、大方の見方は、RAGが今後も重要な役割を果たし続けるというものである。すべてのクエリに対して巨大なコンテキストを処理することの経済的な持続不可能性、リアルタイムデータへの要求、そして前述の「Lost in the Middle」問題といった課題を考慮すると、力任せのアプローチよりも、インテリジェントで選択的な検索の方が効率的であり、多くの場合、信頼性も高い 15。

5.3. 未来はハイブリッド:RAGと長コンテキストモデルの統合

新たなベストプラクティスとして浮上しているのは、両者の長所を組み合わせたハイブリッドアプローチである。まず、高度なRAGシステムを用いて、大規模な知識源から関連性の高い文書群を(小さなコンテキストウィンドウには収まらない量)取得する。そして、それらの文書を一つずつ処理するのではなく、すべてを巨大なコンテキストウィンドウに投入する。これにより、モデルは事前にフィルタリングされた、信号対雑音比の高いデータセットに対して、全体論的な推論を行うことができる 43。

ワークフロー例

法的な質問に対して、RAGシステムが数千件の判例データベースから最も関連性の高い10件の判例ファイルを検索する。次に、長コンテキストLLMがその10件のファイルすべてを同時に分析し、それらの情報を統合して包括的な回答を生成する。

| 要素 | RAGアプローチ | 長コンテキスト(LC)アプローチ | 最適なユースケース |

| 性能品質 | 検索の質に依存。ノイズに強く、焦点が明確。 | 全体的な文脈理解に優れるが、「中だるみ」のリスクあり。 | RAG: 巨大な文書群からの事実検索。 LC: 複数の文書間の複雑な関係性の分析。 |

| コスト | 低い(処理トークンが少ない)。 | 非常に高い(全トークンを処理)。 | RAG: コスト効率が最優先されるアプリケーション。 |

| レイテンシ | 低い(検索+生成)。 | 高い(大規模なプロンプト処理)。 | RAG: リアルタイム応答が求められる対話システム。 |

| データ鮮度 | 高い(リアルタイムDBに接続可能)。 | 低い(プロンプト時点の情報に限定)。 | RAG: 最新情報(ニュース、株価など)を扱うタスク。 |

| スケーラビリティ | 非常に高い(知識源のサイズに制限なし)。 | 限定的(コンテキストウィンドウのサイズが上限)。 | RAG: 企業全体のナレッジベースなど、超大規模なデータソース。 |

| 開発複雑性 | 高い(検索システムの構築・維持が必要)。 | 低い(プロンプトにデータを投入するだけ)。 | LC: 迅速なプロトタイピングや単純なタスク。 |

| デバッグ容易性 | 高い(検索結果を検証可能)。 | 低い(モデルの内部プロセスがブラックボックス)。 | RAG: 高い信頼性と説明責任が求められる分野(金融、医療)。 |

RAGとLCをめぐる議論は、AIにおけるより大きなアーキテクチャ上の対立、すなわち知能を「モデル内部」(コンテキスト経由)に埋め込むべきか、それとも「外部」(ツールやパイプライン経由)で編成すべきか、という問題の代理戦争である。RAGが依然として重要であり続けているという事実 83 は、業界が後者のアプローチ、つまりLLMをより大きなシステム内の強力な推論コンポーネントとして位置づけ、外部システムが適切な情報を見つけて供給する方が、ほとんどの現実世界の問題に対してより堅牢で、スケーラブルで、経済的に実行可能であると結論づけつつあることを示唆している。

このハイブリッドな未来像は、AIインフラにおける次のイノベーションの波を牽引するだろう。その焦点は、検索と生成のシームレスな統合にある。もし未来がハイブリッドであるならば 43、最も価値のあるツールやプラットフォームは、データソースと長コンテキストモデルとの間のギャップを埋めるものになる。これは、ベクトルデータベース、検索アルゴリズム、LLM APIがもはや別々のコンポーネントではなく、深く統合される未来を指し示す。検索ステップを自動的に処理する「RAGネイティブ」なLLM APIや、長コンテキストへの投入に最適化されたデータフォーマットを提供するベクトルデータベースの登場が期待される。価値は個々のコンポーネントから、RAG+LCワークフローを効率的に管理する統合プラットフォームへと移行するだろう。

6. 究極の差別化要因:なぜ「推論能力」が生の記憶容量を凌駕するのか

本セクションでは、本レポートの中心的なテーゼを提示する。すなわち、コンテキストは必要不可欠な基盤であるが、LLM市場における真の、そして持続可能な競争優位性は、優れた推論能力からもたらされるという主張である。

6.1. パイオニアたちの洞察:現行パラダイムへの批判

AI分野の第一人者たちは、現在のLLM開発の方向性、特に記憶容量の増強だけに焦点を当てるアプローチに警鐘を鳴らしている。

ヤン・ルカン氏の議論

MetaのチーフAIサイエンティストであるヤン・ルカン氏は、単に次のトークンを予測する自己回帰型LLMは根本的に限定されており、真の推論や計画能力を獲得することはできないと主張している。彼は、世界のモデルを構築できる全く新しいアーキテクチャを提唱しており、現在の延長線上では人間レベルのAIには到達できないと示唆している 92。彼の見解は、コンテキストウィンドウを大きくするだけでは、中核的なアーキテクチャの欠陥は解決されないことを意味する。

ジェフリー・ヒントン氏の視点

「AIのゴッドファーザー」の一人であるジェフリー・ヒントン氏は、LLMが我々の想像以上に人間の脳に似た創発的な特性を持つ可能性を指摘している 96。しかし同時に、彼はその限界と実存的リスクについても警告している。適切なグラウンディングなしには真偽を区別できず、また人間の意図と乖離した目標を発達させる可能性がある 98。これは、堅牢な推論能力とアライメントを伴わない巨大な記憶(コンテキスト)がいかに危険であるかを浮き彫りにしている。

6.2. 評価のシフト:検索から推論へ

LLMの能力を測る基準そのものが、単純な知識の記憶から、複雑な問題解決能力へと移行している。

単純なベンチマークの飽和

MMLUのような知識の想起や、NIAHのような単純な情報検索を測定する初期のベンチマークは、トップモデルがほぼ満点を取るようになり、「飽和」しつつある 45。これにより、最先端モデル間の真の能力差を測る指標としての有効性が低下している。

複雑な推論ベンチマークの台頭

評価の最前線は、多段階の推論、計画、そして問題解決能力を試す、より挑戦的なベンチマークへと移行している。

- GPQA(大学院レベルのQ&A): 科学分野における専門家レベルの推論能力をテストする 48。

- SWE-Bench(ソフトウェア工学): 現実世界のGitHub上の問題を解決するモデルのエージェント的なコーディング能力を測定する 48。

- 競技レベルの問題: プログラミングや数学のオリンピック(AIMEなど)で出題されるような、未知のデータに対する独創的な問題解決能力をテストする 102。

これらの新しいベンチマークは、モデルが単に情報を「覚えている」のではなく、それを活用して未知の問題を「考え、解決できる」かを問う。近年の研究では、LLMの性能はコンテキスト長よりも推論の複雑性が増すにつれて急激に低下することが示されており、現在のボトルネックが記憶容量ではなく推論能力にあることを明確に示している 106。

6.3. 次のトークン予測を超えて:より深い認知を求めるアーキテクチャの探求

業界は、単純なパターンマッチングを超えた、より高度な認知能力を実現するためのアーキテクチャを模索している。

思考の連鎖(Chain-of-Thought)とその先

Chain-of-Thought(CoT)プロンプティングのような技術は、モデルに「ステップ・バイ・ステップで考えさせる」ことで推論能力が向上することを示した。重要なのは、提供される情報だけでなく、推論の連鎖の長さや構造自体が性能に影響を与えるという点である 107。

専門家の混合(Mixture of Experts, MoE)

GeminiのMoEアーキテクチャは、特定のタスクに対してモデル内の関連する「専門家」部分のみを活性化させることで、より効率的な計算を実現する一歩である 34。

「無限」コンテキストへの挑戦

一見すると本レポートのテーゼと矛盾するように見える「無限」コンテキストウィンドウの研究(Infini-attention, InfiniPot, InfiniteICLなど)は、単なる記憶容量の追求ではない。それは、線形アテンションや圧縮メモリといった、より効率的な新しい注意機構を開発する試みであり、これらは二次関数スケーリング則の制約を受けにくい、将来のより強力なアーキテクチャの基盤となりうる 81。

効率的な注意機構

線形アテンションやスパースアテンションといった技術に関する調査は、Transformerの中核を根本的に再設計し、より効率的にするための大規模な研究努力を示している 26。これは、大規模で複雑な多段階推論を実現するための前提条件である。

LLM市場は、「パラダイムの成熟」サイクルを経験している。初期段階は「スケール」(パラメータ数、データ量)によって定義された。現在の段階は「記憶」(コンテキストウィンドウ)によって定義されている 15。しかし、このアプローチの限界は明らかになりつつある 66。推論に焦点を当てたベンチマークの登場 102 や、ルカンのような基礎研究者からの批判 92 は、次のシフトの始まりを告げている。勝利する企業は、単により多くを「記憶」できるモデルではなく、より効率的に「思考」できるモデル、すなわちドルあたり、あるいはワットあたりの複雑な問題解決能力で優れるモデルを最初に開発した企業となるだろう。

この競争における究極的な参入障壁は、コンテキストサイズのような単一の能力ではない。それは、自己改善の「フライホイール(好循環)」の創出にある。優れた推論能力を持つモデルは、より高品質な合成データを生成することができる。競技レベルのベンチマークで試されるような 103、新規性の高い複雑な問題を解決する能力は、高品質で新しい推論の軌跡を生成する能力の代理指標となる。優れた推論モデルを持つ企業は、それを用いて膨大な量の高品質な合成「思考プロセス」データを生成できる。このデータは、単にインターネットからより多くの情報をスクレイピングするよりもはるかに価値が高い。これがフィードバックループを生み出す。より優れた推論モデルが、より優れた訓練データを作り出し、それがさらに優れた推論モデルを生み出す。この、中核となる推論エンジンによって駆動されるデータ生成のフライホイールこそが、競合他社が必然的に追いつくであろうコンテキストウィンドウのサイズよりも、はるかに持続可能な競争優位性となるのである。

7. 戦略的展望:LLM競争環境の航海術

本レポートの分析を総括し、ユーザーの当初の仮説に対する最終的な結論を提示するとともに、主要なステークホルダーに対する実践的な提言を行う。

7.1. 最終評決:コンテキストは重要だが、決定的ではない

コンテキストウィンドウは、最先端のLLMが備えるべき「最低条件(table-stakes)」であり、基盤となる能力である。大きく、かつ効果的なコンテキストウィンドウは、新たなクラスの強力なアプリケーションを解放するために競争上不可欠である。しかし、それ自体が市場リーダーシップを保証する十分条件ではない。

長期的な成功を決定づける真の差別化要因は、以下の要素の組み合わせとなるだろう。

- 中核的な推論能力: 複雑で新規性の高いタスクにおける性能によって測定される。

- 計算効率: より低いコストとレイテンシで高性能を提供できる能力。これは、広範な企業導入の鍵となる。

- アーキテクチャの革新: 現行のTransformerモデルの限界を超えるブレークスルー。

- 信頼性と信用: ハルシネーションを最小限に抑え、検証可能で根拠のある応答を提供する能力。この点において、RAGのような技術は引き続き重要な役割を果たす。

コンテキストウィンドウをめぐる競争は、LLMの能力を新たな段階へと押し上げた。しかし、その競争が終結に近づくにつれ、戦場はより難解で、より本質的な領域、すなわち「推論」へと移行している。記憶の広さではなく、思考の深さが、次世代のAIの覇者を決定づけるだろう。

7.2. 企業導入担当者への提言

- 誇大広告の先を見据える: 公称のコンテキストウィンドウサイズのみを基準にモデルを選定してはならない。自社の特定のユースケースで厳格な評価を実施し、特にコンテキストの中間に位置する情報を扱う推論タスクにおける「実効コンテキスト長」と性能に注意を払うべきである。

- ハイブリッドアーキテクチャを採用する: 単一のアプローチに賭けるのではなく、ネイティブな長コンテキストとRAGの両方を柔軟に活用できるシステムを設計すること。スケーラビリティ、データの鮮度、コスト管理のためにはRAGを、厳選された文書群に対する全体論的な統合分析が求められるタスクには長コンテキストを使用するなど、使い分けが重要である。

- トークンではなくROIに最適化する: 目標は、可能な限り大きなコンテキストウィンドウを使用することではなく、ビジネス上の問題を解決するために必要な「最小限の効果的な」ウィンドウを使用することである。これには、慎重なプロンプトエンジニアリングと、長コンテキストクエリの高いコストと性能とのバランスを取るという視点が不可欠である。

7.3. 投資家およびイノベーターへの提言

- 単なる記憶ではなく、推論に投資する: 次の大きなブレークスルーは、単に記憶容量を拡大するのではなく、モデルの基本的な推論能力と計画能力を向上させることに注力する企業や研究室から生まれるだろう。単純な検索を超えた、新しいアーキテクチャや評価手法に取り組むチームに注目すべきである。

- 「効率性のフロンティア」に焦点を当てる: より少ない計算量で最先端の性能を提供できる能力は、巨大な競争優位性となる。新しい注意機構、モデル圧縮、特殊なハードウェアなど、推論の効率を向上させる技術に投資することが賢明である。

- ハイブリッド時代の「つるはしとシャベル」: RAGとLCの融合は、インフラストラクチャおよびツーリング企業に新たな機会を創出する。最も価値のあるプラットフォームは、データ検索、コンテキスト管理、モデルとの対話をシームレスに統合し、高度なハイブリッドAIアプリケーションの開発を簡素化するものになるだろう。

引用文献

- www.ibm.com https://www.ibm.com/jp-ja/think/topics/context-window#:~:text=%E5%A4%A7%E8%A6%8F%E6%A8%A1%E8%A8%80%E8%AA%9E%E3%83%A2%E3%83%87%E3%83%AB%EF%BC%88LLM,%E7%B5%84%E3%81%BF%E8%BE%BC%E3%82%80%E3%81%93%E3%81%A8%E3%81%8C%E3%81%A7%E3%81%8D%E3%81%BE%E3%81%99%E3%80%82

- コンテキスト・ウィンドウとは? – IBM https://www.ibm.com/jp-ja/think/topics/context-window

- AIモデルのコンテキストウィンドウとは – Appen https://appen.co.jp/blogs/context-windows

- AIのコンテキストウィンドウについて調べてみた – Qiita https://qiita.com/akiraarika932/items/03fec9410c26523239cb

- What is a context window? – IBM https://www.ibm.com/think/topics/context-window

- What is a context window for Large Language Models? – McKinsey https://www.mckinsey.com/featured-insights/mckinsey-explainers/what-is-a-context-window

- LLM Context Windows: Basics, Examples & Prompting Best Practices – Swimm https://swimm.io/learn/large-language-models/llm-context-windows-basics-examples-and-prompting-best-practices

- コンテキストウィンドウとは何か?生成AIを業務で活用するために知っておくべき基本と設計術 https://note.com/locoassi/n/ncd13a6394e2f

- LLM Context Windows: Why They Matter and 5 Solutions for Context Limits – Kolena https://www.kolena.com/guides/llm-context-windows-why-they-matter-and-5-solutions-for-context-limits/

- Understanding LLM Context Windows: Tokens, Attention, and Challenges | by Tahir | Medium https://medium.com/@tahirbalarabe2/understanding-llm-context-windows-tokens-attention-and-challenges-c98e140f174d

- コンテキストウィンドウとは何か?グーグルとメタが本気、生成AI「強化」のカギ? – ビジネス+IT https://www.sbbit.jp/article/cont1/142381

- What is a context window—and why does it matter? – Zapier https://zapier.com/blog/context-window/

- Long-Context Windows in Large Language Models: Applications in Comprehension and Code | by Adnan Masood, PhD. | Medium https://medium.com/@adnanmasood/long-context-windows-in-large-language-models-applications-in-comprehension-and-code-03bf4027066f

- 生成AIサービスをコンテキストウィンドウ(記憶力)から比較する – Zenn https://zenn.dev/chameleonmeme/articles/989ccef3027419

- Why larger LLM context windows are all the rage – IBM Research https://research.ibm.com/blog/larger-context-window

- コンテキストウィンドウ | 株式会社SHIFT https://service.shiftinc.jp/ai-terminology/context-window/

- Understanding the Impact of Increasing LLM Context Windows – Meibel https://www.meibel.ai/post/understanding-the-impact-of-increasing-llm-context-windows

- LLMs now accept longer inputs, and the best models can use them more effectively | Epoch AI https://epoch.ai/data-insights/context-windows

- What is a long context window? Google DeepMind engineers explain https://blog.google/technology/ai/long-context-window-ai-models/

- Anthropic’s Claude Sonnet 4 Model Gets a 1M Token Context Window – The New Stack https://thenewstack.io/anthropics-claude-sonnet-4-model-gets-a-1m-token-context-window/

- コンテキストウィンドウ – Anthropic API https://docs.anthropic.com/ja/docs/build-with-claude/context-windows

- Context Window Size and Language Model Performance: Balancing Act | by Sagar Patil https://ai.plainenglish.io/context-window-size-and-language-model-performance-balancing-act-2ae2964e3ec1

- RAG vs Large Context Window LLMs: When to use which one? – The Cloud Girl https://www.thecloudgirl.dev/blog/rag-vs-large-context-window

- How Does The Context Window Size Affect LLM Performance? – Deepchecks https://www.deepchecks.com/question/how-does-context-window-size-affect-llm-performance/

- Context Length in LLMs: What Is It and Why It Is Important – DataNorth AI https://datanorth.ai/blog/context-length

- Xnhyacinth/Awesome-LLM-Long-Context-Modeling: Must-read papers and blogs on LLM based Long Context Modeling – GitHub https://github.com/Xnhyacinth/Awesome-LLM-Long-Context-Modeling

- Long-context LLMs Struggle with Long In-context Learning – arXiv https://arxiv.org/html/2404.02060v1

- Efficient Attention Mechanisms for Large Language Models … – arXiv http://arxiv.org/abs/2507.19595

- GPT-4o vs. Gemini 1.5 Pro vs. Claude 3 Opus: Multimodal AI Model Comparison – Encord https://encord.com/blog/gpt-4o-vs-gemini-vs-claude-3-opus/

- Long context | Generative AI on Vertex AI – Google Cloud https://cloud.google.com/vertex-ai/generative-ai/docs/long-context

- Long context | Gemini API | Google AI for Developers https://ai.google.dev/gemini-api/docs/long-context

- What is long context and why does it matter for AI? | Google Cloud Blog https://cloud.google.com/transform/the-prompt-what-are-long-context-windows-and-why-do-they-matter

- GPT 4-o Mini vs Claude 3 Haiku vs Gemini 1.5 Flash: Small Language Model Pricing Considerations – Vantage https://www.vantage.sh/blog/gpt-4o-small-vs-gemini-1-5-flash-vs-claude-3-haiku-cost

- GPT-4 Turbo vs. Claude 3 Opus vs. Google Gemini 1.5 Pro – Kommunicate https://www.kommunicate.io/blog/gpt4-vs-claude-3-vs-gemini/

- GPT vs Claude vs Gemini: Comparing LLMs – Nu10 https://nu10.co/gpt-vs-claude-vs-gemini-comparing-llms/

- Model – OpenAI API https://platform.openai.com/docs/models/gpt-4o-mini

- Azure OpenAI in Azure AI Foundry Models – Microsoft Learn https://learn.microsoft.com/en-us/azure/ai-foundry/openai/concepts/models

- JonathanChavezTamales/llm-leaderboard: A comprehensive set of LLM benchmark scores and provider prices. – GitHub https://github.com/JonathanChavezTamales/llm-leaderboard

- Context windows – Anthropic API https://docs.anthropic.com/en/docs/build-with-claude/context-windows

- Anthropic’s Claude in Amazon Bedrock – AWS https://aws.amazon.com/bedrock/anthropic/

- Claude (language model) – Wikipedia https://en.wikipedia.org/wiki/Claude_(language_model)

- Claude 3 context window is a big deal : r/singularity – Reddit https://www.reddit.com/r/singularity/comments/1b6e0id/claude_3_context_window_is_a_big_deal/

- Long Context RAG Performance of LLMs | Databricks Blog https://www.databricks.com/blog/long-context-rag-performance-llms

- Open LLM Leaderboard 2025 – Vellum AI https://www.vellum.ai/open-llm-leaderboard

- NoLiMa: Long-Context Evaluation Beyond Literal Matching – Finally a good benchmark that shows just how bad LLM performance is at long context. Massive drop at just 32k context for all models. – Reddit https://www.reddit.com/r/LocalLLaMA/comments/1io3hn2/nolima_longcontext_evaluation_beyond_literal/

- Which LLM is right for you? The answer is clear: it depends. – Proxet https://www.proxet.com/blog/which-llm-is-right-for-you-the-answer-is-clear-it-depends

- LLMs with largest context windows – Codingscape https://codingscape.com/blog/llms-with-largest-context-windows

- LLM Leaderboard 2025 – Vellum AI https://www.vellum.ai/llm-leaderboard

- LLM評価データセット概観|sharp_engineer – note https://note.com/sharp_engineer/n/n7b9e966bf377

- LLMにまつわる”評価”を整理する – Zenn https://zenn.dev/gaudiy_blog/articles/dd0010601b3136

- Navigating LLM Leaderboards: An Overview of LLM Benchmark Evaluations – Arize AI https://arize.com/blog-course/llm-leaderboards-benchmarks/

- 20 LLM evaluation benchmarks and how they work – Evidently AI https://www.evidentlyai.com/llm-guide/llm-benchmarks

- Demystifying LLM Leaderboards: What You Need to Know | Shakudo https://www.shakudo.io/blog/demystifying-llm-leaderboards-what-you-need-to-know

- HERA: Improving Long Document Summarization using Large Language Models with Context Packaging and Reordering – arXiv https://arxiv.org/html/2502.00448v1

- On Context Utilization in Summarization with Large Language Models – arXiv https://arxiv.org/html/2310.10570v3

- Document Summarization Using LLM: Complete AI Guide 2025 – Future AGI https://futureagi.com/blogs/revolutionizing-document-management-llm-2025

- Master LLM Summarization Strategies and their Implementations – Galileo AI https://galileo.ai/blog/llm-summarization-strategies

- Leave No Document Behind: Benchmarking Long-Context LLMs with Extended Multi-Doc QA – ACL Anthology https://aclanthology.org/2024.emnlp-main.322/

- Evaluating Long-Context Question & Answer Systems – Eugene Yan https://eugeneyan.com/writing/qa-evals/

- CuriousLLM: Elevating Multi-Document Question Answering with LLM-Enhanced Knowledge Graph Reasoning – ACL Anthology https://aclanthology.org/2025.naacl-industry.23.pdf

- Loong: Benchmarking Long-Context LLMs with Extended Multi-Doc QA – GitHub https://github.com/MozerWang/Loong

- Large Language Models (LLMs) for Source Code Analysis: applications, models and datasets – arXiv https://arxiv.org/html/2503.17502v1

- RepoQA: Evaluating Long Context Code Understanding – arXiv https://arxiv.org/html/2406.06025v1

- Hello GPT-4o – OpenAI https://openai.com/index/hello-gpt-4o/

- Context Rot: How Increasing Input Tokens Impacts LLM Performance | Chroma Research https://research.trychroma.com/context-rot

- Evaluating Long Context Lengths in LLMs: Challenges and Benchmarks | by Onn Yun Hui https://medium.com/@onnyunhui/evaluating-long-context-lengths-in-llms-challenges-and-benchmarks-ef77a220d34d

- Context-Engineering Challenges & Best-Practices | by Ali Arsanjani | Jul, 2025 | Medium https://dr-arsanjani.medium.com/context-engineering-challenges-best-practices-8e4b5252f94f

- Lost-in-the-Middle Effect | LLM Knowledge Base – Promptmetheus https://promptmetheus.com/resources/llm-knowledge-base/lost-in-the-middle-effect

- Overcome Lost In Middle Phenomenon In RAG Using LongContextRetriver – AI Planet https://medium.aiplanet.com/overcome-lost-in-middle-phenomenon-in-rag-using-longcontextretriver-2334dc022f0e

- Lost in the Middle: How Language Models Use Long Contexts – CS Stanford https://cs.stanford.edu/~nfliu/papers/lost-in-the-middle.arxiv2023.pdf

- Found in the Middle: How Language Models Use Long Contexts Better via Plug-and-Play Positional Encoding – arXiv https://arxiv.org/html/2403.04797v1

- Lost in the Middle: How Language Models Use Long Contexts – ResearchGate https://www.researchgate.net/publication/372162904_Lost_in_the_Middle_How_Language_Models_Use_Long_Contexts

- Never Lost in the Middle: Mastering Long-Context Question Answering with Position-Agnostic Decompositional Training – arXiv https://arxiv.org/html/2311.09198v2

- Do LLM’s get “lost in the middle” during summarization as well? [D] : r/MachineLearning https://www.reddit.com/r/MachineLearning/comments/1beb7vi/do_llms_get_lost_in_the_middle_during/

- Long-context LLMs Struggle with Long In-context Learning – arXiv https://arxiv.org/html/2404.02060v2

- Leave No Document Behind: Benchmarking Long-Context LLMs with Extended Multi-Doc QA – arXiv https://arxiv.org/html/2406.17419v2

- Unlocking the Effective Context Length: Benchmarking the Granite-3.1-8b Model – Red Hat https://www.redhat.com/en/blog/unlocking-effective-context-length-benchmarking-granite-31-8b-model

- Why Does the Effective Context Length of LLMs Fall Short? – arXiv https://arxiv.org/html/2410.18745v1

- LLM Maybe LongLM: Self-Extend LLM Context Window Without Tuning – arXiv https://arxiv.org/html/2401.01325v1

- How does having a very long context window impact performance? : r/LocalLLaMA – Reddit https://www.reddit.com/r/LocalLLaMA/comments/1lxuu5m/how_does_having_a_very_long_context_window_impact/

- InfiniPot: Infinite Context Processing on Memory-Constrained LLMs – arXiv https://arxiv.org/html/2410.01518v1

- How do RAG and Long Context compare in 2024? – Vellum AI https://www.vellum.ai/blog/rag-vs-long-context

- RAG and Long-Context Windows: Why You need Both | by Allan Alfonso | Google Cloud https://medium.com/google-cloud/rag-and-long-context-windows-why-you-need-both-1b75cf4509d9

- 【論文瞬読】長文コンテキスト理解におけるRAGとLLMの比較とハイブリッドアプローチSELF-ROUTEの提案|AI Nest – note https://note.com/ainest/n/n421e51403bb1

- [2407.16833] Retrieval Augmented Generation or Long-Context LLMs? A Comprehensive Study and Hybrid Approach – arXiv https://arxiv.org/abs/2407.16833

- RAG vs. Long-context LLMs – SuperAnnotate https://www.superannotate.com/blog/rag-vs-long-context-llms

- [2502.09977] LaRA: Benchmarking Retrieval-Augmented Generation and Long-Context LLMs — No Silver Bullet for LC or RAG Routing – arXiv https://arxiv.org/abs/2502.09977

- Long Context vs. RAG for LLMs: An Evaluation and Revisits – arXiv https://arxiv.org/html/2501.01880v1

- [2409.01666] In Defense of RAG in the Era of Long-Context Language Models – arXiv https://arxiv.org/abs/2409.01666

- LaRA: Benchmarking Retrieval-Augmented Generation and Long-Context LLMs – No Silver Bullet for LC or RAG Routing – arXiv https://arxiv.org/html/2502.09977v1

- Long-Context LLMs vs RAG: Who Will Win? – YouTube https://www.youtube.com/watch?v=-xcS9ByiJEo

- Yann LeCun, Pioneer of AI, Thinks Today’s LLM’s Are Nearly Obsolete – Newsweek https://www.newsweek.com/ai-impact-interview-yann-lecun-artificial-intelligence-2054237

- LeCun: “If you are interested in human-level AI, don’t work on LLMs.” : r/agi – Reddit https://www.reddit.com/r/agi/comments/1imqson/lecun_if_you_are_interested_in_humanlevel_ai_dont/

- Ask HN: Any insider takes on Yann LeCun’s push against current architectures? https://news.ycombinator.com/item?id=43325049

- Contra LeCun on “Autoregressive LLMs are doomed” – LessWrong https://www.lesswrong.com/posts/zyPaqXgFzqHkQfccq/contra-lecun-on-autoregressive-llms-are-doomed

- Geoffrey Hinton says “people understand very little about how LLMs actually work, so they still think LLMs are very different from us. But actually, it’s very important for people to understand that they’re very like us.” LLMs don’t just generate words, but also meaning. : r/singularity – Reddit https://www.reddit.com/r/singularity/comments/1lbbg0x/geoffrey_hinton_says_people_understand_very/

- Geoffrey Hinton says people understand very little about how LLMs actually work, so they still think LLMs are very different from us – “but actually, it’s very important for people to understand that they’re very like us.” LLMs don’t just generate words, but also meaning. : r/OpenAI – Reddit https://www.reddit.com/r/OpenAI/comments/1lbbh1b/geoffrey_hinton_says_people_understand_very/

- Geoffrey Hinton Sounds Alarm on AI Creating Its Own Language and Outmaneuvering Humans | by Coby Mendoza – Artificial Intelligence in Plain English https://ai.plainenglish.io/geoffrey-hinton-sounds-alarm-on-ai-creating-its-own-language-and-outmaneuvering-humans-5ea253ae18b6

- The Dangers of AI According to Hinton at TechWeek Toronto – Object First https://objectfirst.com/blog/techweek-toronto-hinton-on-the-dangers-of-ai/

- Are LLMs thinking? What Geoffrey Hinton thinks | by Sepp Ruchti – Medium https://medium.com/@sepp.ruchti/are-llms-thinking-what-geoffrey-hinton-thinks-3dc12f5dffd6

- Large Language Model Limitations: Why Generative AI Still Has a Long Way to Go, Researchers Say – Tech Times https://www.techtimes.com/articles/308157/20241105/large-language-model-limitations-why-generative-ai-still-has-long-way-go-researchers-say.htm

- Learning to reason with LLMs | OpenAI https://openai.com/index/learning-to-reason-with-llms/

- Competition-Level Problems are Effective LLM Evaluators – ACL Anthology https://aclanthology.org/anthology-files/anthology-files/pdf/findings/2024.findings-acl.803.pdf

- Competition-Level Problems are Effective LLM Evaluators – arXiv https://arxiv.org/html/2312.02143v3

- Evaluating the Performance of Large Language Models in Competitive Programming: A Multi-Year, Multi-Grade Analysis – arXiv https://arxiv.org/html/2409.09054v1

- GSM-∞: How Do Your LLMs Behave over Infinitely Increasing Context Length and Reasoning Complexity? – arXiv https://arxiv.org/html/2502.05252v1

- The Impact of Reasoning Step Length on Large Language Models – arXiv https://arxiv.org/html/2401.04925v3

- Is Chain-of-Thought Reasoning of LLMs a Mirage? A Data Distribution Lens | Hacker News https://news.ycombinator.com/item?id=44872850

- The Future of LLMs: Predictions and Emerging Trends | by Rizqi Mulki | Medium https://medium.com/@rizqimulkisrc/llthe-future-of-llms-predictions-and-emerging-trends-72bb58f7aa30

- [2504.01707] InfiniteICL: Breaking the Limit of Context Window Size via Long Short-term Memory Transformation – arXiv https://arxiv.org/abs/2504.01707

- Infinite Retrieval: Attention Enhanced LLMs in Long-Context Processing – arXiv https://arxiv.org/html/2502.12962v1

- Infinite context windows from Google research?! : r/machinelearningnews – Reddit https://www.reddit.com/r/machinelearningnews/comments/1c45o24/infinite_context_windows_from_google_research/

- Leave No Context Behind: Efficient Infinite Context Transformers with Infini-attention – arXiv https://arxiv.org/html/2404.07143v1